¿Como te suena la idea de que las máquinas aprendan por si mismas y realicen tareas complejas? ¿ Te intrigan las aplicaciones del machine learning? (ML) Pero al mismo tiempo te sientes intimidado por la complejidad del tema y la cantidad de información disponible?

Imagina un universo donde las maquinas no solo procesan datos, sino que también aprenden de ellos. Este es el fascinante mundo del machine learning, donde algoritmos ocultos revelan patrones invisibles y hacen predicciones asombrosas. La creciente relevancia del machine learning es como un susurro en la oscuridad, prometiendo un futuro donde las máquinas pueden anticipar nuestras necesidades y superar los límites de lo imaginable.

La Inteligencia Artificial evoluciona a pasos agigantados, siendo actualmente una de las ciencias más complejas. Cuando nos referimos a complejidad, no hablamos del nivel de dificultad para comprender e innovar (aunque ciertamente en este caso es bastante alto), sino que nos referimos al grado de interrelación con otros campos aparentemente desconectados y aquí es donde entra la importancia del machine learning.

¿Qué es el machine learning?

Inteligencia artificial y machine learning son conceptos que van cogidos de la mano. El machine learning es una parte de la inteligencia artificial que se encarga de que las máquinas aprendan. Una de las características más importante es que se puede hacer que aprendan sin que estén expresamente programadas para ello. Fundamentalmente el machine learning es muy útil para que las máquinas sean capaces de identificar patrones.

La importancia de esta tecnología queda de manifiesto al observar la cantidad de grandes empresas tecnológicas que ofrecen servicios de IA y machine learning como por ejemplo AWS Machine Learning o Machine Learning Google. También la gran cantidad de formaciones sobre esta materia que están surgiendo en todas las plataformas como los cursos de Coursera Machine Learning.

Las escuelas de pensamiento en machine learning

Hay dos “escuelas” de pensamiento sobre cómo una IA debe ser construida de forma apropiada:

- Los Coneccionistas: parten del supuesto de que debemos inspirarnos en las redes neuronales del cerebro humano.

- Los Simbolistas: prefieren moverse de los bancos de conocimiento y las reglas fijas sobre cómo funciona el mundo.

Además, esta diferente manera de ver las cosas, está haciendo que se lleven a cabo estrategias de resolución de problemas totalmente diferentes: se puede resolver un problema a través de un algoritmo más simple, que aumenta su precisión en el tiempo (enfoque de iteración), o se puede dividir el problema en bloques cada vez más pequeños (enfoque de descomposición secuencial paralela).

Hasta la fecha, no hay una respuesta clara sobre qué enfoque o escuela de pensamiento funciona mejor, por lo que lo mejor es discutir brevemente los principales avances tanto en las técnicas de aprendizaje puro de la máquina como en la neurociencia con una lente agnóstica.

Aprendizaje de la máquina

Las técnicas de aprendizaje automático pueden dividirse a grandes rasgos en métodos supervisados y métodos no supervisados, con la principal diferencia de si los datos están etiquetados (aprendizaje supervisado) o no (no supervisado). Una tercera clase puede ser introducida cuando hablamos de IA: aprendizaje de refuerzo (RL).

El RL es un método de aprendizaje para máquinas basado en la simple idea de la retroalimentación de recompensas: la máquina actúa de hecho en un conjunto específico de circunstancias con el objetivo de maximizar la recompensa potencial futura (acumulativa). En otras palabras, es un método intermedio de ensayo y error entre el aprendizaje supervisado y el no supervisado.

La LR suele venir acompañada de dos problemas importantes, a saber, el problema de la asignación de créditos y el dilema de exploración y explotación, además de una serie de cuestiones técnicas como la maldición de la dimensionalidad, los entornos no estacionarios o la observabilidad parcial del problema.

El primero se refiere al hecho de que las recompensas son, por definición, retrasadas, y puede ser que se necesite una serie de acciones específicas para lograr su objetivo. El problema consiste entonces en identificar cuál de las acciones precedentes fue realmente responsable del resultado final (y obtener la recompensa entonces), y en caso afirmativo en qué medida. Este último problema es, en cambio, un problema de búsqueda óptima: el software debe cartografiar el entorno con la mayor precisión posible para averiguar su estructura de recompensa. Existe un problema de parada óptima, una especie de satisfacción en efecto: ¿hasta qué punto el agente debe seguir explorando el espacio para buscar mejores estrategias, o empezar a explotar las que ya conoce (y sabe que funcionan)?

Además, los algoritmos de aprendizaje automático pueden clasificarse en función de los resultados que producen: algoritmos de clasificación; regresiones; métodos de agrupación; estimación de la densidad; y métodos de reducción de la dimensionalidad.

Neurociencia en machine learning. Deep learning vs machine learning

La arquitectura estándar de cualquier SNNA consiste en tener una serie de nodos dispuestos en una capa de entrada, una capa de salida y un número variable de capas ocultas (que caracterizan la profundidad de la red). Las entradas de cada capa se multiplican por un cierto peso de conexión y se suman, para ser comparadas con un nivel de umbral. La señal obtenida a través de la suma se pasa a una función de transferencia, para producir una señal de salida que, a su vez, se pasa como entrada a la capa siguiente. El aprendizaje se produce en las múltiples iteraciones de este proceso, y se calcula cuantitativamente eligiendo los factores de ponderación que minimizan el error de mapeo de entrada-salida dado un determinado conjunto de datos de entrenamiento.

A menudo también se las denomina Aprendizaje Profundo (AD), sobre todo en los casos en los que hay muchas capas que realicen tareas de cálculo. Existen muchos tipos de RNA hasta la fecha, pero las más conocidas son las Redes Neuronales Recurrentes (RNN).

Las redes neuronales artificiales son un enfoque de inspiración biológica que permite al software aprender de los datos de observación – en este sentido a veces se dice que imitan el cerebro humano. La primera RNA denominada Unidad Lógica de Umbral (TLU) fue introducida en los años cuarenta por McCulloch y Pitts (1943), y posteriormente, cuarenta años más tarde Rumelhart y otros (1986) impulsaron el campo diseñando el algoritmo de entrenamiento de retropropagación para los perceptrones multicapa (MLP) de avance.

Las RNNs usan información secuencial para hacer predicciones precisas. En las RNA tradicionales, todas las entradas son independientes unas de otras. Las RNN realizan en cambio una determinada tarea para cada elemento de la secuencia, manteniendo una especie de memoria de los cálculos anteriores.

Lo cierto es que el DL es, sin duda, un gran paso adelante hacia la creación de un AGI, pero también tiene algunas limitaciones. La fundamental es la excepcional cantidad de datos necesarios para trabajar correctamente, lo que representa la mayor barrera para una aplicación transversal más amplia. La DL tampoco es fácil de depurar, y por lo general, los problemas se resuelven alimentando más y más datos en la red, lo que crea una gran dependencia hacia los datos.

La necesidad de datos va a suponer una considerable cantidad de tiempo para entrenar una red. Para poder optimizar tiempos, las redes suelen entrenarse en paralelo, ya sea dividiendo el modelo entre diferentes máquinas en diferentes tarjetas GPU o en diferentes cubos de datos a través del mismo modelo ejecutado en diferentes máquinas para poder ajustar los parámetros.

¿El machine learning reemplazara mi trabajo?

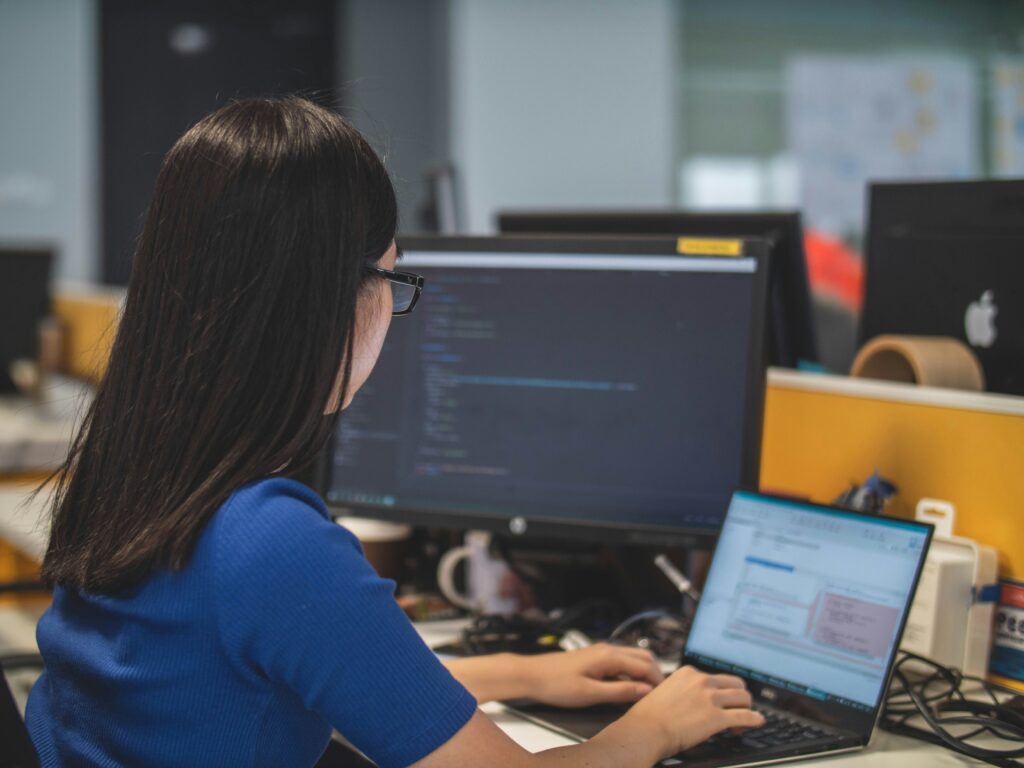

El impacto del machine learning en el empleo es un tema que genera curiosidad y, a veces, un poco de preocupación. Sin embargo en lugar de ser algo que nos quite los trabajos, el machine learning está transformando la forma en que trabajamos. Por ejemplo, en lugar de reemplazar a los trabajadores, puede ser utilizado para automatizar tareas repetitivas y monótonas, liberándonos para enfocarnos en trabajos más creativos y estratégicos.

Además, el machine learning también está creando nuevas oportunidades de empleo en áreas como la ciencia de datos, la ingeniería de machine learning y la analítica de datos. Estas son áreas en las que la demanda de talento especializado está creciendo rápidamente. Por lo tanto, aprender habilidades en machine learning puede abrir nuevas puertas y ampliar nuestras oportunidades laborales.