Modernizar no es rehacer. Es intervenir con precisión quirúrgica en arquitecturas que no pueden detenerse. Ese es el verdadero reto cuando hablamos de aplicar inteligencia artificial en entornos legacy: habilitar capacidades cognitivas sobre infraestructuras que fueron diseñadas con lógicas, lenguajes y dependencias propias de otra época, pero que hoy siguen soportando el core operativo de muchas organizaciones.

En contra de la narrativa habitual, la mayoría de los sistemas críticos en producción no han sido desarrollados bajo paradigmas cloud-native ni en arquitecturas desacopladas. Son plataformas monolíticas, de alto acoplamiento funcional, mantenidas con esfuerzo por equipos cada vez más reducidos y con escasa disponibilidad de conocimiento técnico interno. Pretender sustituirlos por completo no es sólo costoso: es estratégicamente inviable en la mayoría de los casos.

Aquí es donde un enfoque basado en microservicios y middleware de inteligencia artificial aporta una alternativa sólida. No para romper lo existente, sino para extenderlo. A través del encapsulamiento funcional, la exposición controlada vía APIs, la integración de agentes inteligentes y la orquestación de decisiones automatizadas, es posible inyectar IA en sistemas heredados sin modificar su lógica interna ni comprometer su estabilidad.

Este enfoque no solo preserva el legado: lo hace operable, ampliable y alineado con las exigencias actuales en eficiencia, trazabilidad y adaptabilidad. A lo largo de este análisis técnico, explicaremos cómo diseñar esa capa de interoperabilidad inteligente y qué herramientas (como arquitecturas basadas en microservicios o soluciones middleware como SofIA) permiten escalar este modelo con garantías.

¿Qué son los microservicios y por qué son clave en entornos legacy?

En términos arquitectónicos, un microservicio es una unidad funcional autónoma, desplegable de forma independiente, que realiza una función específica dentro de un sistema distribuido. Se comunica con otras unidades mediante interfaces bien definidas (habitualmente APIs REST o mensajería asincrónica) y se gestiona de forma desacoplada.

A diferencia de los sistemas monolíticos, los microservicios permiten:

- Diseñar funcionalidades aisladas, sin dependencias internas rígidas.

- Escalar individualmente cada componente según su demanda.

- Actualizar y desplegar servicios sin afectar al resto del sistema.

Microservicios como estrategia de contención para sistemas legacy

En entornos heredados, la arquitectura monolítica presenta una serie de restricciones técnicas: acoplamiento estructural, dependencias internas no documentadas, y alta fragilidad ante cambios. Aquí es donde los microservicios se posicionan como una arquitectura de contención controlada, permitiendo intervenir sin modificar el código legado.

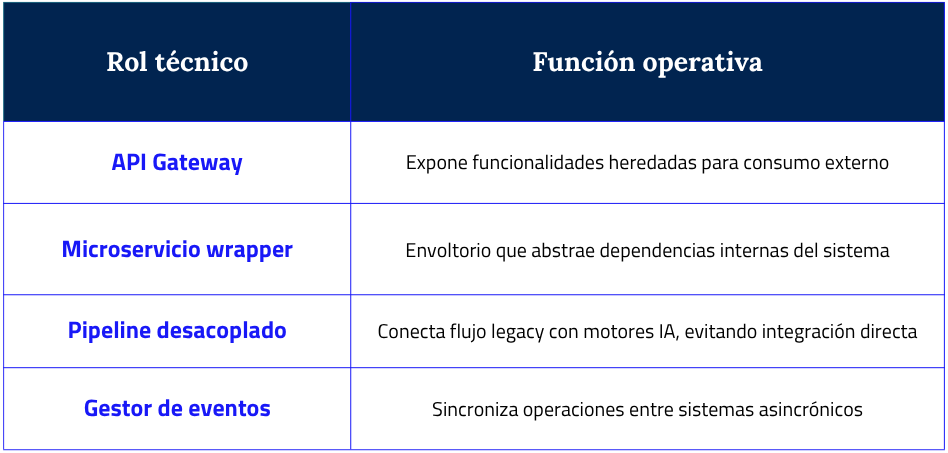

Funciones clave que cumplen los microservicios en entornos legacy:

- Encapsulamiento de funcionalidad crítica: exponen módulos del legacy como endpoints accesibles, sin alterar su lógica interna.

- Aislamiento del sistema heredado: minimizan el riesgo operativo al mantener el core intacto.

- Interoperabilidad estructurada: facilitan la integración con capas modernas (frontends, orquestadores, IA, RPA).

- Observabilidad periférica: permiten implementar trazabilidad y métricas externas a sistemas que no fueron diseñados para ser auditables.

Visión estratégica: microservicios como prerrequisito de escalabilidad IA

El uso de microservicios no es un capricho arquitectónico, sino un requisito técnico para desplegar capacidades cognitivas sobre entornos heterogéneos. Muchas de las organizaciones que integran IA sobre sistemas legacy adoptan arquitecturas orientadas a servicios (SOA/Microservicios) como patrón de transición.

En conjunto, estos componentes definen una arquitectura orientada a la interoperabilidad progresiva, donde la IA no se superpone al legacy, sino que lo complementa desde capas desacopladas, seguras y trazables. Esta aproximación permite preservar la lógica de negocio existente mientras se habilitan nuevos flujos de decisión, automatización e inferencia, sin necesidad de reescribir el core ni comprometer la estabilidad transaccional del sistema original.

El reto real: la sombra del código legacy en las organizaciones

El término legacy se utiliza con frecuencia para describir sistemas heredados, pero en contextos corporativos implica mucho más que tecnología obsoleta. En la práctica, hablamos de plataformas críticas que sostienen procesos operativos centrales y que, por su nivel de integración y dependencia, no pueden ser modificadas sin comprometer la continuidad del negocio.

Características técnicas comunes del legacy

La mayoría de estos entornos comparten ciertos rasgos estructurales que explican su complejidad operativa:

- Lenguajes de programación obsoletos, como COBOL, RPG o PL/1, mantenidos por perfiles altamente especializados —y en muchos casos, en proceso de jubilación.

- Bajo nivel de documentación funcional y técnica, lo que impide comprender la lógica de negocio embebida en el código.

- Altísimo acoplamiento entre capas, lo que hace que una modificación menor dispare efectos colaterales no previstos.

Ausencia de APIs o mecanismos estandarizados de integración, dificultando su conexión con nuevos sistemas, modelos de IA o herramientas de automatización.

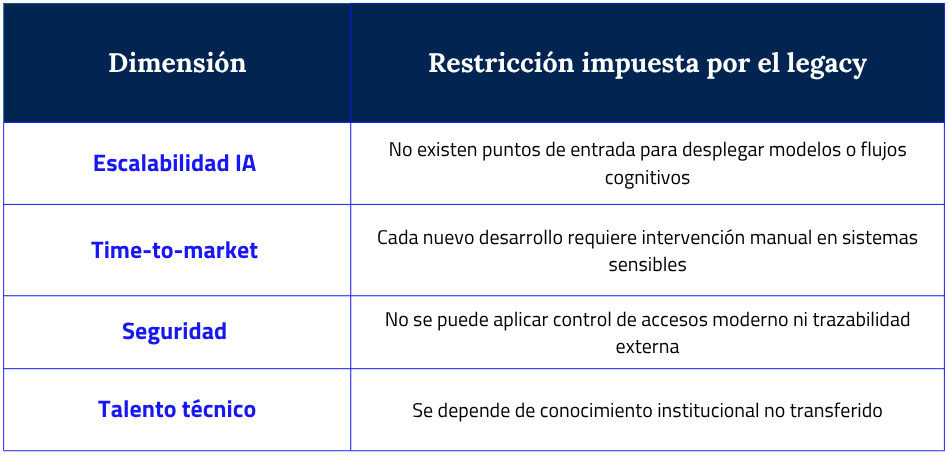

Impacto técnico-operativo real

Estas características no solo representan un reto de mantenimiento. Limitan directamente la capacidad de evolución tecnológica de la organización:

Lenguaje espejo: realidades que bloquean la transformación

Estas son expresiones de muchos responsables técnicos en sesiones de diagnóstico y planificación tecnológica:

- «No podemos cambiarlo sin romper algo que sigue funcionando.”

- “No hay nadie que entienda cómo está construido, y tocarlo sería asumir demasiado riesgo.”

- “No podemos escalar IA si el sistema no expone datos estructurados ni APIs.”

- “El problema no es la IA, es que no tenemos dónde conectarla sin pasar por un infierno técnico.”

Control responsable: lo que sí se puede hacer

Reconocer la complejidad del legacy no implica resignarse. Existen estrategias viables de intervención sin reconstrucción, orientadas a mantener control, trazabilidad y continuidad operativa:

- Encapsular lógica heredada en microservicios: se aísla el comportamiento crítico y se expone a través de interfaces auditables, sin alterar el core.

- Usar middleware con capacidades de gobernanza: la integración se realiza desde capas externas con control de versiones, logs estructurados y reglas de intervención humana en casos ambiguos.

- Inyectar IA sobre la interfaz, no sobre el backend: tecnologías como RPA y agentes LLM pueden operar en la UI sin modificar el sistema subyacente.

IA como aliado para entornos legacy: dos caminos posibles

Integrar inteligencia artificial en sistemas heredados ya no es una utopía ni una tarea intrusiva. Hoy existen enfoques técnicos sólidos que permiten aprovechar la potencia de la IA sin comprometer la arquitectura existente, habilitando capacidades cognitivas sobre infraestructuras legacy con control, gobernanza y eficiencia.

En esta sección exploremos dos rutas viables y complementarias: la encapsulación de funciones mediante microservicios, y la inyección de IA directamente en la interfaz legacy a través de tecnologías RPA.

Microservicios y encapsulamiento como servicio

Enfoque: desacoplar sin romper

Consiste en aislar bloques funcionales del sistema legacy —sin modificarlos— y exponerlos como servicios accesibles vía API, gestionados desde una capa de microservicios. Sobre esta capa, se puede desplegar inteligencia artificial para interpretar, enriquecer o automatizar decisiones en tiempo real.

Aplicación técnica

- Encapsulamiento: se extrae una función del sistema legado (ej. cálculo de tarifas, validación de clientes) y se “empaqueta” como microservicio.

- Exposición: el microservicio se conecta mediante API Gateway a un orquestador o middleware externo.

- Orquestación con IA: la lógica AI (basada en modelos entrenados o agentes LLM) opera sobre los datos expuestos, toma decisiones o proporciona inferencias dentro del flujo transaccional.

Por ejemplo: un módulo de scoring crediticio en COBOL se encapsula y se expone vía REST. Un modelo de IA se encarga de enriquecer el scoring con variables externas, y el resultado se devuelve al core legacy sin intervención manual.

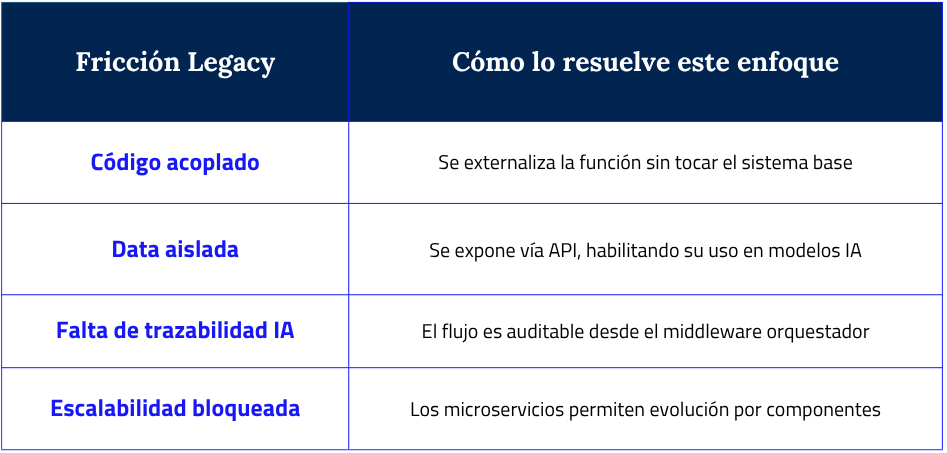

Mapa de fricciones resueltas

Esta matriz resume un principio clave en la modernización de entornos legacy: no se trata solo de añadir IA, sino de resolver condiciones estructurales que históricamente han bloqueado su despliegue. Al encapsular funciones mediante microservicios, es posible desacoplar sin desmontar, exponer sin comprometer y escalar sin reconstruir. Y lo más importante: cada integración puede auditarse, gobernarse y extenderse con lógica propia, sin romper el núcleo operativo que sigue sosteniendo el negocio.

Inyección de IA en interfaces legacy mediante RPA

En casos donde el sistema legacy no permite ni siquiera el acceso a nivel de lógica o base de datos, la alternativa es inyectar inteligencia directamente en la interfaz de usuario (UI), sin intervenir el código fuente. Esto se logra combinando RPA (automatización de procesos) con IA aplicada sobre la interfaz.

Aplicación técnica

- Interpretación de UI: bots RPA identifican campos, botones, validaciones o flujos visibles en pantalla.

- Procesamiento con IA: un agente cognitivo analiza la entrada/salida, realiza inferencias (ej. recomendaciones, verificaciones, predicciones) y completa la tarea sobre la misma interfaz.

- Output embebido: la IA se comporta como una “capa de inteligencia visual” que potencia al sistema sin modificar su arquitectura.

Por ejemplo, una aplicación de gestión comercial en entorno Win32 recibe una capa de IA que analiza formularios de alta de cliente, verifica la coherencia de los datos con un modelo entrenado y devuelve recomendaciones, todo sobre la misma UI.

Casos de uso reales

- Validaciones inteligentes de campos complejos.

- Recomendadores embebidos para decisiones humanas (pricing, aprobación, etc.).

- Verificación automática de cumplimiento normativo.

- Prevención de errores por inconsistencia de datos.

- Supervisión con IA de flujos críticos, sin alterar la lógica del core.

Ambos enfoques permiten intervenir entornos complejos con un criterio de control responsable, donde cada decisión técnica es trazable, reversible y alineada con el ritmo real de la organización. En lugar de transformar por ruptura, se habilita una modernización evolutiva, capaz de incorporar IA con sentido operativo, sin depender de reescrituras imposibles.

Middleware inteligente en entornos legacy: el caso de SofIA

Uno de los mayores desafíos en entornos legacy no es sólo técnico, sino estructural: ¿cómo introducir capacidades de IA sin alterar sistemas que siguen siendo críticos, pero que no fueron diseñados para convivir con modelos cognitivos distribuidos? Aquí es donde el middleware cobra un protagonismo esencial como pieza de control, interoperabilidad y gobernanza entre el core heredado y las capas inteligentes externas.

SofIA, nuestro middleware de inteligencia artificial, responde precisamente a esa necesidad: una plataforma de integración inteligente que permite desplegar IA en entornos híbridos (on-premise, cloud, ERPs, CRMs) sin tocar el código del sistema legacy. No actúa como un modelo, ni como un plugin; actúa como un cerebro orquestador entre capas.

Capacidades técnicas de SofIA como middleware en entornos legacy con microservicios

La integración de sistemas legacy con arquitecturas de microservicios no es solo una cuestión de conectividad, sino de orquestación, seguridad, interoperabilidad real y gobernanza de flujos inteligentes. En ese contexto, SofIA no actúa como una simple pasarela de datos, sino como un middleware operativo que habilita la coexistencia técnica entre plataformas dispares, sin necesidad de reconstrucción.

A continuación se detallan sus capacidades clave, orientadas a resolver fricciones comunes en entornos híbridos.

1. Integración no intrusiva

Antes: para modernizar una aplicación legacy, era necesario intervenir directamente en su código fuente, con los riesgos que ello implica: regresiones no controladas, interrupción del servicio, pérdida de lógica histórica.

Después con SofIA: el middleware actúa como capa externa, desplegable en servidores corporativos, que extrae funcionalidad sin modificar el core. Esto permite exponer lógica antigua como microservicio sin comprometer la integridad de la aplicación original.

2. Interoperabilidad API-first

Escenario: un sistema interno necesita consumir modelos de IA desde aplicaciones externas o herramientas de productividad (ej. Teams, Google Workspace).

Solución técnica: SofIA expone una API RESTful estandarizada, compatible con esquemas OpenAI, que permite conectividad entre sistemas heterogéneos. Además, gestiona tokens de autenticación y permisos por endpoint, garantizando seguridad, trazabilidad y desacoplamiento funcional.

Resultado: comunicación controlada entre legacy y sistemas inteligentes, con visibilidad de extremo a extremo.

3. Orquestación de microservicios con lógica cognitiva

El router interno de SofIA dirige cada solicitud al motor adecuado, ya sea un LLM, un script de validación legacy o un servicio externo. Esta orquestación dinámica se basa en contexto, semántica y lógica de negocio.

Resultado: eficiencia operativa y flexibilidad técnica sin intervención manual.

4. Modernización progresiva

- Día 0: El sistema legacy sigue funcionando como siempre.

- Día 10: Se encapsula un módulo como microservicio expuesto vía SofIA.

- Día 30: Se añade un LLM para enriquecer decisiones sobre datos heredados.

- Día 60: El sistema legacy ya convive con modelos IA sin haber sido modificado.

Resultado: evolución continua y controlada, sin impacto sobre el core.

5. Seguridad y control centralizado

Problema: los sistemas legacy carecen de mecanismos modernos de autenticación, logs y control de acceso.

Mecanismo técnico:

- Control de permisos por tipo de usuario/servicio.

- Trazabilidad de cada transacción o consulta a través de logs estructurados.

- Auditoría centralizada sobre flujos IA + legacy.

Resultado: gobernanza real en entornos donde antes solo existía tolerancia al riesgo.

6. Capacidades extendidas de integración

- Input: documentos ofimáticos en múltiples formatos (pptx, xlsx, docx).

- Proceso: SofIA interpreta, analiza y extrae contenido útil usando modelos LLM.

- Output: información estructurada y lista para ser utilizada por otros microservicios o agentes.

Resultado: digitalización semántica sin intervención humana, incluso desde documentos no estructurados.

7. Escalabilidad y arquitectura extensible

Patrón: SofIA implementa un enfoque “model zoo” desacoplado, en el que se pueden registrar, seleccionar y gobernar múltiples modelos (GPT, Claude, Gemini, etc.).

Implicación: La empresa no queda atada a un proveedor, modelo o stack específico. Puede escalar verticalmente (más complejidad) o horizontalmente (más capacidad) sin rehacer la plataforma.

Resultado: sostenibilidad técnica y libertad de evolución arquitectónica.

Casos de valor: lo que realmente consiguen al combinar IA y microservicios

Hablar de modernización sin rehacer. Escalar capacidades sin poner en riesgo el core. Integrar IA sin perder control. Estas son las inquietudes más recurrentes en organizaciones con sistemas legacy activos. Lo sabemos, porque hemos estado ahí: en sectores donde “tocar lo que funciona” es más peligroso que no hacer nada. Por eso, más allá de lo técnico, estos son los resultados reales que vemos cuando la IA se integra con arquitectura basada en microservicios. No como experimento, sino como solución de producción.

A continuación, te mostramos lo que cambia en la práctica cuando una organización pasa del caos de la deuda técnica no gobernada, al orden operativo con trazabilidad e inteligencia integrada.

Salud: sistemas clínicos con IA sin alterar la historia clínica

Los sistemas de historia clínica electrónica (HCE) suelen estar desarrollados sobre arquitecturas monolíticas, frecuentemente on-premise, con base de datos relacional y frontends rígidos. Muchos módulos (prescripciones, pruebas, evolución) están acoplados al motor de reglas internas, con flujos que no pueden modificarse sin pasar por validación clínica y compliance.

La incorporación de IA en estos entornos suele estar bloqueada porque no es posible intervenir en el backend ni exponer datos sin comprometer la integridad del sistema y el cumplimiento normativo.

Lo que se hace con microservicios + IA

Se encapsulan funciones específicas (por ejemplo, análisis de laboratorio, evolución de síntomas) en microservicios externos mediante APIs seguras. Estos endpoints son consumidos por modelos de IA entrenados en tareas específicas (detección de eventos adversos, agrupación sintomática, alertas clínicas).

- Sin tocar el sistema HCE, los profesionales obtienen sugerencias de IA en tiempo real dentro de su misma interfaz.

- Cada inferencia queda auditada y registrada según normativa GDPR y protocolos clínicos.

- Se puede añadir o quitar lógica IA sin necesidad de intervención sobre el sistema base.

Resultado: se desacopla la capa cognitiva sin intervención sobre el core clínico. La trazabilidad y validación son totales.

Comparativa: frente a rediseñar el sistema hospitalario, este modelo habilita decisiones asistidas y regulación clínica desde una arquitectura periférica.

Industria y logística: IA predictiva sobre líneas de producción legacy

Muchas plantas industriales operan con SCADA, PLCs y ERPs especializados que controlan procesos, sensores y máquinas con tiempos críticos. Estos sistemas no están diseñados para interoperar con lógica externa ni con entornos cognitivos distribuidos. La lógica está embebida y expuesta, en el mejor de los casos, por puertos industriales o APIs locales propietarias.

No existe forma segura de intervenir en el ciclo de decisión sin poner en riesgo la producción o sin rehacer el sistema de control. Además, la deuda técnica acumulada impide integrar herramientas modernas de mantenimiento predictivo o control adaptativo.

Lo que se hace con microservicios + IA

- Se encapsulan procesos como control de calidad, consumo energético o ciclos de mantenimiento en servicios desacoplados expuestos desde gateways industriales.

- La IA analiza históricos de sensores o lecturas de proceso, identifica patrones de anomalía y recomienda ajustes en tiempo real.

- Las decisiones no se toman directamente sobre el sistema de control, sino a través de una interfaz de supervisión gobernada por un middleware.

En entornos industriales, la IA se integra sin tocar el firmware ni alterar los ciclos de control del SCADA. A través de microservicios desacoplados, se analizan datos en paralelo y se generan recomendaciones o alertas sin comprometer la operación. Frente a rediseñar la arquitectura de planta, este enfoque permite desplegar IA de forma segura, trazable y bajo la gobernanza del equipo de operaciones.

Finanzas: decisiones automatizadas sin rehacer el core bancario

Las entidades financieras suelen operar con core bancarios sobre mainframes (AS/400, z/OS) y lógicas de negocio acopladas al sistema transaccional. Cada nueva funcionalidad exige ciclos largos de desarrollo, certificación y validación de seguridad.

El sistema no expone lógica de decisión (riesgo, fraude, compliance) y no puede incorporar IA sin comprometer cumplimiento o trazabilidad.

Lo que se hace con microservicios + IA

- Se encapsulan reglas clave de negocio (scoring, límites de crédito, antifraude) como microservicios externos gobernados por un middleware.

- La IA opera sobre logs de transacciones, perfiles históricos y comportamiento del cliente, generando scores, alertas o recomendaciones.

- Las decisiones IA se versionan, auditan y justifican, permitiendo revisión humana y cumplimiento normativo.

En términos operativos, este enfoque permite enriquecer las decisiones automatizadas (como la evaluación de riesgo, la detección de fraude o el scoring crediticio) mediante modelos de IA integrados en una capa desacoplada, sin necesidad de intervenir en el núcleo transaccional del core bancario. A diferencia de una reingeniería completa del sistema financiero, que implicaría altos riesgos regulatorios, largos ciclos de validación y posibles disrupciones en la operativa diaria, esta estrategia permite desplegar IA de forma segura, trazable y progresiva, garantizando el cumplimiento normativo y manteniendo la estabilidad del entorno productivo.

Administración pública: automatización cognitiva sin migrar portales

Los sistemas públicos suelen estar desarrollados sobre tecnologías legacy (PHP, JSP, .NET heredado), acopladas a bases de datos relacionales y procesos normativos complejos. Muchos formularios web aún generan ficheros PDF, y la lógica de validación está distribuida entre reglas de negocio internas y validaciones manuales.

No se puede modificar el backend sin licitación, ni migrar el portal sin impacto político y normativo. Tampoco se puede exponer información sensible sin trazabilidad.

Lo que se hace con microservicios + IA

- Se conecta el portal público a una capa externa de servicios IA que interpretan documentos, validan trámites y explican normativa al ciudadano.

- El middleware actúa como capa de traducción: convierte flujos no estructurados en datos semánticamente legibles para la IA.

- La trazabilidad legal de cada respuesta está garantizada: logs por sesión, control de modelo, versión del asistente y evidencia de cumplimiento.

La aplicación de IA en administración pública permite desplegar automatización inteligente sobre portales y sistemas institucionales sin necesidad de intervenir en el núcleo legal ni en los backends normativos existentes. Gracias a una arquitectura desacoplada, cada acción generada por la IA (ya sea validación, recomendación o asistencia al ciudadano) queda registrada con trazabilidad jurídica completa. Frente a la complejidad y riesgo de rediseñar todo el sistema institucional, esta estrategia moderniza la experiencia ciudadana, reduce carga operativa en la administración pública y habilita nuevas funcionalidades sin comprometer el cumplimiento normativo.

Reflexión final: modernizar no es reconstruir, es orquestar con inteligencia

La mayoría de las organizaciones que lideran mercados no lo hacen sobre arquitecturas recientes. Lo hacen sobre sistemas que llevan años funcionando, evolucionando a medida que lo hace el negocio. Y ahí está el reto: el legado no se puede desechar, porque contiene procesos, reglas y operaciones que siguen siendo vitales.

La transformación real no empieza por romper lo que ya existe, sino por orquestar lo que funciona con tecnologías que permitan ampliar, conectar y gobernar con inteligencia. La IA, cuando se aplica desde una arquitectura de microservicios bien pensada, no destruye: habilita lo que parecía inamovible. Se convierte en una capa estratégica que abstrae, protege y extiende la lógica existente, sin riesgos innecesarios.

Por eso hablamos de SofIA no como una solución puntual, sino como una pieza de middleware diseñada para trabajar con lo que ya tienes: para inyectar IA entre microservicios y sistemas legacy sin alterar su esencia, permitiendo evolucionar sin deuda técnica, sin rehacer plataformas, sin poner en peligro la operación.

Si estás explorando cómo inyectar IA en lo que ya tienes. Habla con nuestro equipo de como hacerlo sin romper lo que funciona, con gobernanza, modularidad y visión a largo plazo