En un LXP los modelos trabajan, procesan y entregan resultados, pero los equipos técnicos rara vez tienen visibilidad real de lo que ocurre en la operación interna. Las decisiones llegan al usuario final, sí, pero sin la claridad necesaria para entender qué modelo intervino, con qué parámetros y bajo qué criterios se generó una recomendación o itinerario.

Ese vacío genera una tensión evidente: la plataforma cumple con su función visible, mientras en el back-end se acumulan procesos que no dejan huella verificable. Los datos circulan, los algoritmos calculan, los resultados aparecen… y, sin embargo, el registro técnico que permite auditar y sostener esas decisiones suele estar ausente.

La consecuencia inmediata es que la gestión diaria de la plataforma se vuelve opaca y difícil de controlar. Los equipos de tecnología no tienen forma de comprobar la consistencia de los modelos ni de anticipar cómo responderá el sistema al escalar en usuarios o integrar nuevas fuentes. Y esa falta de control no es un detalle menor: es el punto débil de la arquitectura.

El lado invisible de un LXP: cómo se toman las decisiones algorítmicas

Un LXP no es solo una vitrina de contenidos; es una infraestructura que procesa señales, ejecuta modelos y transforma datos en decisiones algorítmicas. Desde fuera parece sencillo: un usuario entra, recibe recomendaciones, avanza en su ruta. Pero desde dentro, el circuito técnico está compuesto por varios módulos que deben funcionar con precisión y coordinación.

Motores de recomendación: potencia sin trazabilidad

En el núcleo encontramos los motores de recomendación. Capturan clics, búsquedas y tiempos de uso para generar sugerencias que mantienen vivo el aprendizaje. Hasta aquí, todo funciona. El punto crítico aparece cuando el equipo de tecnología intenta responder preguntas básicas: qué modelo intervino, qué versión se ejecutó, qué parámetros pesaron en la decisión. La plataforma entrega resultados, pero no deja el rastro necesario para auditar cómo llegó a ellos.

Analítica de skills: mapas de competencias con riesgo de fragmentación

El segundo pilar es la analítica de competencias. El LXP traduce interacciones en un mapa dinámico de habilidades: qué sabe el usuario, dónde tiene brechas y cómo se compara con su cohorte. En teoría, este debería ser el idioma común entre estudiantes, docentes y gestores. Sin embargo, cuando los distintos módulos procesan los datos con criterios distintos, se generan representaciones fragmentadas. Un alumno puede aparecer con alta competencia en un motor y con baja en otro. El resultado: datos útiles para dashboards, pero inconsistentes para la toma de decisiones estratégicas.

Rutas dinámicas: adaptabilidad sin capacidad de reconstrucción

La capa más visible para el usuario son las rutas personalizadas. Cada avance configura el itinerario en tiempo real, combinando outputs de motores semánticos con reglas de negocio y predicciones de desempeño. La dificultad está en que la decisión no es reconstruible: si dos perfiles similares reciben caminos distintos, no existe forma de trazar con precisión qué lógica lo justificó. Desde el punto de vista de arquitectura, esto equivale a operar con un sistema crítico sin logs verificables.

El diagnóstico: una caja negra con límites de control

Todos estos componentes cumplen su función, pero en conjunto configuran un ecosistema con un déficit claro de flexibilidad y control granular. Los equipos de tecnología se enfrentan a tres limitaciones:

- Escalabilidad rígida: cada vez que se incorpora un nuevo modelo, la arquitectura del LXP debe ajustarse en su núcleo.

- Auditabilidad débil: no es posible verificar con exactitud cómo se generó una recomendación o una ruta.

- Dependencia excesiva: la plataforma queda atada a un único motor de IA, con poco margen para ensayar alternativas o combinaciones.

No es que el LXP falle en su propósito visible, sino que su operación interna carece de los mecanismos de trazabilidad y control que demandan entornos educativos y corporativos complejos. Y es justo aquí donde la conversación con un middleware cobra sentido: no para reemplazar lo que ya funciona, sino para ampliar de manera tangible el alcance técnico de la plataforma.

Los LXP generan experiencias valiosas, pero operan como cajas negras algorítmicas que limitan el control y la escalabilidad. La incorporación de un middleware de IA, como SofIA, responde a esta necesidad: una capa intermedia de gestión que conecta la plataforma con múltiples modelos, regula el uso de datos y habilita un gobierno técnico verificable.

Middleware como capa de integración

SofIA está diseñado como un núcleo integrador que se conecta a los sistemas existentes (ERP, CRM, LMS, cloud y on-premise) sin necesidad de reescribir la arquitectura.

- Actúa como un router de modelos: selecciona de manera dinámica el motor de IA más adecuado (GPT-4, Claude, Llama, OpenChat, etc.) según el tipo de tarea o fuente de datos.

- Permite combinar IA generativa, visión por computador y machine learning en un mismo flujo, lo que multiplica las capacidades del LXP sin crear silos.

- Se adapta a entornos híbridos y locales, lo que garantiza despliegue seguro y compatibilidad con infraestructuras educativas o corporativas complejas.

Funciones críticas para un LXP

1. Integración de múltiples motores sin modificar el núcleo

Un LXP no necesita limitarse a un motor interno de recomendaciones. SofIA permite incorporar varios modelos en paralelo, compararlos y activarlos según contexto, sin tocar la arquitectura base.

2. Registro de logs y metadatos técnicos

Cada recomendación o itinerario se acompaña de un registro verificable:

- Modelo utilizado y versión.

- Parámetros relevantes de la decisión.

- Fuente de datos procesada.

Esto responde a una necesidad clave: auditar y reconstruir decisiones algorítmicas en tiempo real.

3. Políticas dinámicas de acceso y uso de datos

SofIA incorpora gobernanza de IA: define quién accede, bajo qué nivel de permiso y cómo se protegen los datos sensibles. Todo sin exponer información a entornos públicos, lo que reduce riesgos regulatorios y de seguridad.

4. Escalabilidad modular

La arquitectura de SofIA está pensada para crecer sin fricciones. Nuevos modelos, servicios o flujos de aprendizaje se añaden como módulos, sin rehacer la infraestructura del LXP ni comprometer la estabilidad.

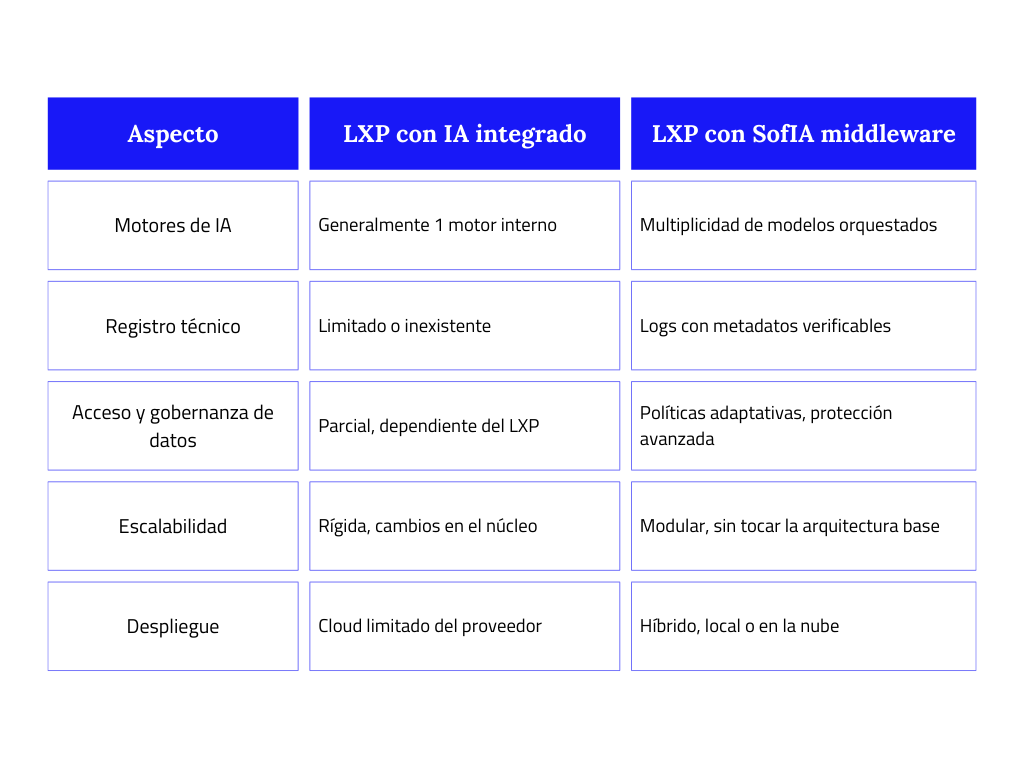

Tabla comparativa: LXP nativo vs LXP con middleware

La idea central

Con SofIA como middleware, un LXP deja de ser una caja cerrada y pasa a convertirse en un ecosistema expandible, transparente y gobernable.

- No reemplaza lo que ya funciona en la plataforma, lo potencia con trazabilidad y control operativo.

El resultado es un entorno capaz de integrar modelos diversos, mantener coherencia técnica y crecer con seguridad, alineado tanto a los objetivos educativos como a los requisitos de arquitectura empresarial.

Caso técnico de integración LXP con middleware

La verdadera aportación de un middleware como SofIA en un LXP no está en lo que se ve en pantalla, sino en lo que ocurre en la arquitectura subyacente: la forma en que se conectan sistemas, modelos y procesos sin interrumpir la operación diaria de la plataforma.

Flujo operativo simplificado

- Normalización de eventos: los datos que genera el LXP (interacciones, evaluaciones, búsquedas) llegan al middleware bajo un formato único, eliminando dependencias con la lógica interna del sistema.

- Selección inteligente de modelos: SofIA enruta cada evento hacia el motor más adecuado, pero lo hace desde una lógica central que evita duplicaciones y reduce el coste computacional.

- Enriquecimiento contextual: antes de devolver la salida, el middleware cruza la información con fuentes externas o sistemas corporativos (ERP, CRM, data lakes), generando resultados más alineados con el contexto real de la institución.

- Registro técnico consolidado: todos los eventos quedan almacenados en un repositorio auditable, no en fragmentos dispersos de la plataforma.

Ejemplo aplicado a educación superior

Un LXP de una universidad no solo recomienda recursos: al estar conectado con SofIA, cada decisión puede integrar datos del ERP académico (horarios, historial de matrícula) y del LMS (calificaciones formales). El middleware fusiona ambas fuentes y devuelve al LXP una recomendación coherente que tiene en cuenta tanto el rendimiento formal como el consumo informal. Para el área técnica, esto significa un control unificado de flujos que antes estaban dispersos.

Ejemplo aplicado a formación corporativa

En un entorno empresarial, el LXP puede integrarse con un CRM para detectar qué empleados participan en proyectos clave y con qué competencias. SofIA recoge esa información, la procesa junto con la actividad en el LXP y devuelve itinerarios de formación que se ajustan no sólo al perfil académico del empleado, sino también a su rol activo en la compañía. El equipo de TI obtiene un modelo de integración donde la formación se vincula directamente con los sistemas core de negocio.

La diferencia en la operación diaria

Para los usuarios finales, la experiencia del LXP no cambia: sigue siendo un entorno de aprendizaje familiar. Para los equipos de tecnología, en cambio, la integración con un middleware significa operar con procesos consolidados, datos coherentes y flujos auditables. Ya no se trata de “un motor que recomienda”, sino de una infraestructura que conecta ecosistemas enteros y los convierte en un solo circuito gobernado.

Beneficios clave de un LXP gobernado con middleware

Cuando hablamos de integrar un LXP con un middleware como SofIA, lo que realmente está en juego no es solo “que el sistema recomiende mejor”, sino cómo aseguramos que la tecnología funcione bajo las reglas que la institución necesita. Permíteme desglosar los beneficios clave desde la perspectiva de los equipos técnicos y de dirección:

Independencia tecnológica

Lo primero que solemos señalar es el riesgo de depender de un único motor de IA. En educación, eso significa que si el proveedor cambia precios, deja de actualizar o simplemente no responde a vuestras necesidades, el LXP queda bloqueado. Con SofIA, el enfoque es distinto: la capa middleware permite usar varios modelos en paralelo y sustituirlos sin interrumpir la operación.

Escalabilidad modular

Otro punto crítico es la escalabilidad. Normalmente, añadir nuevas capacidades a un LXP implica proyectos de integración largos y costosos. Con SofIA, el crecimiento es modular: cada nueva capacidad se conecta como un bloque más en la capa middleware.

Control operativo

En la práctica, un director de TI necesita más que resultados de IA; necesita gobernar cómo, cuándo y con qué se generan esos resultados. SofIA permite activar o desactivar motores, definir reglas de uso por contexto y aplicar políticas de acceso.

Por ejemplo: en la práctica, un director de TI necesita más que resultados de IA; necesita gobernar cómo, cuándo y con qué se generan esos resultados. SofIA permite activar o desactivar motores, definir reglas de uso por contexto y aplicar políticas de acceso.

Auditoría y cumplimiento

Finalmente, está el tema de la trazabilidad. En educación, los procesos no solo deben ser efectivos, sino también defendibles frente a auditorías académicas o regulatorias. Con SofIA, cada recomendación o ruta de aprendizaje queda acompañada de metadatos: qué modelo intervino, qué versión estaba en uso, qué parámetros pesaron.

En un caso práctico, una institución de posgrado pudo presentar ante un organismo acreditador cómo se había generado una ruta de aprendizaje concreta para un estudiante, con toda la trazabilidad técnica de las decisiones. Ese nivel de evidencia no lo da un LXP en solitario.

SofIA: plataforma corporativa de IA

Reflexión: hacia un LXP gobernado por arquitectura, no por algoritmos

Lo que hemos visto en estos escenarios confirma una idea clave: un LXP con IA ya no puede evaluarse sólo por la calidad de sus algoritmos, sino por la solidez de la arquitectura que los sostiene. En educación y formación corporativa, donde la continuidad, la coherencia y la trazabilidad no son opcionales, el verdadero diferencial está en contar con una capa que permite orquestar modelos, gobernar flujos y consolidar datos dispersos en un único plano operativo.

La reflexión es clara: el futuro de los LXP no depende de incorporar “más IA”, sino de construir entornos gobernados, donde cada recomendación pueda ser explicada, cada decisión auditada y cada ampliación técnica desplegada sin rehacer lo que ya funciona. Esa es la diferencia entre una plataforma que escala y una que se convierte en un experimento pasajero.

Un middleware como SofIA aporta precisamente ese marco: no añade complejidad, sino que crea las condiciones para que la IA en un LXP sea sostenible, auditable yestratégicamente útil. En otras palabras, el valor no está en sustituir lo que ya existe, sino en extenderlo con una arquitectura que asegure control, coherencia y capacidad de evolución.

Si tu equipo ya está explorando cómo dar el siguiente paso en la integración de IA en su LXP. Habla con nuestro equipo: la conversación no debería girar en torno al próximo modelo a probar, sino a la arquitectura que garantice que todo ese ecosistema será gobernable y preparado para escalar.