Durante la última década, la inteligencia artificial ha avanzado de forma notable en su capacidad de comprensión. Modelos capaces de interpretar lenguaje natural, procesar imágenes o identificar patrones complejos han elevado las expectativas sobre lo que estos sistemas pueden hacer. Sin embargo, cuando la IA se despliega en entornos empresariales reales, emerge una limitación menos visible, pero mucho más determinante: la dificultad para sostener coherencia, contexto y decisiones a lo largo del tiempo.

La mayoría de sistemas funcionan correctamente cuando se enfrentan a interacciones aisladas. Es en ese punto donde se hace evidente que el verdadero límite de la IA moderna no es el lenguaje, sino la gestión de la memoria. Este desafío no es nuevo. Arquitecturas como LSTM surgieron precisamente para abordar la necesidad de mantener información relevante en secuencias prolongadas y evitar que los sistemas reaccionaran únicamente al último estímulo.

Hablar de memoria, por tanto, no es hablar de una optimización técnica menor ni de un detalle algorítmico. Es hablar de una decisión estructural de diseño, heredera de principios como los introducidos por LSTM, que define si la IA actúa como una herramienta puntual o como un sistema capaz de integrarse de forma fiable y sostenida en procesos de negocio.

El problema real de la IA moderna no es entender, es recordar

El debate habitual en torno a la IA suele centrarse en cuánto entiende un modelo. Sin embargo, en escenarios empresariales, la pregunta relevante es otra: ¿puede el sistema sostener decisiones, contexto y criterios a lo largo del tiempo?

Un sistema puede comprender perfectamente una petición concreta y aun así fallar cuando debe mantener prioridades y contexto a lo largo del tiempo. Esto ocurre porque la mayoría de arquitecturas están optimizadas para responder al presente, no para mantener continuidad, un límite que ya intentaban abordar modelos con memoria explícita como LSTM.

Este límite ya había sido identificado mucho antes en el diseño de redes neuronales, y dio lugar a arquitecturas como LSTM, concebidas específicamente para introducir memoria explícita como parte del comportamiento del sistema.

El resultado es una IA que impresiona en demostraciones puntuales, pero se vuelve frágil cuando se enfrenta a escenarios prolongados y reales.

Comprensión puntual vs comportamiento coherente en el tiempo

Responder bien a un input no garantiza coherencia. La comprensión puntual se limita a procesar información en un instante específico. El comportamiento coherente, en cambio, requiere conservar decisiones previas, respetar el contexto acumulado y actuar de forma consistente entre interacciones.

Muchos sistemas parecen inteligentes porque se evalúan en escenarios aislados. Cuando la interacción se extiende una conversación continua, un proceso operativo, una relación persistente con un usuario, emergen contradicciones, reinicios de contexto y respuestas desconectadas.

La inteligencia puntual impresiona; la coherencia sostenida construye confianza.

Sin memoria, la IA no puede cumplir esta segunda condición.

La memoria como selección, no como acumulación

Uno de los errores conceptuales más frecuentes es confundir memoria con almacenamiento. Desde una perspectiva de sistemas, esta visión es incompleta. Recordar no significa guardar todo, sino decidir qué sigue siendo relevante, un principio que ya formalizaban arquitecturas con memoria explícita como LSTM.

Una memoria eficaz implica:

- seleccionar información crítica,

- descartar datos irrelevantes,

- y ajustar el contexto conforme evoluciona la interacción.

Olvidar no es una carencia del sistema, es una capacidad esencial.

Sin mecanismos de olvido, la memoria se degrada en ruido, sesgos y datos fuera de contexto, afectando directamente a la fiabilidad del sistema.

Cuando la IA interactúa con procesos reales, la falta de memoria se convierte en un problema operativo

Las limitaciones de memoria pueden pasar desapercibidas en pruebas controladas. Sin embargo, cuando la IA se integra en procesos reales, estas limitaciones dejan de ser teóricas. Se manifiestan como problemas operativos con impacto directo en negocio.

En este punto, la memoria deja de ser un detalle técnico secundario y se convierte en un componente crítico del sistema.

De la conversación al proceso

Existe una diferencia fundamental entre responder preguntas y participar en un proceso. Cuando la IA interviene en flujos de negocio como atención al cliente, soporte interno, automatización o validación de información, cada interacción condiciona la siguiente.

La interacción continua no es una excepción, es la norma. Sin una gestión adecuada de memoria, el sistema pierde continuidad, repite decisiones ya tomadas o ignora información proporcionada previamente.

Un proceso sin memoria es un proceso que no se estabiliza ni mejora con el uso.

Impactos invisibles: errores, fricción y pérdida de confianza

Los efectos de una memoria deficiente rara vez aparecen como errores evidentes. Son fallos silenciosos: incoherencias, contradicciones y decisiones desconectadas del contexto previo.

Estos problemas generan fricción, aumentan la necesidad de supervisión humana y erosionan progresivamente la confianza en el sistema. En entornos empresariales, la pérdida de confianza es más costosa que un error técnico puntual.

LSTM y el origen del concepto de memoria operativa en redes neuronales

Mucho antes del auge de la IA generativa, el problema de la memoria ya había sido identificado en el ámbito de las redes neuronales. El reto no era nuevo: cómo manejar información relevante a lo largo de secuencias largas sin perder contexto. Arquitecturas como LSTM surgieron precisamente para abordar este límite, introduciendo mecanismos explícitos para sostener estado y relevancia temporal.

La introducción de LSTM no resolvía un problema de capacidad computacional, sino un problema de diseño temporal. Al incorporar mecanismos explícitos de control sobre qué información se mantiene y cuál se descarta, LSTM permitió por primera vez modelar memoria operativa como una decisión interna del sistema, no como un efecto colateral del entrenamiento.

El límite de reaccionar solo al último input

Las arquitecturas tempranas de redes neuronales fallaban al procesar secuencias prolongadas porque su comportamiento estaba dominado por el último input recibido. Esto hacía imposible capturar dependencias temporales largas y mantener continuidad en la información.

Este límite dejó claro que sin memoria explícita, un sistema solo puede reaccionar, no razonar en el tiempo, lo que motivó el desarrollo de arquitecturas como LSTM, orientadas a capturar dependencias temporales largas de forma controlada.

Memoria a corto y largo plazo como decisión interna del sistema

Las redes LSTM introdujeron un cambio conceptual clave: la separación explícita entre estado transitorio y estado persistente. Por primera vez, un sistema podía gestionar internamente qué información debía conservar y cuál debía descartar en función de su relevancia temporal.

Este principio se materializa en arquitecturas donde el propio modelo controla el flujo de información a lo largo de una secuencia, como ocurre en la implementación de capas LSTM orientadas a la gestión explícita de dependencias temporales.

La relevancia de LSTM no está en su vigencia como arquitectura dominante, sino en el principio que estableció:

Decidir qué olvidar es tan importante como decidir qué recordar.

Este enfoque, introducido por LSTM, sigue siendo relevante no por la arquitectura en sí, sino porque establece una distinción fundamental entre memoria transitoria y memoria persistente, un principio que hoy sigue siendo crítico en el diseño de sistemas de IA empresariales.

La IA generativa sin memoria es un cerebro sin contexto

El auge de la IA generativa ha desplazado la conversación hacia modelos capaces de producir texto, código o imágenes con una calidad sorprendente. Sin embargo, esta capacidad ha generado una confusión frecuente: asumir que generar respuestas coherentes equivale a comprender y aprender en el tiempo. A diferencia de enfoques clásicos orientados a la memoria, como los que introdujeron las arquitecturas LSTM, la IA generativa prioriza la generación inmediata sobre la continuidad. En la práctica, no es lo mismo.

Un sistema generativo puede producir salidas convincentes sin mantener ningún tipo de continuidad entre interacciones. La generación es instantánea; el contexto, si no se gobierna, es efímero. Sin un mecanismo explícito de memoria como el que inspiró LSTM en su momento, este desajuste explica por qué muchos sistemas parecen inteligentes en una interacción y desconectados en la siguiente.

Por qué un LLM responde bien pero no aprende entre interacciones

Los modelos de lenguaje están diseñados para optimizar la generación de texto a partir de un contexto limitado. Responden bien porque predicen con precisión la siguiente salida más probable, no porque mantengan un estado interno persistente entre interacciones, como sí planteaban arquitecturas orientadas explícitamente a la memoria, como LSTM.

Aquí es clave diferenciar dos conceptos que suelen mezclarse:

- generación de texto,

- continuidad cognitiva.

Un LLM puede manejar contextos amplios dentro de una sesión, pero no “aprende” automáticamente de una interacción a la siguiente. Una vez finaliza el intercambio, el contexto se pierde si no existe una capa externa que lo conserve y lo reintroduzca de forma controlada. A diferencia del principio que introdujo LSTM en decidir qué información persiste en el tiempo, el modelo no tiene noción propia de continuidad.

Sin una gestión explícita de memoria, cada interacción empieza casi desde cero, aunque para el usuario la experiencia sea aparentemente continua.

Coherencia, continuidad y expectativa del usuario

Cuando una persona interactúa repetidamente con un sistema de IA, desarrolla expectativas implícitas. Espera que el sistema recuerde información básica, mantenga criterios consistentes y adapte su comportamiento en función de interacciones previas. Esta expectativa no es psicológica: es operativa. Surge cuando el sistema se percibe como parte de un proceso continuo, no como una herramienta puntual.

La falta de memoria rompe estas expectativas. El sistema puede repetir preguntas ya respondidas, ignorar decisiones anteriores o cambiar de criterio sin explicación. La ilusión de inteligencia se rompe no por un error puntual, sino por la ausencia de un estado persistente, el mismo problema que LSTM abordó desde el diseño de redes neuronales al introducir memoria explícita como parte del modelo. En arquitecturas inspiradas en LSTM, la coherencia no depende de la respuesta inmediata, sino de la capacidad de mantener y actualizar estado en el tiempo, algo que LSTM resolvió separando memoria transitoria y memoria relevante.

En entornos empresariales, esta ruptura es especialmente costosa. No solo afecta la experiencia del usuario, sino la credibilidad del sistema como componente fiable dentro de un proceso mayor. Sin continuidad, la IA deja de percibirse como sistema y vuelve a comportarse como una interacción aislada, aunque el modelo sea avanzado.

Los casos de uso determinan qué tipo de memoria se necesita

Uno de los errores más frecuentes al diseñar sistemas de IA es asumir que la memoria debe comportarse de forma homogénea en todos los escenarios. En la práctica, no todos los casos de uso requieren el mismo tipo ni el mismo alcance de memoria, y tratar la memoria como un bloque único introduce incoherencias difíciles de corregir más adelante.

La clave no está en maximizar la memoria, sino en ajustarla al propósito del sistema. Este es precisamente el principio que introdujeron arquitecturas como LSTM: diferenciar qué información debe persistir, durante cuánto tiempo y con qué impacto en el comportamiento futuro. Trasladado a sistemas empresariales, este enfoque obliga a diseñar la memoria como una capacidad condicionada por el caso de uso, no como una acumulación genérica de contexto.

Existen escenarios en los que la memoria a corto plazo cumple adecuadamente su función. Procesos transaccionales, consultas puntuales o flujos cerrados requieren coherencia únicamente dentro de una interacción limitada, sin necesidad de conservar estado más allá de ese contexto inmediato.

En estos casos, extender la memoria más allá de lo necesario introduce riesgos innecesarios:

- acumulación de información irrelevante,

- aumento de complejidad operativa,

- exposición a errores derivados de contexto obsoleto.

Sobredimensionar la memoria puede ser tan perjudicial como no tenerla. Aplicar enfoques inspirados en LSTM diseñados para gestionar dependencias temporales largas en escenarios que no lo requieren añade fricción sin aportar valor. La memoria debe responder a una necesidad funcional clara, no a una suposición genérica sobre “más contexto es mejor”.

Casos donde la memoria histórica es crítica

En otros escenarios, la memoria histórica no es opcional. Sistemas de atención al cliente, entornos industriales, plataformas de recomendación o soluciones que interactúan de forma recurrente con usuarios necesitan conservar contexto relevante a lo largo del tiempo para operar con coherencia.

En estos casos, la memoria permite:

- personalizar respuestas en función de interacciones previas,

- mejorar la toma de decisiones incorporando historial operativo,

- y reducir fricción en relaciones continuas entre sistema y usuario.

Este tipo de comportamiento es el que motivó arquitecturas como LSTM, diseñadas para mantener información significativa a lo largo de secuencias extensas sin degradar el contexto. Trasladado a sistemas empresariales, el principio es el mismo: la memoria histórica no amplifica la inteligencia, la hace utilizable.

La relevancia de este enfoque se observa con claridad en aplicaciones reales de IA en entornos industriales, donde el valor del sistema depende de su capacidad para integrar información histórica en cada decisión y sostener comportamientos coherentes en el tiempo. Aquí, la memoria no es un añadido funcional, es la base de la utilidad del sistema.

Persistir demasiado también es un problema: cuando recordar degrada el sistema

Si en un extremo la falta de memoria limita la utilidad de la IA, en el otro extremo el exceso de persistencia introduce nuevos problemas. Recordar sin control no mejora el sistema, lo degrada.

La memoria mal gestionada rara vez falla de forma evidente.

Sesgos, ruido y descontextualización

La información válida en un momento concreto puede dejar de serlo con el paso del tiempo. Cuando el sistema no distingue entre contexto vigente y contexto obsoleto, empieza a tomar decisiones basadas en datos que ya no reflejan la realidad.

Esto introduce sesgos, ruido y comportamientos erráticos difíciles de detectar. El sistema no parece fallar, pero deja de acertar de forma consistente.

La memoria, sin mecanismos de actualización y limpieza, se convierte en una fuente de degradación progresiva.

Privacidad, seguridad y cumplimiento

Además de los problemas funcionales, la memoria persistente amplía la superficie de riesgo. Cada dato almacenado implica una responsabilidad en términos de privacidad, seguridad y cumplimiento normativo.

Sin reglas claras sobre:

- qué se guarda,

- durante cuánto tiempo,

- con qué nivel de precisión,

- y quién puede acceder,

la memoria se convierte en un punto débil del sistema. Gobernar la memoria no es solo una cuestión técnica, es una obligación operativa y legal.

La memoria no puede dejarse al modelo: es una decisión arquitectónica

A medida que los modelos de IA ganan capacidad, surge una tentación recurrente: delegar en el propio modelo decisiones que deberían pertenecer al sistema. La memoria es uno de los casos más claros. Confiar en que el modelo “gestione” la memoria es confundir inteligencia estadística con gobernanza.

En entornos empresariales, la memoria no puede ser una consecuencia emergente del modelo. Debe ser una decisión explícita de arquitectura.

Por qué el modelo no debe decidir qué recordar

Los modelos de IA están optimizados para maximizar predicción. Su objetivo es generar la mejor salida posible dadas unas entradas concretas. No están diseñados para evaluar impacto organizativo, riesgos legales o coherencia de negocio.

Aquí aparece un conflicto estructural. Mientras el modelo optimiza probabilidad, la empresa necesita control. Necesita decidir qué información persiste, qué se descarta y bajo qué condiciones se reutiliza.

Delegar la memoria al modelo es renunciar a gobernanza, y en sistemas empresariales, esa renuncia tiene consecuencias operativas, regulatorias y estratégicas.

Memoria como infraestructura

La memoria debe concebirse como una capa del sistema, no como un parámetro interno del modelo. Igual que la seguridad, la observabilidad o la escalabilidad, la memoria forma parte de la infraestructura.

Diseñar memoria como infraestructura implica separar responsabilidades:

- el modelo razona,

- el sistema decide qué contexto recibe,

- la arquitectura gobierna qué información persiste.

Esta separación no solo mejora el control, sino que permite evolucionar el sistema sin rehacerlo desde cero.

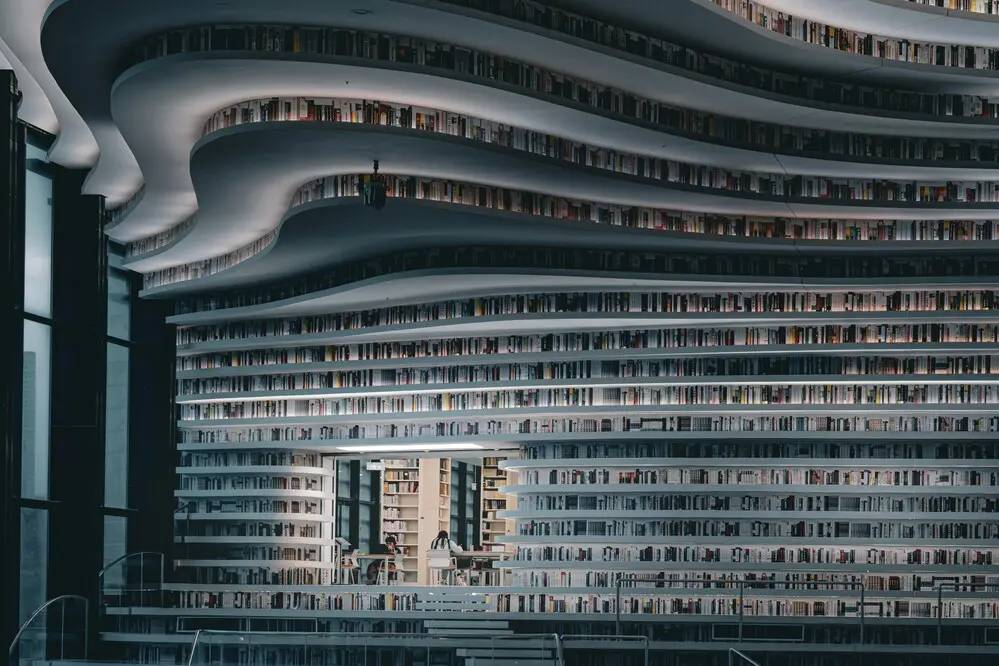

Sistemas de IA empresariales y capas múltiples de memoria

Los sistemas de IA que operan en entornos complejos no trabajan con una única memoria. Funcionan sobre múltiples capas de contexto, cada una con un propósito distinto. Mezclarlas o tratarlas como un único bloque es una fuente frecuente de errores.

Memoria de interacción y conversación

Esta capa gestiona el contexto inmediato. Es efímera, altamente dinámica y vinculada a la interacción actual. Permite mantener coherencia dentro de una conversación o sesión concreta.

Su valor está en la fluidez, no en la persistencia. Extender esta memoria más allá de su función introduce ruido, no inteligencia.

Memoria de usuario y contexto de negocio

Aquí aparece la memoria histórica. Preferencias, estados previos, decisiones anteriores o información relevante que debe persistir entre interacciones para sostener comportamientos coherentes en el tiempo.

Esta capa no responde a la conversación actual, sino a la relación continua entre el sistema y el usuario o proceso. Es clave para la personalización y la consistencia, y conecta directamente con el principio introducido por arquitecturas como LSTM, donde la memoria persistente permite mantener contexto relevante sin depender de cada interacción puntual. Precisamente por eso, esta capa requiere reglas claras de gobierno para evitar degradación y pérdida de fiabilidad.

Reglas, datos estructurados y conocimiento estable

No todo debe depender de lo que el usuario diga ni de lo que el sistema recuerde en una interacción concreta. Las reglas de negocio, los datos estructurados y el conocimiento estable deben permanecer fuera del contexto conversacional para garantizar consistencia, control y alineación con los objetivos del sistema.

Este plano actúa como ancla del comportamiento del sistema, estableciendo límites, criterios y patrones de actuación que no deben fluctuar con cada interacción, independientemente del contexto inmediato. Cuando estas capas se mezclan con la conversación, el sistema pierde estabilidad y se vuelve impredecible, especialmente en entornos complejos donde conviven múltiples fuentes de información y capacidades organizadas en un mismo marco de conocimiento.

El middleware como orquestador de la memoria

Si la memoria no pertenece al modelo, alguien debe orquestarla. Ese rol lo cumple el middleware. No como un componente accesorio, sino como el centro de control del sistema de IA.

Decidir qué entra, qué se guarda y qué se descarta

El middleware actúa como filtro y coordinador. Decide:

- qué información entra al modelo,

- qué se persiste,

- qué se reutiliza,

- y qué se descarta.

En este enfoque, la memoria es un flujo gobernado, no un almacén pasivo. Cada dato tiene un ciclo de vida definido y una función concreta dentro del sistema.

Separar modelo, memoria y lógica de negocio

Esta separación es clave para la escalabilidad y la auditoría. Permite cambiar modelos sin alterar reglas de memoria, ajustar políticas de contexto sin afectar la lógica de negocio y auditar decisiones sin depender del comportamiento interno del modelo.

Cuando estas capas se mezclan, el sistema se vuelve opaco y difícil de evolucionar. Cuando se separan, la IA se convierte en una capacidad gestionable.

SofIA y la conversión de la memoria en una capacidad gobernada

En este punto, la memoria deja de ser un problema conceptual y se convierte en una capacidad concreta del sistema. Aquí es donde plataformas como SofIA adquieren sentido, no como asistentes aislados, sino como infraestructura.

De asistente a plataforma de orquestación

SofIA no se plantea como un chatbot, sino como una plataforma que permite integrar IA en procesos empresariales complejos. Su aportación no está en la respuesta puntual, sino en la capacidad de orquestar modelos, contexto y memoria bajo reglas explícitas.

Este enfoque se refleja en la concepción de SofIA como asistente de IA para empresas, donde la interacción es solo una parte de un sistema más amplio que coordina decisiones, contexto y persistencia de la información.

Control de memoria, contexto, seguridad y trazabilidad

SofIA permite gestionar de forma explícita la memoria a corto y largo plazo, definir reglas de acceso, garantizar trazabilidad y alinear el comportamiento de la IA con las políticas de seguridad y negocio de la organización.

No se trata solo de usar IA, sino de hacerla responsable y gobernable dentro de la organización, integrándola en un enfoque de inteligencia artificial aplicada a entornos empresariales donde la arquitectura, el control y la trazabilidad son parte del diseño del sistema.

SofIA: plataforma corporativa de IA

Reflexión: la memoria define si la IA es una herramienta o un sistema fiable

Más allá de modelos y tecnologías, la diferencia real entre una IA experimental y una IA empresarial reside en cómo se gestiona la memoria. No es una cuestión de potencia, sino de diseño. Del mismo modo que arquitecturas como LSTM marcaron un punto de inflexión al introducir memoria explícita en redes neuronales, los sistemas de IA empresariales solo se vuelven fiables cuando la memoria se diseña, gobierna y controla a nivel arquitectónico.

El verdadero salto no está en el modelo, sino en la arquitectura

Las demos impresionan porque maximizan capacidades del modelo. Los sistemas sostenibles funcionan porque controlan contexto, decisiones y consecuencias. La arquitectura es lo que transforma inteligencia en fiabilidad.

Diseñar memoria es asumir responsabilidad

Decidir qué recordar implica decidir qué influye en el sistema. Afecta a decisiones, privacidad, seguridad y resultados. La memoria es la frontera entre experimento y sistema empresarial. Si tu organización está evaluando cómo gobernar la memoria en sistemas de IA empresariales y convertirla en una capacidad operativa, controlable y escalable, abre una conversación con nuestro equipo puede ser el primer paso para analizar la arquitectura, el modelo de integración y las decisiones necesarias para sostener la IA en el tiempo.