Una cosa está clara: los equipos de desarrollo ya no se miden solo por la velocidad con la que producen código, sino por la capacidad de mantenerlo vivo, entendible y alineado con la arquitectura del negocio. Y ahí es donde la conversación sobre IA ha cambiado de fondo. Hoy, cuando hablamos de IA para código, no hablamos de un asistente genérico que completa funciones: hablamos de motores diseñados para interpretar lenguajes, convenciones y estructuras con la misma profundidad con la que un arquitecto técnico analiza un sistema.

Esto es lo que está pasando dentro de las empresas: los CTOs ya no preguntan “¿cuánto más código podemos generar?”, sino “¿cómo garantizamos coherencia, trazabilidad y control técnico en un entorno que cambia cada semana?”. Y la única respuesta seria está viniendo de modelos de IA integrados directamente en IDE, pipelines y middlewares que gobiernan cómo se escribe, revisa y valida el código.

Y cuando la IA entiende el código como código, no como texto, la conversación deja de girar en torno a productividad y empieza a centrarse en decisiones técnicas más sólidas, menos deuda y un control más riguroso del sistema. Ese es el punto donde la IA deja de ser una herramienta y empieza a convertirse en una ventaja estructural.

Qué significa realmente “IA para código” en un entorno empresarial

La expresión “IA para código” suele confundirse con un complemento para escribir más rápido. En realidad, en empresas con arquitecturas complejas y requisitos técnicos estrictos, significa algo muy distinto: una capa de inteligencia que entiende el sistema, respeta sus reglas y participa activamente en su gobernanza técnica. No es productividad; es dirección técnica asistida.

Cuando la IA deja de intuir líneas y empieza a leer el sistema

La diferencia clave no está en la velocidad sino en la comprensión. Un copiloto tradicional predice la siguiente línea; la IA para código empresarial entiende cómo el módulo actual se relaciona con el resto del ecosistema. Identifica patrones, detecta reglas implícitas y razona sobre dependencias que un humano quizás no ve a simple vista. Por eso sus sugerencias encajan sin romper la lógica de negocio: porque actúa con una visión global del sistema, no con un fragmento del archivo.

Los estándares dejan de ser un checklist y se vuelven parte del ADN

En un entorno corporativo, los linters, las convenciones internas y las reglas de seguridad no son tareas de “postprocesado”: están incrustadas en la identidad técnica del sistema. La IA las incorpora desde el primer carácter que genera.

Mientras sugiere, ya válida si:

- La función sigue el estilo del repositorio.

- La librería cumple con la versión aprobada.

- El patrón coincide con la arquitectura definida.

No hay corrección posterior: el código nace bien. Y eso reduce ruido, fatiga y discusiones que antes eran inevitables.

La trazabilidad no es burocracia: es protección técnica

Una recomendación de IA sin trazabilidad es un salto de fe; con trazabilidad, es una decisión que puede defenderse. La empresa necesita saber quién generó la sugerencia (modelo, versión), qué reglas aplicó y qué impacto calculó. No por formalidad, sino porque cuando algo falla y siempre falla algo la IA para código permite retroceder el reloj y entender el razonamiento.

Esa capacidad de reconstrucción técnica convierte a la IA en un elemento confiable, no en una caja negra.

La diferencia real: la IA analiza impacto, no solo sintaxis

Puedes tener un código perfectamente escrito que rompa un sistema en producción. La IA para código empresarial no se conforma con que compile: revisa cómo ese cambio se propaga a través de servicios, controladores, procesos y bases de datos. Su lógica es transversal, no local. Ese entendimiento profundo del impacto es lo que convierte a la IA en un componente arquitectónico, no en una herramienta comodín.

Modelos de IA para código especializados por lenguaje

La madurez en IA para código no llega cuando un equipo “usa IA”, sino cuando usa el modelo adecuado para el lenguaje adecuado. En ingeniería corporativa, Python no se comporta como Java; JavaScript no se razona como Go; Rust exige reglas completamente distintas. Y los modelos generalistas, por más potentes que parezcan, fallan precisamente ahí: en las normas silenciosas que cada lenguaje establece.

Y ahí aparece una verdad técnica clave: si el sistema está construido sobre un stack concreto, la IA debe estar entrenada o afinada para ese stack. Esa es la esencia de los Language-Specific Code Models (LSCM).

Por qué un solo modelo de código ya no es suficiente

Los modelos generalistas funcionan razonablemente bien en problemas pequeños y lenguajes «cómodos» (Python, algo de JS, pseudo-SQL). El problema aparece cuando entras en:

- Lenguajes estrictos (Rust, C, C++).

- Ecosistemas con frameworks pesados y convenciones duras (Java/Spring, .NET, Angular).

- O lenguajes legacy (COBOL, Fortran, ABAP, Visual Basic), que siguen moviendo el negocio real.

En los benchmarks multilenguaje se ve claro: incluso dentro de escenarios de IA para código, el mismo modelo puede pasar de resultados aceptables en Python a comportarse de forma errática en otros lenguajes, generando código que compila poco, se integra mal o ignora por completo las prácticas idiomáticas del ecosistema.

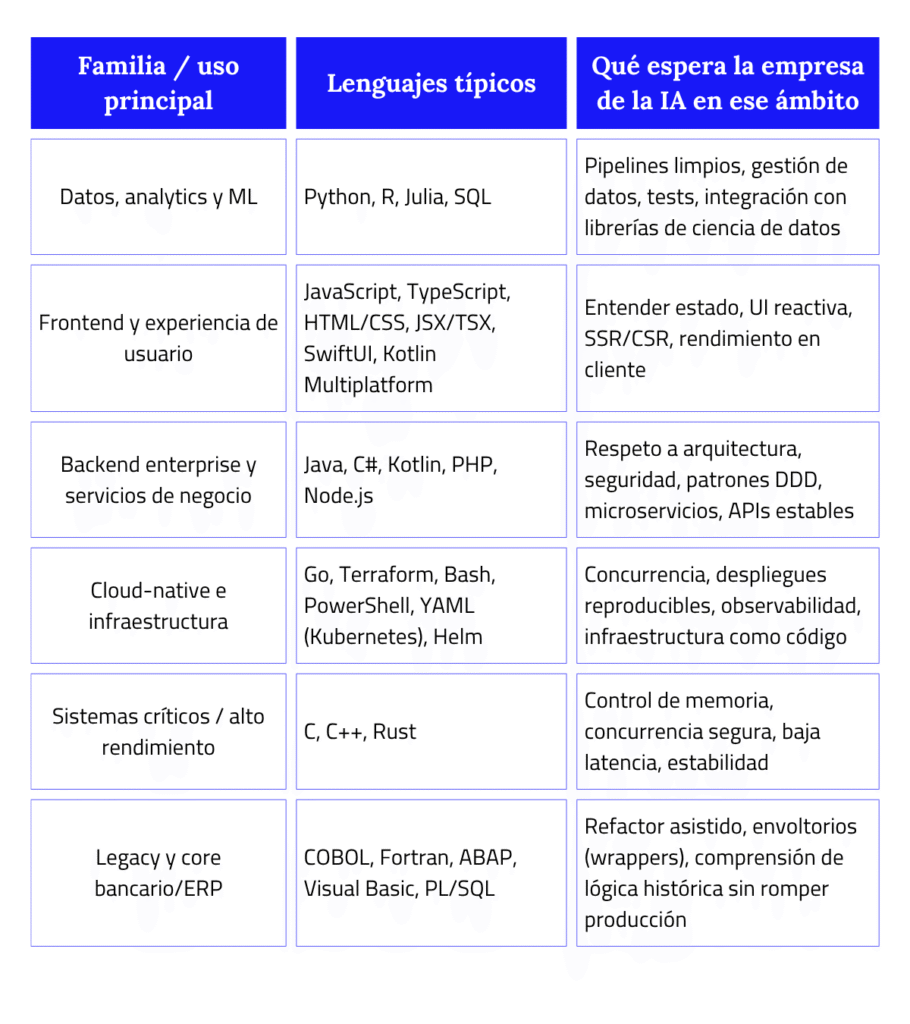

Mapa rápido: lenguajes, usos y lo que le piden a la IA

Para que esto sea útil a nivel estratégico, es más fácil verlo como familias de lenguajes y no como lista suelta:

Cómo se nota la diferencia en el día a día (por stack)

Python, R, Julia, SQL: del “script útil” al pipeline gobernado

En ecosistemas de datos, un modelo especializado ayuda a salir del caos de los scripts sueltos y a construir pipelines que se pueden mantener en el tiempo.

- Genera consultas SQL optimizadas y seguras.

- Encadena pasos de ETL sin mezclar responsabilidades ni romper la lógica de negocio.

- Sugiere validaciones con Pydantic o baterías de tests sobre Pandas/Polars.

- Entiende el uso real de librerías como NumPy, scikit-learn, TensorFlow o PyTorch.

El valor no está en escribir menos, sino en que esos pipelines sean legibles, testeables y auditables, no piezas sueltas imposibles de gobernar.

JavaScript / TypeScript, Swift, Kotlin: el infierno del estado bien gestionado

En frontend y apps, el problema no es la sintaxis: es el estado y dónde vive cada decisión.

- Reconoce el contexto: React, Vue, Svelte, Next.js, Remix, Angular… cada uno con su propia filosofía.

- Entiende patrones de gestión de estado (Redux, Zustand, MobX, signals, stores nativos).

- Sitúa correctamente la lógica entre componentes, hooks, servicios y capas de datos.

- Tiene en cuenta SSR, hydration, rutas, llamadas a APIs y rendimiento en cliente.

Un modelo especializado aquí no solo “pica código”: protege la experiencia de usuario evitando decisiones arquitectónicas que luego son muy caras de revertir.

Java, C#, Kotlin, PHP: donde la IA tiene que respetar la arquitectura o estorba

En backends enterprise, el 80 % del problema no está en el método que escribes, sino en cómo encaja en la arquitectura existente.

- Respeta las capas (controller, service, repository, dominio).

- Mantiene la coherencia de contratos: DTO, mapeos, validaciones, eventos.

- Tiene en cuenta las políticas de seguridad: autenticación, roles, permisos, auditoría.

- Entiende la integración con sistemas externos y flujos síncronos/asíncronos.

Si la IA ignora estas reglas, genera código que “funciona” pero rompe la arquitectura.

Un modelo especializado, en cambio, es capaz de:

- Proponer endpoints que respetan la capa de dominio.

- Generar tests alineados con la estructura real del servicio.

- Extender microservicios sin acoplarlos indebidamente.

Go, Terraform, YAML: cuando la latencia y el despliegue son el proyecto

En Go, Terraform o Kubernetes, los errores no se ven en el editor, se ven en producción: métricas rojas, timeouts, pods reiniciando en bucle.

- Entiende patrones de concurrencia en Go (goroutines, canales, workers).

- Genera manifiestos de Kubernetes que respetan buenas prácticas y políticas internas.

- Evita configuraciones inseguras o frágiles en IaC que luego son difíciles de rastrear.

C, C++, Rust, COBOL, ABAP: donde el error no es un bug, es un incidente

En sistemas críticos y legacy, el margen de error es mínimo. La IA está pisando terreno sensible.

- En C/C++/Rust, un fallo de memoria o concurrencia puede tumbar servicios clave.

- En COBOL, ABAP o PL/SQL, un cambio mal hecho puede afectar nóminas, facturación o contabilidad.

Los modelos especializados en estos lenguajes se entrenan para:

- Respetar patrones muy conservadores y estilos históricos del código.

- Proponer refactors seguros, graduales y acotados.

- Generar tests y harnesses que cubran la lógica antigua antes de tocarla.

- Ayudar a encapsular y envolver (wrappers) sin “modernizar por deporte”.

IDE inteligentes: cómo cambia la experiencia de desarrollo

La verdadera revolución de la IA para código ocurre en un lugar que solemos subestimar: el IDE. Cuando el entorno de desarrollo deja de ser un editor pasivo y se convierte en un espacio de razonamiento compartido entre el desarrollador, la arquitectura del sistema y los modelos de IA, la forma de construir software cambia por completo. El IDE se vuelve el punto exacto donde la IA deja de sugerir y empieza a comprender, donde las decisiones técnicas se vuelven más coherentes y donde la calidad deja de depender únicamente del criterio individual.

Del editor al cerebro operativo del equipo

Los IDE modernos ya no ejecutan herramientas; entienden contexto. Analizan el proyecto completo, las dependencias, las capas, los contratos y los cambios recientes. Y con esa visión global pueden ofrecer una experiencia que ningún editor tradicional puede imitar dentro de un entorno de IA para código.

- Identifican la estructura real del sistema.

- Reconocen patrones arquitectónicos que la empresa ha adoptado.

- Actúan en función de modelos especializados por lenguaje, no de predicciones genéricas.

- Ajustan sugerencias según el impacto en módulos, servicios o capas enteras.

Esto convierte al IDE en una herramienta que acompaña la intención técnica del equipo, no solo su velocidad.

Entender dependencias y anticipar efectos colaterales

Cualquier cambio, por pequeño que parezca, puede alterar comportamientos en cascada. Un IDE inteligente, especialmente en entornos de IA para código, lo entiende y actúa como un sistema de prevención temprana.

- Señala módulos afectados por un cambio.

- Expone rutas de ejecución que podrían romperse.

- Advierte de dependencias frágiles o acoplamientos no deseados.

- Evalúa el riesgo antes de sugerir cualquier modificación.

- Esta capacidad cambia por completo la confianza con la que un equipo hace refactorizaciones o ampliaciones del sistema.

Explicación activa del código legacy

Donde un IDE inteligente muestra verdadero valor es en su capacidad de explicar código antiguo, incluso si está mal documentado o muy fragmentado.

En lugar de respuestas vagas, ofrece rutas concretas a preguntas como:

- ¿Qué función controla realmente esta regla de negocio?

- ¿Cómo fluye la data desde este endpoint hasta el módulo de persistencia?”

- ¿Qué partes son seguras de tocar y cuáles no?

Al entender las conexiones entre archivos, servicios, funciones y modelos, el IDE reduce semanas de exploración en días, y eso transforma la velocidad de onboarding y la estabilidad del sistema.

Refactorización guiada por arquitectura

La IA embebida en el IDE no improvisa: respeta la arquitectura vigente. Y cuando ese IDE opera dentro de un entorno de IA para código, las sugerencias de refactor no solo son más rápidas, sino más seguras, más limpias y mejor alineadas al sistema.

- Detecta duplicidades de lógica repartidas entre servicios.

- Propone extracciones que refuerzan la separación de capas.

- Identifica acoplamientos indebidos y los corrige.

- Sugiere migraciones graduales sin comprometer producción.

El resultado no es “código más bonito”, sino sistemas más robustos y mantenibles.

Menos carga cognitiva, más diseño técnico

El impacto profundo de los IDE inteligentes no es operativo: es cognitivo.

Cuando las tareas repetitivas, mecánicas o de navegación manual desaparecen en un entorno de IA para código, el desarrollador puede dedicarse a pensar como arquitecto, no como operador de teclado.

- Menos tiempo buscando archivos.

- Menos esfuerzo mental recordando dependencias.

- Menos fatiga revisando patrones o convenciones.

- Más foco en diseño, intención y estrategia de software.

Los equipos que adoptan IDE inteligentes no solo generan código más rápido: generan decisiones técnicas de mejor calidad, y eso, a escala empresarial, es la diferencia entre crecer con orden o crecer con deuda.

Arquitectura técnica: por qué un middleware es la pieza que decide si la IA agrega valor o deuda técnica

La llegada de la IA para código al desarrollo no genera problemas técnicos: revela los que ya existían. Cuando cada desarrollador empieza a usar modelos distintos, cuando los IDE inteligentes toman decisiones sin contexto, cuando la IA genera código que nadie audita ni controla, el sistema se fragmenta. En ese momento es cuando las empresas entienden que la conversación no va de “más IA”, sino de quién gobierna a la IA.

Y ahí es donde un middleware como SofIA deja de ser opcional y se convierte en la pieza silenciosa que mantiene el orden en medio de la aceleración.

Sin una capa intermedia, cada IA construye un sistema distinto

La experiencia en proyectos complejos demuestra lo mismo una y otra vez: la deuda técnica no aparece porque la IA para código falle, sino porque cada modelo mira solo su parte del mapa. El motor que genera Python no entiende la lógica de los microservicios en Java. El que documenta no reconoce la gobernanza interna. El que refactoriza puede modificar una interfaz sin comprender el contrato que sostiene un dominio entero.

Cuando no existe un middleware que sincronice criterios, la arquitectura se fragmenta como si múltiples equipos trabajaran sin hablar entre sí. Un middleware existe para evitar exactamente eso: para que todas las IAs operen bajo una misma visión técnica, no bajó la suya propia.

Saber qué pasó, quién lo hizo y por qué: el fundamento de la IA responsable

Uno de los mayores cambios que trae la IA para código al desarrollo es que deja de existir el “quién escribió esto” y aparece el “qué motor lo produjo y bajo qué razonamiento”. Sin trazabilidad, la IA es una caja negra que altera infraestructura crítica sin dejar huellas.

Por eso un middleware como SofIA registra:

- El modelo que actuó.

- El razonamiento utilizado.

- Los archivos y capas que tocó.

- Las dependencias que evaluó.

- Quién invocó la acción.

Con este rastro, la IA deja de ser un riesgo invisible y se convierte en un componente auditado del ciclo de vida del software.

SofIA: plataforma corporativa de IA

La orquestación: cuando la IA trabaja como un equipo, no como herramientas aisladas

Lo que distingue a un middleware moderno no es que conecte modelos: es que los coordina con la disciplina de un arquitecto senior.

- Si la tarea afecta a un pipeline en Python, SofIA invoca un motor que entiende datos, validaciones y ETL.

- Si el cambio toca un servicio en Java, prioriza modelos que respetan capas, contratos y reglas de seguridad.

- Si alguien toca legacy, asigna agentes diseñados para modificar con prudencia quirúrgica.

- Si se necesita documentación, combina razonamiento + repositorio + política corporativa para garantizar coherencia.

Integración frente a intervención: el punto donde una empresa se juega su futuro técnico

En el día a día, la diferencia entre IA para código integrada y una IA que solo interviene es enorme.

Cuando la IA interviene, genera código, refactoriza, documenta… pero sin entender el sistema completo. Actúa como un asistente aislado, útil pero desconectado del diseño real.

Cuando la IA se integra a través de un middleware, lo hace bajo las mismas reglas, convenciones y responsabilidades que seguiría un equipo técnico disciplinado. Deja de “sugerir” para empezar a trabajar con intención arquitectónica. Ese es el salto que separa a las empresas que aceleran su arquitectura de las que la erosionan sin darse cuenta.

La madurez no se mide por cuánta IA usas, sino por la calidad de la arquitectura que la gobierna. Esa es la diferencia entre construir software que escala… y software que envejece antes de tiempo.

Riesgos reales y cómo mitigarlos con una arquitectura responsable

Trabajar con IA en entornos de desarrollo no es peligroso por lo que la IA hace abiertamente, sino por lo que puede hacer sin que nadie se dé cuenta. Los riesgos no aparecen en los grandes fallos visibles, sino en los pequeños desajustes que pasan silenciosamente a producción, en las decisiones que la IA toma fuera de contexto o en información sensible que termina en prompts que nunca debieron existir.

La arquitectura responsable existe para evitar exactamente eso: que la IA se convierta en un generador silencioso de deuda operativa, de exposición de datos o de incoherencia técnica.

Las alucinaciones que no parecen alucinaciones

En entornos de IA para código, los modelos suelen fallar de la forma más peligrosa posible: acertando en apariencia. No rompen la sintaxis, no lanzan errores, no quiebran el pipeline. Generan un fragmento de código que parece válido, compila e incluso pasa algunos tests… pero altera un contrato, rompe un flujo o introduce un comportamiento sutilmente incorrecto.

Esa es la verdadera amenaza: la alucinación silenciosa. Una IA que “se inventa” un método privado, que asume un patrón que el equipo abandonó hace meses, o que simplifica una lógica de negocio porque su entrenamiento no entendió la regla completa.

La mitigación aquí no es perseguir la perfección del modelo, sino incorporar un sistema capaz de validar la intención técnica, no solo la sintaxis. Y ese rol lo cumple la arquitectura de control: políticas, validadores, razonamiento sobre dependencias y trazabilidad estricta de cada decisión.

Sobregeneración: cuando la IA tiene razón pero el sistema queda peor

En entornos de IA para código, uno de los riesgos más comunes es la sobregeneración:

- Código que funciona… pero que no debería existir.

- Fragmentos innecesarios que duplican lógica,

- Clases completas para resolver problemas simples.

- Patrones que no pertenecen al estilo corporativo.

- Abstracciones que suenan bien pero enturbian el dominio.

- Capas enteras que la IA crea porque “cree” que es arquitectura limpia.

La única manera de frenarla es que el sistema disponga de una capa que evalúe la pertinencia, no sólo la corrección. Y esta es una función típica de un middleware como SofIA: contextualizar antes de generar.

La exposición accidental: cuando un prompt abre una brecha

En entornos de IA para código, el riesgo más subestimado no está en el código: está en el texto que acompaña al código.

Un desarrollador que pega en un prompt una traza de error con datos sensibles, un JSON con credenciales, una consulta SQL con información privada o un fragmento de un sistema financiero sin anonimizar… y la fuga ya ocurrió.

Por eso una arquitectura madura no confía en la buena intención de los equipos, sino en controles automáticos: filtros que detectan patrones sensibles, políticas que bloquean ciertos tipos de información, reglas de sanitización que se aplican antes de que el prompt salga del perímetro de la empresa. Si la IA es poderosa, la protección debe serlo más.

La dependencia excesiva: cuando el equipo deja de razonar y solo “pide”

En proyectos que incorporan IA para código, el riesgo cultural es tan serio como el técnico:

- Desarrolladores que dejan de revisar lo que la IA sugiere,

- Decisiones arquitectónicas tomadas según “lo que el modelo propone”,

- Pérdida de criterio técnico,

- Estancamiento del conocimiento del stack.

La IA para código no sustituye la responsabilidad técnica del equipo; solo amplifica su capacidad. Una arquitectura responsable incorpora límites intencionales: revisiones obligatorias, políticas que fuerzan la explicación del cambio, auditoría previa al merge y restricciones por tipo de tarea. La dependencia disminuye cuando el sistema exige pensamiento, no solo ejecución.

Gobernanza real: controles que actúan antes del error, no después

En cualquier entorno de IA para código, un ecosistema responsable incorpora defensas distribuidas: control de permisos, espacios aislados para pruebas, auditoría continua, logs explicativos y un pipeline que no permite que nada avance sin haber sido verificado.

Esto no ralentiza el desarrollo; lo estabiliza. Impone una disciplina donde la IA solo puede actuar dentro de márgenes definidos, donde cada acción queda registrada y donde cada intervención es trazable hasta su origen.

Cuando el sistema funciona así, la IA deja de ser un riesgo potencial y se convierte en un componente confiable del ciclo de vida del software. La clave nunca estuvo en hacer modelos perfectos, sino en construir arquitecturas que no permitan errores silenciosos.

Reflexión final

Hay un punto en el que toda empresa que desarrolla software acaba llegando: entender que la IA para código no es un atajo, sino un espejo. Refleja la madurez del stack, la solidez de la arquitectura y la claridad con la que el equipo toma decisiones. Cuando la IA se integra bien, el sistema se vuelve más ordenado, más explícito, más coherente. Cuando se integra mal, no acelera nada: solo amplifica el desorden.

El verdadero valor de la IA para código no está en el output, sino en la conversación técnica que provoca: obliga a definir estándares, a documentar mejor, a pensar en cómo se conectan los componentes y a elevar el nivel de ingeniería. Paradójicamente, la IA no reduce el criterio técnico; lo hace más necesario. Y quienes entienden esto temprano terminan construyendo sistemas que envejecen mejor.

Lo que viene ahora no es una avalancha de modelos más grandes, sino equipos que usan la IA con más precisión y más criterio arquitectónico. Equipos que saben cuándo dejar que la IA genere, cuándo pedirle que valide y cuándo exigirle que explique. Equipos que no dependen del modelo, sino de la arquitectura que los sostiene. Esa es la ventaja competitiva real: un entorno donde la IA potencia la ingeniería, no la reemplaza.

Y si estás en ese punto donde sabes que tu organización necesita algo más que “probar un asistente”, es probablemente el momento adecuado para explorar cómo una arquitectura gobernada (con el middleware adecuado) puede ayudarte a dar el salto en un entorno donde la IA para código ya es parte del día a día. Déjanos tus datos y conversemos sobre cómo llevar tu stack al siguiente nivel, con criterio, control y una estrategia que realmente funcione para tu empresa.