Cuanta más importancia toman los datos en las organizaciones, más se hace crucial contar con herramientas ETL que permitan administrar los datos a gran escala. En este artículo, exploraremos el valioso papel que juegan las herramientas ETL en los proyectos de procesamiento de datos. Desde la extracción de datos hasta la carga en el destino, conocer estas herramientas es clave para todo data engineer.

¿Qué es ETL?

ETL significa Extracción, Transformación y Carga. Es un proceso súper importante en el mundo de la ingeniería de datos. Aprovechamos las herramientas ETL para crear flujos de trabajo automatizados y manejar la complejidad de los datos. Garantizando que la información sea coherente y de calidad.

A grandes rasgos, el proceso arranca con la extracción de datos, desde diferentes fuentes. Luego, viene la transformación, donde limpiamos y preparamos esos datos. Finalmente, cargamos todo en el destino deseado.

Herramientas ETL más utilizadas en ingeniería de datos

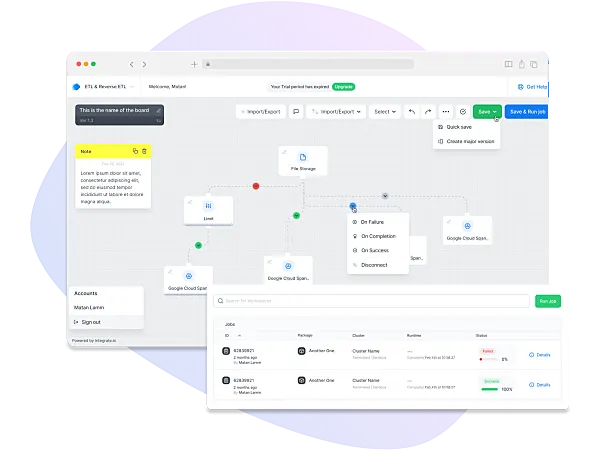

Integrate.io

Es una herramienta ETL en la nube con una interfaz muy amigable, incluso para miembros del equipo con menos conocimientos técnicos.

Lo genial de integrate.io es que puede conectarse con varias fuentes de datos, desde bases de datos hasta sistemas CRM, así que no hay límites para integrar tus datos de manera sencilla. Y lo más importante, la seguridad. Cumple con los estándares clave como GDPR e HIPPA para mantener tus datos protegidos.

PowerCenter

Es una herramienta muy conocida por su capacidad de manejar grandes volúmenes de datos, es perfecta tanto para pequeñas como grandes empresas.

Lo sorprendente es que esta herramientas ETL ofrece conectores nativos para un montón de fuentes de datos, desde bases de datos hasta aplicaciones empresariales y plataformas en la nube. Así que puedes integrar tus datos desde cualquier lugar sin complicaciones.

PowerCenter viene con funciones de automatización y programación, lo que hace que la ejecución de flujos de trabajo sea pan comido. Además, se integra perfectamente con herramientas de Business Intelligence y análisis. Es una herramienta ETL ampliamente utilizada y aun que su uso viene siendo reemplazado por otras para nuevos desarrollos, la realidad es que muchos sistemas empresariales de toma de decisiones con datos se siguen basando en ella.

IBM InfoSphere DataStage

Es una herramienta ETL increíble y poderosa ampliamente utilizada en el mundo de la ingeniería de datos. Lo que realmente la hace destacar es su alto rendimiento, lo que la convierte en una opción ideal para manejar grandes volúmenes de datos en entornos heterogéneos.

Una de las cosas que más adoran los ingenieros de datos de las herramientas ETL es que tenga una interfaz gráfica de usuario, que permita diseñar flujos de trabajo visualmente pues IBM lo tiene todo. ¡Imagina poder gestionar procesos ETL complejos con solo unos clics!

También permite a los usuarios crear componentes reutilizables y disfrutar de una amplia gama de transformaciones y operaciones avanzadas. Lo mejor es que esta herramienta se integra de manera nativa con otras soluciones IBM, como IBM InfoSphere Information server, así obtienes una suite completa para la gestión y gobierno de datos de toda la organización.

Oracle Data Integrator (ODI)

Esta herramienta es como un mago que facilita la conexión entre diversas fuentes y destinos de datos. Simplifica los flujos de trabajo ETL y las operaciones de integración, tanto en tiempo real como en lotes.

Se integra de manera nativa con las bases de datos de Oracle, lo que es una ventaja para las empresas que utilizan estas tecnologías.

La arquitectura ODI está diseñada pensando en la reutilización de componentes y transformaciones, lo que lo convierte en un aliado para diferentes proyectos. ¡Así puedes optimizar tu tiempo y esfuerzo al máximo!

Además, puedes realizar operaciones complejas y enriquecer los datos antes de cargarlos en el destino final. Y lo mejor de todo viene con una amplia variedad de conectores listos para usar: Hadoop, EREP, CRM, XML, JSON, LDAP, JDBC, ODBC y mucho más.

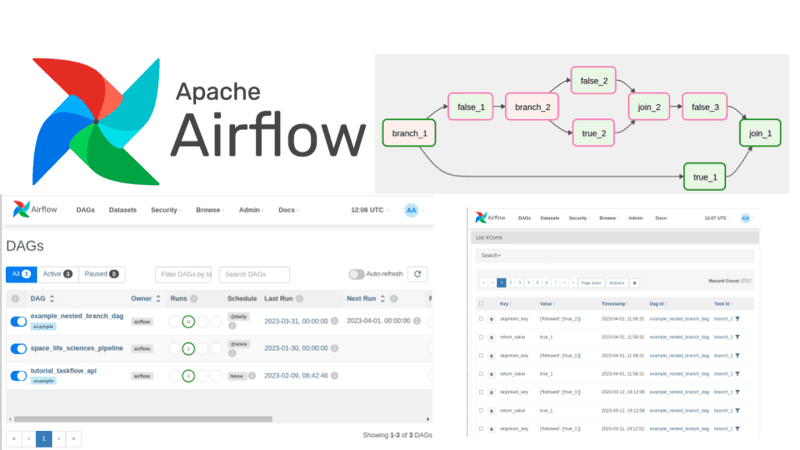

Apache Airflow

Es una herramienta asombrosa y eficiencia en el manejo de tareas ETL programadas y automatizadas.

Airflow se basa en la ingeniosa idea de «Directed Acyclic Graphs» (DAGs) para representar las relaciones entre tareas. Parece complicado, pero en realidad es bastante sencillo.

Cada tarea depende de otra y juntos forman un flujo de trabajo perfectamente coordinado. Una de las cosas más geniales que buscan los ingenieros de datos es que las herramientas ETL pueden definir flujos de trabajo complejos usando scripts Python.

En Airflow, cada tarea se representa como un nodo en el DAG. ¡Imagina un mapa visual que te guía a través de cada paso del proceso!

AWS Glue

Es un servicio de herramientas ETL proporcionado por Amazon Web Services (AWS). Una de las cosas más geniales es que es totalmente administrado lo que significa que se encarga de todo el trabajo pesado para que tú puedas concentrarte en lo que realmente importa: los datos y proyectos.

Es un servicio altamente escalable y flexible, que se adapta perfectamente a tus necesidades sin importar cuán grandes o complejos sean tus datos. Lo mejor es que AWS Glue hace que el procesamiento y transformación de datos en la nube sea muy sencillo.

Ofrece la capacidad de descubrir, catalogar y procesar datos desde diversas fuentes y cargarlos en destinos específicos en el entorno de AWS.

Eso no es todo AWS Glue tiene tres componentes principales que lo hacen aún más poderoso y completo:

- Data Catalog: Es una catálogo de metadatos administrado y centralizado que te proporciona información sobre datos disponibles para procesar.

- Crawler: Es utilizado para descubrir y catalogar los datos en diferentes fuentes.

- Job Executor: Esta joya utiliza el lenguaje de scripting basado en Apache Spark, para aplicar transformaciones y cargar datos en diferentes destinos.

Azure Data Factory (ADF)

Es un servicio de orquestación y transformación de datos en la nube creado por Microsoft Azure. Como tener tu propio director de orquesta para tus datos, guiándonos de manera eficiente y armoniosa.

Ha sido diseñado para facilitar todo el movimiento, transformación y carga de datos desde diferentes fuentes hacia destinos específicos, permitiendo a los usuarios crear flujos de trabajo ETL (Extracción, Transformación y Carga) de manera fácil y escalable.

Los componentes principales de ADF son:

- Pipelines y flujos de trabajo: Son como corrientes de datos que fluyen de manera ordenada y coordinada, llevando a cabo actividades como copiar y transformar datos.

- Conectores: Esto permite conectarse a diversas fuentes y destinos de datos, desde SQL, Azure Blob Storage, Azure Data Lake Storage, servicios SaaS y más. Es como tener un mapa de conexiones que te ayuda a llegar a cualquier lugar que desees.

- Actividades: Son pequeñas tareas dentro de los pipelines, como copiar o transformar datos.

- Disparadores: (Triggers), Puedes programarlos basados en tiempo o eventos, lo que inicia automáticamente la ejecución de pipelines.

- Orquestación: ADF se asegura de que todas las actividades se ejecuten en el orden correcto, lo que garantiza una armoniosa coordinación de tareas.

Google Cloud Dataflow

Es una herramienta que permite llevar tus procesamientos de datos a otro nivel. Este servicio administrado, proporcionado por Google Cloud Platform, te quitará toda la preocupación técnica y te permitirá enfocarte en lo que realmente importa: analizar y transformar tus datos con creatividad y precisión.

Lo increíble de Dataflow es que se basa en el modelo de programación Apache Beam, lo que te brinda flexibilidad para crear flujos de trabajo de procesamiento de datos. Esto no es todo lo más sorprendente es que es una de las herramientas ETL que permite su integración perfecta con otros servicios de Google Cloud.

Algunos de sus componentes principales:

- Pipeline: Es el núcleo donde definirás el flujo de tus datos y cómo se transforman en un viaje emocionante hacia la obtención de conocimientos valiosos.

- Transformaciones: Con ellas, podrás darle vida a la información y hacer que cobre sentido de una manera totalmente nueva y sorprendente.

- Acciones: Aquí es donde tus resultados cobran vida y donde podrás llevar a cabo las acciones más impresionantes.

Lo que más te encantará es su escalabilidad: no importa cuán grandes sean tus datos o cuántos proyectos tengas en mente, Dataflow está preparado para acompañarte en cada paso del camino.

Herramientas ETL que quedaron en el olvido

Estas herramientas ETL, que en su momento fueron pioneras en el procesamiento de datos y transformación, han sido superadas por soluciones más avanzadas y eficientes. El vertiginoso avance de la tecnología, las cambiantes demandas de las empresas y la necesidad constante de adaptarse a entornos de datos más complejos han dejado en segundo plano a estas herramientas obsoletas. A continuación descubre algunas de las herramientas ETL que han quedado en el olvido:

Oracle Warehouse Builder: Imagina una herramienta que una vez fue un aliado confiable en la construcción de almacenes de datos, transformando tus datos en información valiosa. Sin embargo, la tecnología avanza sin pausa y esta herramienta ha sido reemplazada por opciones más modernas y flexibles, como Talend Data Integration o Microsoft Azure Data Factory.

Apatar: Solía ser una opción popular para la integración y manipulación de datos. Sin embargo, su falta de actualizaciones regulares, limitaciones en escalabilidad y carencia de características avanzadas llevaron a los usuarios a buscar soluciones más robustas y actualizadas en el ámbito de la integración de datos. La evolución en las herramientas ETL demanda opciones que se adapten y crezcan con las necesidades, y es por eso que Apatar ha cedido el paso a herramientas más dinámicas y en sintonía con los desafíos actuales en la gestión de datos.

Scriptella: En su época, destacó por su enfoque sencillo y su habilidad para gestionar diversas conexiones y formatos de datos. Sin embargo, la ausencia de desarrollo y actualizaciones frecuentes fue un factor determinante en su reemplazo. La demanda de soluciones más avanzadas impulsó la llegada de herramientas ETL como Apache Nifi, Apache Camel y Talend, que ofrecen un mayor potencial para abordar los retos cambiantes de la integración de datos.

CloverETL Community Edition: Fue una herramienta ETL de código abierto que permitía a los usuarios la posibilidad de diseñar, transformar y cargar datos de múltiples fuentes. No obstante, a medida que las demandas de procesamiento de datos evolucionaron y la integración se volvió más sofisticada, CloverETL Community Edition reveló sus limitaciones en escalabilidad y funcionalidades avanzadas.

Syncsort DMX: Esta herramienta ofrecía funcionalidades para procesar datos a gran escala, realizar transformaciones complejas y cargar información en diferentes sistemas y plataformas. Fue reemplazado por la necesidad de una mayor escalabilidad, flexibilidad y capacidades avanzadas de análisis que las soluciones más modernas pueden proporcionar.

Una reflexión final

¿No te parece fascinante cómo estas poderosas herramientas ETL pueden cambiar la forma en que gestionamos los datos?

Las herramientas ETL son el corazón palpitante de los proyectos exitosos de procesamiento de datos. Son la ayuda para transformar datos crudos en información valiosa y coherente permitiendo la toma de decisiones informadas y acertadas. Con estas herramientas como ingeniero de datos, tienes el poder de llevar tus proyectos a niveles completamente nuevos.

No pierdas ni un segundo más, ¡es hora de impulsar tu conocimiento y crecimiento en la ingeniería de datos! Suscríbete a nuestra lista de correo y recibe contenido exclusivo directamente en tu bandeja de entrada. Te mantendremos actualizado con las últimas novedades, tendencias y valiosos consejos para que sigas conquistando el dinámico mundo de la gestión de datos. Además puedes ponerte en contacto con nuestro equipo de expertos para más información.