Imagina un pintor que no necesita un lienzo, sino a partir de meras palabras puede crear paisajes pintorescos hasta dar vida a criaturas míticas. La IA generativa de texto a imagen hace exactamente eso, y abre puertas a nuevas dimensiones de colaboración entre humanos y máquinas.

En este artículo, profundizaremos el estado del arte de este campo que avanza rápidamente, explorando modelos pioneros como MidJourney y Stable Diffusion, al mismo tiempo que descubriremos un espectro de enfoques innovadores que redefinen cómo percibimos y creamos contenido visual.

Pero antes descubriremos la IA generativa, como funciona, sus principales arquitecturas y algunos ejemplos. ¡Comencemos!

IA Generativa: Un Vistazo Detrás del Telón

La IA generativa es un tipo especial de inteligencia artificial que se enfoca en crear cosas nuevas y originales. En lugar de solo reconocer o clasificar, como hacen otras formas de IA, esta tiene la capacidad de generar contenido.

¿Cómo lo hace? Los modelos de la IA generativa están entrenados en un conjunto de datos masivos, este conjunto de datos les permite aprender las relaciones entre elementos que componen diferentes tipos de contenido.

Por ejemplo, le dices a la IA generativa que imagine un paisaje con atardecer, la IA toma esta descripción y basándose en datos y patrones que ha aprendido sobre lo que es un atardecer, crea una imagen que coincida con esa descripción.

Es como si tuviera imaginación propia y la capacidad de interpretar y materializar estas ideas.

Principales arquitecturas en IA Generativa

Existen varias arquitecturas en el campo de la inteligencia artificial generativa, cada una con sus ventajas y aplicaciones específicas. A continuación exploraremos las más destacadas:

Generative adversarial networks (GANs): Los GANs son una de las arquitecturas más populares en IA generativa. Consiste en dos redes neuronales, el generador y el discriminador que se entrenan de manera adversarial.

Por ejemplo, supongamos que tienes dos compañeros uno es el generador y el otro el discriminador. El generador se encarga de inventar cosas que se parezcan mucho a la realidad, mientras que el discriminador se dedica a distinguir entre las cosas reales y lo que inventa el creador.

Este proceso de competencia impulsa a la red a mejorar constantemente sus habilidades generativas.

Redes neuronales recurrentes (RNNs) y long short-term memory (LSTM): Son arquitecturas clave en el campo de la IA generativa, diseñadas para trabajar con secuencias de datos, como texto o audio.

Los RNNs tienen la habilidad especial para recordar cosas de etapas anteriores en la secuencia. Lo que hace que puedan entender contextos de datos que siguen un orden.

Los LSTMs, por otro lado, son como los RNNs mejorados. Pueden capturar relaciones a largo plazo en las secuencias, como esos detalles importantes que se extienden en el tiempo.

Transformers: Los modelos transformers destacan por su procesamiento de lenguaje natural y también en la generación de texto.

Lo interesante es como trabajan usan un mecanismo de atención que les permite procesar un montón de información en tiempo real.

Un ejemplo muy famoso de estos modelos es el chatGPT.

Variational Autoencoders (VAEs): Los VAEs son modelos probabilísticos que aprenden representaciones latentes de datos.

Cuentan con dos partes clave: un codificador y un decodificador. El codificador toma la entrada y la convierte de forma especial en un secreto. Luego, el decodificador toma este secreto y lo transforma de vuelta en la entrada original.

Autoregressive Models: Los modelos autorregresivos, dentro del ámbito de la IA generativa, se basan en lo que han hecho antes, imagina que estás dibujando y cada trazo se basa en el anterior.

Son generadores de datos uno a la vez, cada nueva parte se construye sobre la anterior, por ejemplo son geniales para predecir cosas en secuencias.

Aplicaciones exitosas

La IA generativa ha sido un impacto en diversos campos. A continuación te mostraré algunos ejemplos:

- Arte y creatividad: Estos modelos han demostrado la capacidad de generar arte visual a partir de descripciones textuales.

- Diseño y moda: Algunos modelos están siendo utilizados para crear diseños de moda únicos y creativos.

- Cine y entrenamiento: En la industria del cine, la IA se utiliza para crear efectos visuales impresionantes y escenas realistas.

- Música y Composición: Algunos modelos pueden generar música original basada en patrones y estilos musicales dados.

- Medicina y Ciencias de la Salud: En medicina, la IA generativa se aplica en la creación de imágenes médicas detalladas y en la simulación de tejidos para propósitos educativos y de entrenamiento.

- Publicidad y Marketing: La generación de contenido visual atractivo y personalizado es crucial en la publicidad. La IA generativa puede crear imágenes y anuncios adaptados a audiencias específicas.

Ahora sí, exploremos los modelos que están marcando un hito en la IA generativa de texto a imagen en detalle.

Modelos más usados de la IA Generativa

MidJourney

MidJourney es un brillante ejemplo de IA generativa de texto a imagen, que combina una arquitectura basada en transformadores con redes generativas adversarias (GAN). Esta fusión permite al modelo tejer imágenes intrincadas a partir de indicaciones textuales, capturando detalles matizados con un realismo asombroso.

La integración de señales textuales y visuales permite a MidJourney crear paisajes vívidos, pintar escenarios de ensueño con notable precisión y elevar el potencial de la creación artística asistida por IA.

Generación guiada CLIP

La generación guiada por CLIP se basa en la sinergia de la visión y el lenguaje, aprovechando el enfoque contrastivo de imagen y lenguaje conocido como (CLIP) característico en el campo de la IA generativa. Este modelo genera imágenes que se alinean con descripciones textuales optimizando las puntuaciones de similitud de imágenes según el modelo CLIP.

El resultado es una fusión sorprendente entre el lenguaje y elementos visuales, lo que marca el comienzo de una nueva era en la síntesis de imágenes, llenas de coherencia y significado.

Stable Diffusion

Stable Diffusion toma una ruta distinta en el panorama de la IA generativa de texto a imagen al centrarse en la estabilidad y el control detallado de la generación de imágenes.

Este modelo utiliza una técnica basada en difusión para refinar de manera iterativa una señal de ruido y así producir imágenes. Esto significa que los usuarios pueden ajustar características visuales a partir de texto.

El enfoque único de Stable Diffusion produce imágenes coherentes y diversas.

Esto facilita la creación de imágenes personalizadas para una amplia gama de aplicaciones, desde la creación de prototipos de diseño hasta la ilustración narrativa.

DALL·E

Este modelo crea imágenes a partir de indicaciones textuales, desafiando los límites de la creatividad al generar imágenes de conceptos no convencionales. Desde “una casa rosa de dos pisos con forma de zapato” hasta “un cubo hecho del cielo nocturno”, DALL·E nos muestra el potencial de la IA generativa para dar vida a ideas surrealistas. Esto sin duda alimenta debates sobre la intersección de la creatividad y la inteligencia artificial.

¿Kandinsky-2 supera a MidJourney? Un innovador modelo de código abierto convierte texto en imágenes.

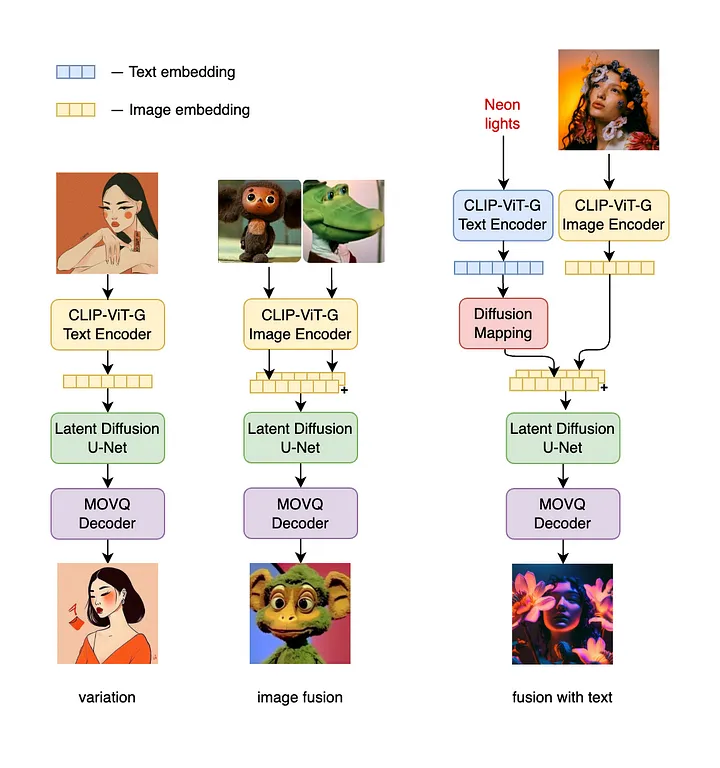

Imagina que Kandinsky-2 es un artista digital super avanzado. Ahora, con el modelo Kandinsky 2.2 se ha dado un salto increible desde la 2.1. Han añadido un codificador de imágenes mejorado llamado CLIP-ViT-G que hace maravillas con las creaciones. Además de la innovadora adición de ControlNet para un mayor soporte.

El uso de CLIP-ViT-G como codificador de imágenes marca un avance significativo en las capacidades de generación de imágenes del modelo. Ahora, no solo produce imágenes más agradables estéticamente sino que también están mejor alineadas con la entrada de texto, enriqueciendo así el rendimiento general del modelo.

La incorporación del mecanismo ControlNet permite al modelo ejercer un control preciso sobre el proceso de generación de imágenes. Esto se traduce en resultados que exhiben mayor precisión y atractivo visual, abriendo nuevas posibilidades para la manipulación de imágenes guiada por texto, en el campo de la IA generativa.

La arquitectura detrás de Kandinsky-2

Aquí vamos a nombrar los puntos clave de la arquitectura que hay detrás de este modelo y cual es el proceso para crear contenido único y cautivador.

- Codificador de texto (XLM-Roberta-Large-Vit-L-14) — 560M

- Imagen de difusión anterior: 1B

- Codificador de imágenes CLIP (ViT-bigG-14-laion2B-39B-b160k) — 1,8B

- U-Net de difusión latente: 1,22 mil millones

- Codificador/descodificador MoVQ: 67M

Puntos de control de Kandinsky-2

Estos puntos de control representan las diferentes capacidades y enfoques de los modelos de difusión en diversas tareas de procesamiento de imágenes en el ámbito de la IA generativa.

- Anterior: Un modelo de difusión anterior que asigna incrustaciones de texto a incrustaciones de imágenes.

- Texto a imagen / Imagen a imagen: un modelo de difusión de decodificación que asigna incrustaciones de imágenes a imágenes

- Inpainting: un modelo de difusión de decodificación que asigna incrustaciones de imágenes e imágenes enmascaradas a imágenes

- ControlNet-profundidad: un modelo de difusión de decodificación que combina representaciones de imágenes con información adicional de profundidad para generar imágenes detalladas.

Optimización para su uso

Es importante tener en cuenta que los modelos de Kandinsky , debido a su arquitectura compleja y gran cantidad de parámetros, requieren recursos computacionales sustanciales para un funcionamiento eficaz en el ámbito de la IA generativa.

Si estás considerando usar estos modelos para tareas de manipulación o generación de texto a imagen, es esencial evaluar las especificaciones de hardware disponibles.

Por ejemplo, ejecutar los modelos en hardware con recursos limitados, como mi RTX 2060 con 8 GB de VRAM, puede enfrentar desafíos debido a limitaciones de memoria.

La arquitectura extensa del modelo y las demandas de procesamiento pueden provocar errores de falta de memoria o cuellos de botella en el rendimiento en dichas configuraciones de hardware.

Lo que vas a necesitar para instalarlo

Vamos a ponernos manos a la obra y para eso, primero necesitamos asegurarnos de tener todo lo que necesitamos para instalar Kandinsky-2. Así que te voy a guiar a través de elementos clave que vas a necesitar.

!pip instalar 'git+https://github.com/ai-forever/Kandinsky-2.git'

!pip instalar git+https://github.com/openai/CLIP.git

Ejecuta el modelo con par de líneas de código

Te mostraré como puedes ejecutarlos con tan solo un par de líneas de código. No te preocupes, será pan comido

de kandinsky2 importar get_kandinsky2

model = get_kandinsky2( 'cuda' , task_type= 'text2img' , model_version= '2.1' , use_flash_attention= False )

image_cat = model.generate_text2img(

"gato rojo, foto 4k" ,

num_steps= 100 ,

lote_size= 1 ,

Guia_escala= 4 ,

h= 768 , w= 768 ,

muestra= 'p_sampler' ,

prior_cf_scale= 4 ,

prior_steps= "5"

)[ 0]Aquí se pueden elegir diferentes versiones de modelos: 2.0, 2.1, 2.2.

Ventaja frente a otros modelos

Una ventaja notable que distingue a los modelos de Kandinsky de otros modelos de IA generativa de texto a imagen es su capacidad para fusionar a la perfección el poder de las descripciones textuales con una combinación de dos imágenes.

Esta característica tan especial nos abre una nueva puerta a la exploración creativa permitiéndonos crear imágenes que surgen de una mezcla de diferentes elementos visuales.

A diferencia de los modelos tradicionales de texto a imagen de IA generativa que se basan únicamente en indicaciones textuales para generar imágenes, los modelos de Kandinsky introducen un enfoque novedoso al permitir a los usuarios proporcionen no sólo descripciones textuales sino también una combinación de dos imágenes.

Esta capacidad trasciende los límites de la síntesis de imágenes convencional, dando lugar a resultados innovadores que exhiben una combinación intrigante de contenido visual diverso.

Uso de imágenes de fusibles

Generemos otra imagen, como un tigre:

image_tiger = model.generate_text2img(

"tigre" ,

num_steps= 100 ,

tamaño de lote = 1 ,

escala_orientación = 4 ,

h = 768 ,

w = 768 ,

muestra = 'p_sampler' ,

prior_cf_scale = 4 ,

prior_steps = "5"

) [ 0 ]

tigerY ahora combinémoslo usando el mix_imagemodelo 🐈+🐅 =❓:

image_mixed = model.mix_images(

[image_cat, image_tiger], [ 0.5 , 0.5 ],

num_steps= 100 ,

tamaño_de_lote = 1 ,

escala_de_orientación = 4 ,

h = 768 ,

w = 768 ,

muestra = 'p_sampler' ,

escala_cf_antes = 4 ,

pasos_priorales = "5" ,

)[ 0 ]

Hemos creado un nuevo animal raro y hermoso, es asombroso, ¿no?

Autores

Este artículo extiende su gratitud y reconocimiento a los estimados autores que han liderado el camino en los avances que estamos discutiendo aquí. Gracias a su dedicación y esfuerzo, hemos visto un progreso increíble el campo de la IA generativa ha sido testigo de un progreso notable en los últimos años.

- Arseniy Shakhmatov: Github , Blog

- Anton Razzhigaev: Github , Blog

- Aleksandr Nikolich: Github , Blog

- Vladimir Arkhipkin: Github

- Ígor Pavlov: Github

- Andréi Kuznetsov: Github

- Denis Dimitrov: Github

Reflexionemos

En el encantador reino donde la IA converge con el arte, el dominio de la IA generativa de texto a imagen es un testimonio de las fronteras ilimitadas de la colaboración entre humanos y máquinas.

Este artículo ha iluminado el extraordinario viaje emprendido por innovadores y desarrolladores que han forjado un camino hacia esta cautivadora intersección. Al concluir esta exploración, nos encontramos inmersos en el impresionante panorama de Kandinsky 2.2, un modelo que trasciende a sus predecesores con una variedad de características y capacidades innovadoras.

El notable ascenso de Kandinsky 2.2 encarna una fusión de precisión e imaginación, redefiniendo la generación de texto a imagen. La integración del codificador de imágenes CLIP-ViT-G presagia una era de estética mejorada y mayor alineación con la entrada de texto, mostrando una evolución que enriquece la destreza creativa del modelo.

La integración del mecanismo ControlNet eleva aún más el panorama, permitiendo a los creadores esculpir imágenes matizadas guiadas por texto, un testimonio del poder de la expresión artística guiada por la Inteligencia Artificial.