Los LMS se han consolidado como la base operativa del aprendizaje digital. Administran cursos, usuarios y evaluaciones con precisión, garantizan trazabilidad y facilitan la gestión académica o corporativa a gran escala. Sin embargo, cuando las organizaciones buscan una formación más personalizada, medible y adaptable, la arquitectura tradicional del LMS necesita una extensión que le permita evolucionar sin comprometer su estabilidad.

El middleware de inteligencia artificial responde a ese punto de inflexión. Esta capa intermedia conecta el LMS con algoritmos de machine learning, motores de análisis predictivo y sistemas externos, permitiendo que la gestión del aprendizaje se vuelva más inteligente y dinámica. En lugar de centralizar únicamente información, interpreta patrones, automatiza decisiones y orquesta flujos de datos bajo reglas de negocio definidas.

Con esta integración, el LMS amplía su alcance: gana gobernanza, fortalece la seguridad de los datos y alcanza una escalabilidad capaz de sostener grandes volúmenes de usuarios y procesos. El resultado es una infraestructura más sólida, preparada para anticipar necesidades y operar con inteligencia distribuida, manteniendo la coherencia y el control en cada capa del ecosistema formativo.

El límite crítico del LMS no está en la gestión, sino en la gobernanza

En la mayoría de las organizaciones el LMS se entiende como el núcleo que gestiona cursos, usuarios y evaluaciones. Su arquitectura garantiza orden y operatividad, pero fue concebida para administrar, no para gobernar. En ese diseño, la trazabilidad de las decisiones, la auditoría de los procesos y la explicabilidad de los resultados quedan muchas veces fuera del alcance del propio sistema.

El desafío aparece cuando el LMS integra algoritmos de inteligencia artificial: motores de recomendación, predicción del rendimiento o personalización de contenidos. En ese punto, la falta de un marco de gobernanza sólido se vuelve un riesgo real. ¿Cómo se explica una decisión automatizada? ¿Quién valida los datos que la originan? ¿Dónde se almacena la lógica detrás del modelo? Estas preguntas definen la madurez tecnológica de la plataforma.

Gobernanza vs. gestión operativa en el LMS

El LMS cumple con su función esencial: organizar cursos, usuarios y evaluaciones, pero no controla cómo se toman ni se explican las decisiones impulsadas por la IA. Cuando un algoritmo sugiere un módulo de capacitación, la falta de registro de origen o de criterios claros genera desconfianza y puede bloquear la adopción. Este punto de dolor se centra en la ausencia de auditoría y explicabilidad integradas.

- En la práctica, un LMS tradicional documenta con precisión quién se inscribe, qué curso realiza y qué resultados obtiene. Pero rara vez conserva los factores que explican el porqué de cada recomendación o predicción generada por los modelos de IA: variables de entrada, ponderaciones, nivel de confianza, fecha de ejecución o versión del modelo. Sin ese registro, el sistema solo muestra el resultado, no la lógica detrás de él.

- Esa carencia implica que cuando una recomendación errónea o de un sesgo en la predicción, limita tanto la capacidad de mejora del propio LMS como la confianza de los usuarios en sus decisiones automatizadas. La gestión operativa se mantiene, pero la gobernanza del conocimiento, su trazabilidad, su validación y su transparencia queda incompleta.

Falta de trazabilidad y explicabilidad: el punto de dolor principal

Cuando una recomendación generada por IA sin registro de origen o sin criterios claros genera desconfianza entre instructores, estudiantes y administradores. Por ejemplo, si el LMS sugiere un módulo de capacitación y el usuario no entiende por qué, la percepción de “caja negra” puede frenar la adopción de la solución y, en entornos regulados, incluso violar requisitos de cumplimiento. Los síntomas típicos son:

Los síntomas más comunes de este problema son claros:

- Ausencia de auditoría: no hay logs estructurados que permitan reconstruir el proceso de decisión y verificar cómo se generó una recomendación.

- Falta de explicabilidad: los modelos de IA no exponen los factores que influyeron en la recomendación; no se muestran los pesos de las variables, los umbrales ni los escenarios alternativos.

- Riesgo de sesgo: sin visibilidad, es imposible detectar y mitigar sesgos algorítmicos que puedan afectar la equidad del aprendizaje, por ejemplo discriminación por género, origen, condiciones personales o demográficas.

Estas limitaciones reducen la confianza en la tecnología y pueden tener implicaciones legales significativas, especialmente en instituciones educativas o corporativas sujetas a marcos como el EU AI Act, el Reglamento General de Protección de Datos (GDPR) o la norma ISO/IEC 42001:2023 sobre gestión responsable de sistemas de IA.

Arquitectura de gobernanza basada en middleware de IA

El límite crítico de un LMS no está en su capacidad de gestión, sino en cómo gobierna el uso de la inteligencia artificial. Un middleware de IA actúa como una capa intermedia que no sustituye al LMS, sino que lo fortalece con trazabilidad, aplicabilidad y cumplimiento normativo. Su función es orquestar la toma de decisiones automatizadas, asegurando transparencia y control en todo el ecosistema educativo.

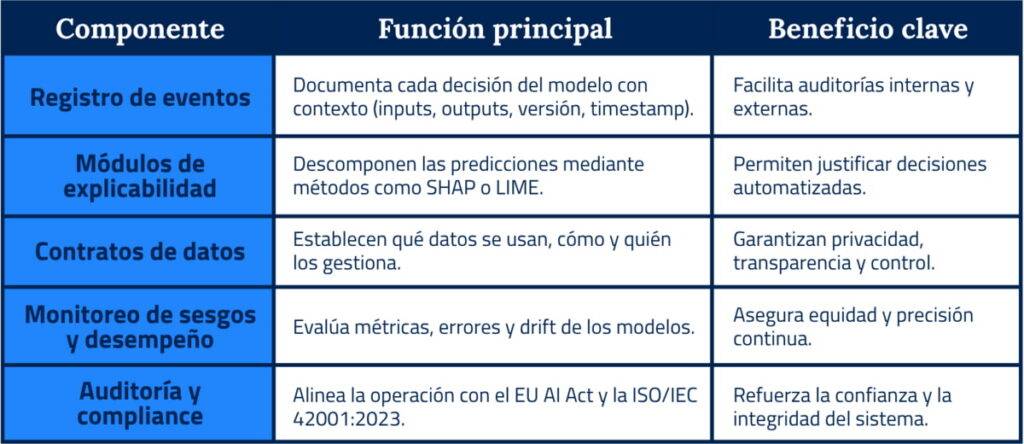

Los componentes fundamentales del middleware de gobernanza pueden resumirse así:

Middleware: la capa donde se decide con reglas claras

En un ecosistema de aprendizaje moderno, el middleware es la capa que transforma la inteligencia artificial en decisiones gobernadas. No reemplaza al LMS, sino que actúa como un orquestador inteligente capaz de ejecutar modelos bajo reglas claras, políticas verificables y trazabilidad completa.

Su función es convertir las políticas institucionales en decisiones técnicas coherentes: qué modelos se activan, con qué datos, bajo qué condiciones y dentro de qué umbrales de confianza. Esta lógica de control convierte la IA en una herramienta auditable, no en una caja negra.

Orquestación contextual de modelos de IA

El middleware interpreta las reglas de negocio y selecciona dinámicamente el modelo adecuado según el contexto: evaluación, recomendación, detección temprana o gestión operativa.

Cada modelo actúa dentro de un marco definido, lo que permite automatizar sin perder control.

Ejemplos típicos:

- Evaluación automática: activar un modelo de clasificación sólo si la precisión histórica supera un umbral predefinido.

- Recomendación personalizada: ejecutar un sistema híbrido de aprendizaje adaptativo únicamente cuando la confianza de predicción excede el 0,85.

- Alertas predictivas: detectar riesgo de abandono con modelos de series temporales y generar intervenciones preventivas bajo criterios validados.

Esta arquitectura basada en políticas (policy-based orchestration) garantiza que la IA trabaje bajo principios de transparencia y responsabilidad, en línea con las recomendaciones de la Unión Europea.

Contratos de datos y políticas de uso de modelos

Cada modelo dentro del ecosistema opera bajo un contrato de datos, un documento técnico que define las condiciones de uso y acceso a la información.

Sus componentes esenciales incluyen:

- Origen y validación de datos: especifica las fuentes y sus controles de calidad.

- Umbrales de confianza: fija el nivel mínimo de fiabilidad para ejecutar una decisión automatizada.

- Retención y privacidad: determina cuánto tiempo pueden mantenerse los datos en el entorno de inferencia, conforme al GDPR.

- Auditoría de acceso: registra quién, cuándo y con qué propósito accedió a los datos, siguiendo estándares como ISO/IEC 27001.

Estos contratos convierten la gobernanza en una práctica operativa: la IA no solo ejecuta, sino que justifica cada paso con evidencias trazables.

Trazabilidad reproducible de cada decisión

Toda inferencia ejecutada por la IA se registra de forma estructurada, con metadatos sobre contexto, versión del modelo, criterios de selección y resultados.

Este registro permite tres capacidades críticas:

- Reproducibilidad: permite reconstruir decisiones para auditorías internas o regulatorias.

- Detección de sesgos: posibilita análisis longitudinales de patrones de decisión, ayudando a identificar desviaciones sistemáticas.

- Rollback técnico: ofrece capacidad de revertir versiones de modelos en caso de comportamiento anómalo o degradación del rendimiento.

Al implementar estos mecanismos, el middleware se convierte en la capa donde se combinan control, rendimiento y confianza. El resultado es un LMS que mantiene su estructura de gestión, pero ahora decide con evidencia, explica con transparencia y escala sin riesgo.

Escalabilidad sin romper lo que ya funciona

En entornos de aprendizaje consolidados, cualquier cambio que afecte al núcleo del LMS implica riesgos operacionales y costes de mantenimiento. Un middleware de IA bien diseñado permite añadir capacidades avanzadas sin tocar el código base del LMS, garantizando que la expansión sea segura, predecible y alineada con los principios de gobernanza ya descritos.

Extensión modular: más IA, mismo LMS

El middleware actúa como un plug-in inteligente que habilita nuevas funciones (evaluaciones automáticas, recomendaciones adaptativas, analítica predictiva) sin modificar el código fuente del LMS.

Mediante APIs y eventos, las nuevas funcionalidades se activan de forma controlada y segmentada (por ejemplo, para un grupo de usuarios o un curso piloto), manteniendo la operatividad del entorno existente.

Este modelo reduce el riesgo de interrupciones, facilita la validación progresiva de modelos y asegura que cada ampliación esté gobernada por reglas claras.

Integraciones estandarizadas para reducir deuda técnica

Cada integración ad-hoc genera dependencia y costes de mantenimiento. Un middleware bien diseñado introduce contratos de API y eventos unificados, donde todos los servicios hablan el mismo lenguaje técnico y semántico.

- API unificada: normaliza cómo el LMS envía y recibe datos (progreso, resultados, confianza del modelo), simplificando la comunicación entre módulos.

- Bus de eventos: pública acciones clave como inscripciones o finalización de cursos, para que los servicios de IA se conecten sin alterar la lógica interna.

Neutralidad tecnológica: independencia para decidir

La verdadera escalabilidad no solo depende de crecer, sino de mantener independencia frente a un único proveedor de IA.

- El middleware adopta un enfoque de adaptadores (adapter pattern) que encapsula las conexiones con distintos servicios OpenAI, Vertex AI, Azure Cognitive Services o modelos on-premise bajo un contrato común.

- Si una organización decide cambiar de proveedor por costes, rendimiento o políticas de cumplimiento, basta con sustituir el adaptador; el LMS permanece intacto.

- Esta portabilidad otorga neutralidad tecnológica, flexibilidad de evolución y garantía de continuidad operativa.

Escalabilidad autónoma y resiliencia continua

El middleware gestiona su propia capacidad de cómputo, sin sobrecargar el LMS.

Desplegado en arquitecturas de microservicios y contenedores (Docker/Kubernetes), puede escalar horizontalmente según la demanda.

Si un modelo presenta fallos o latencias, los mecanismos de resiliencia circuit breakers, reintentos o fallbacks controlados aseguran que la experiencia del usuario se mantenga estable.En otras palabras: el LMS sigue funcionando aunque la IA tenga un mal día.

Métricas y control: cuándo un sistema es gobernable de verdad

En un ecosistema de aprendizaje impulsado por inteligencia artificial, la gobernanza no se demuestra con gráficos vistosos ni dashboards de marketing, sino con indicadores cuantificables que puedan medirse, auditarse y accionarse de forma automática. Solo cuando el LMS + middleware permite observar de forma confiable el desempeño, la trazabilidad y el coste de cada decisión, se puede afirmar que ese entorno es verdaderamente gobernable.

Service Level Objectives (SLO) técnicos para la capa de IA

Los SLO son compromisos cuantitativos que definen los niveles de servicio esperados para los componentes críticos del middleware. Su propósito es anticipar degradaciones antes de que afecten la experiencia del usuario o la integridad del sistema. Algunos SLO recomendados:

- Latencia de recomendaciones – Tiempo máximo tolerable entre la solicitud del usuario y la entrega de la respuesta personalizada. Por ejemplo: el 95 % de las recomendaciones deben llegar en ≤ 400 ms.

- Porcentaje de decisiones explicables – Proporción de inferencias que incluyen una justificación legible y audit-able. Por ejemplo: el 100 % de las decisiones que modifiquen la ruta del usuario deben estar respaldadas con explicaciones técnicas.

- Entrega de eventos sin pérdida – Garantía de que todos los eventos críticos (inscripción, finalización de módulo, calificación) sean procesados por el middleware sin omisiones ni duplicados. Por ejemplo: 0 % de eventos perdidos en el bus de mensajería.

Estos indicadores no se observan, se accionan: las alertas se activan automáticamente ante desviaciones y ejecutan protocolos de corrección, escalado o degradación controlada.

FinOps aplicado a la IA: gobernanza también es eficiencia

La gobernanza también implica medir y controlar el gasto asociado a la IA. Un enfoque FinOps permite valorar el coste unitario de cada inferencia y definir límites presupuestarios en coherencia con los objetivos académicos y organizativos.

- Coste por decisión efectiva: relación entre el gasto en infraestructura o licencias y el número de inferencias que generan mejoras medibles (retención, progreso, desempeño).

- Presupuestos por área académica: límites definidos por facultad o programa, con control automático del consumo.

- Transparencia del gasto: reportes periódicos que muestran coste por modelo, tipo de decisión y unidad organizativa.

De esta forma, la IA deja de ser una inversión abierta y se convierte en una herramienta sostenible, alineada con la estrategia académica y los objetivos financieros.

Tres métricas que definen la gobernabilidad real

Más allá de los SLO y del enfoque FinOps, la gobernabilidad se valida mediante tres pilares medibles que deben estar presentes en cualquier auditoría técnica:

- Tiempo de respuesta end-to-end: el sistema mantiene la latencia estable en todo el ciclo, desde la petición hasta la acción final en el LMS, garantizando experiencia fluida y consistente.

- Evidencia totalmente trazable: cada inferencia se registra con su contexto, modelo, versión, salida y nivel de confianza. Esta trazabilidad permite reproducir decisiones, auditar modelos y cumplir con normativas como el AI Act o las directrices de la AESIA.

- Coste unitario por decisión: cada inferencia tiene un valor económico y educativo medible. Saber cuánto cuesta una mejora en retención o un punto en calificación es lo que transforma la IA en una inversión estratégica, no solo tecnológica.

Cuando estas tres métricas están implementadas de modo automático y son auditablemente confiables, ya no hablamos de un LMS con “inteligencia añadida”, sino de un sistema con gobernabilidad real, sostenible y alineado con los estándares de transparencia esperados en entornos con IA regulada.

Reflexión final

Cada organización educativa llega a un punto donde mantener el control importa más que incorporar la última tecnología. No se trata de añadir más capas de IA, sino de garantizar que cada una actúe bajo reglas claras, con evidencia y propósito. En ese punto, la diferencia entre un sistema que escala y uno que se desborda está en su capacidad de gobernarse a sí mismo.

El middleware de IA no es una mejora técnica: es la arquitectura que define cómo una institución aprende de su propia inteligencia. Permite que la automatización sea confiable, que las decisiones sean rastreables y que los equipos directivos tomen decisiones sobre datos verificables, no sobre supuestos. Es el puente entre la innovación y la responsabilidad.

Si vuestra organización está explorando cómo implementar IA en su LMS para ofrecer rutas de aprendizaje personalizadas, anticipar necesidades de los estudiantes y optimizar la toma de decisiones educativas, transformando la plataforma en una herramienta proactiva y estratégica para la institución, sin perder control ni trazabilidad, hablemos.

Somos una compañía con un amplio recorrido en el sector educación, y llevamos años trabajando con clientes nacionales e internacionales en este área, ofreciendo diferentes soluciones. Somos proveedores de tecnología tanto de universidades públicas, por ejemplo, UAM, UPM o UNED, y privadas como el caso IEU, UNIR, o Hespérides, entre otros. También hemos trabajado con otro tipo de instituciones educativas y con clientes de otros sectores (Banca, Media, Telco, etc), desarrollando distintas soluciones técnicas para los proyectos internos de formación de sus trabajadores y usuarios.

Participamos con ellos tanto en proyectos de implantación y soporte de tecnologías educativas y sistemas de gestión académica, como en procesos de optimización, automatización y aplicación de IA en entornos educativos.

Podemos ayudaros a diseñar una arquitectura que no sólo funcione, sino que dé confianza a quienes la lideran, y transparencia a quienes aprenden con ella.