La arquitectura de data lake es una tecnología utilizada por grandes y pequeñas industrias que desean aprovechar al máximo su información. Entender las lecciones de la arquitectura data lake es fundamental para construir un sistema de datos robusto y efectivo que permita almacenar, procesar y analizar grandes volúmenes de información de manera eficiente.

Imagina un lago enorme donde fluyen todo tipo de datos: desde datos estructurados como ventas y transacciones, hasta datos no estructurados como correos electrónicos y tweets. La arquitectura data lake actúa como este lago, proporcionando un espacio centralizado y flexible donde almacenar todos estos datos. Sin embargo, comprender cómo diseñar y gestionar este «lago de datos» de manera efectiva es crucial para sacarle el máximo provecho.

Lo usual en un proyecto es que todo inicia con un desafío, pero en el caso de proyectos de Data hay un dolor que suele pesar más: El no estar obteniendo en un corto periodo de tiempo conocimiento de los datos lo que hace que se pierdan oportunidades importantes, tanto de los datos mismos como de las opciones tecnológicas posibles de usar.

Construyendo la cultura de datos

Desde el punto de vista de la ciencia de datos, el conocimiento se obtiene aplicando técnicas algorítmicas sobre un dataset y luego mostrando los resultados obtenidos en forma de artículo, pero la vida de un dataset es un proceso complejo; especialmente si hablamos de la arquitectura de data lake. La vida de una dataset incluye implementar desde la ingestión de los datos, la validación, eliminación de duplicados, anonimización o aplicación de secretos estadísticos, pasando por la formación de zonas de más confianza para finalmente “curar” un dataset que esté en las mejores condiciones posibles.

La evidencia muestra que entre el 70% y 90% del tiempo de los trabajos en Datos se pasan el tiempo en tareas de curación de datos (Si te pasas el día, mayoritariamente entre pandas, Drill o Spark shell ya sabes a lo que me refiero).

Un día en la vida de un dataset

¿De dónde obtenemos nuestros dataset curados? ¿Vamos a guardar información y luego ver hacemos con ella? o ¿Vamos a guardar datos con los que ya sabemos qué hacer con ellos? Quienes se recuerden de Ingeniería de Software – por supuesto entenderán que – el Caso de Uso aquí es difuso, no se si es exigible a un cliente tener un caso de uso acerca de un activo de data que puede producir resultados desconocidos, muchas veces las organizaciones hacen proyectos de data (y es entendible) no solo para extraer información de los datos, sino para hacer inventario de que datos capturar o tienen.

Lecciones aprendidas desde la arquitectura Data Lake

Supongamos que obtendremos nuestros datos de un DataLake, esto implica que un día en la vida de un dataset es lo siguiente: Se captura toda la data que pueda de los activos digitales bajo mi control y luego cada día (u hora o semana, depende) trataré los datos aumentando los niveles de confianza de la misma (Ejemplo clásico: Eliminar duplicados, eliminar datos corruptos), haciéndoles transitar por zonas (bronze, silver, gold) y una vez que tenga los datos sobre la zona de más alta confianza generar los dataset que serán entrada para los modelos de regresiones, clasificación, etc.

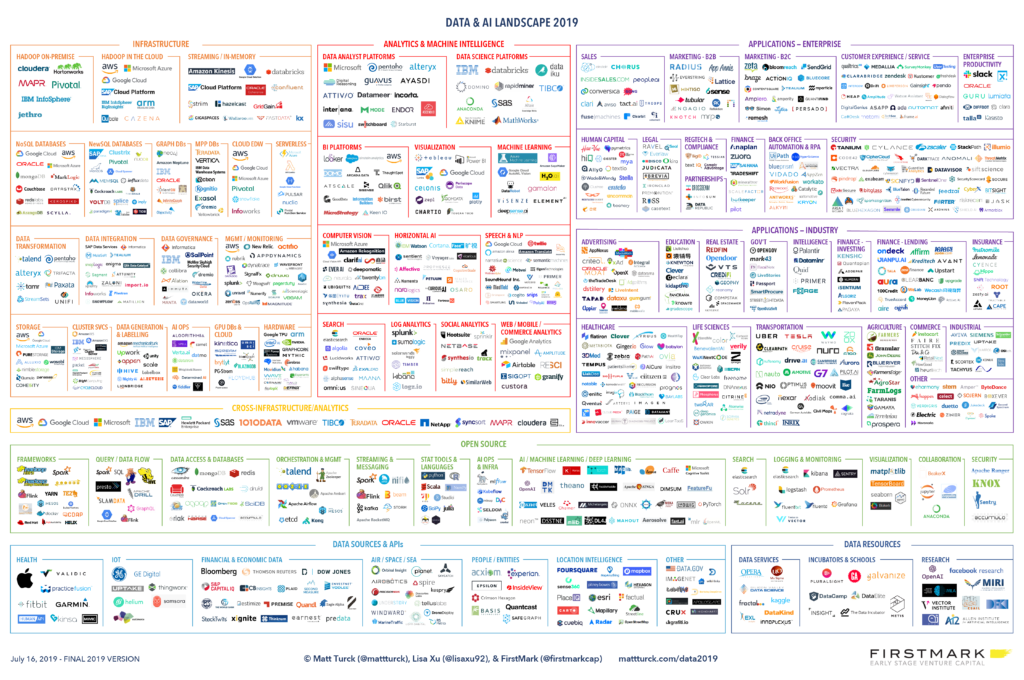

Lección aprendida 1: “El ecosistema data & analytics no es integrado”

Dato curioso: Existe un juego online llamado “Pokemon o big data”, donde a partir del nombre de un supuesto producto Big Data se debe adivinar cuál es de cada “Universo”.

Hay cientos, si no miles de productos de big data y a pesar de que hay cierta tendencia, lo que podemos estar medianamente seguros es que hay algunos productos que funcionarán bien y otros peor, que hay que estudiar los productos a fondo y contar con apoyo ejecutivo cuando se trate de impulsar la implementación de algún producto de arquitectura de data lake.

No hay a la vista una gran plataforma de Data & Analytics (+ AI), no estoy seguro suceda, de la misma forma que no sucedió con el proceso de desarrollo de software, en cuyo caso vemos hoy que cada “stack” se compone de varios productos con algunos productos coincidentes.

Aquí mis productos favoritos de Data & Analytics a Junio 2020, los que nunca me han fallado y que casi obligatoriamente pongo en las arquitecturas:

- Kafka (Confluent Platform)

- Spark

- Airflow

- Flink

- Apache Drill (Un gran descubrimiento)

- Jupyter

- PostgreSQL (Por supuesto)

- Druid

- Dremio

- PowerBI

- ML Flow

- Delta.io o Apache Iceberg.

Lección aprendida 2: “Calidad es la calidad de las preguntas”

Involucra al equipo del producto no sólo en aportar datos, sino en ser conscientes de las preguntas que los ejecutivos tienen por sobre el conocimiento generado: Técnica del sandwich, por un lado el equipo con preguntas de casuísticas concretas y por otro los ejecutivos con preguntas más estratégicas. Este enfoque te va a sugerir una priorización mejorada en los planes o te invita a mejorar la arquitectura de data lake para responder a las preguntas.

Realiza eventos o presentaciones como “Data show”, donde se analizan datos (o resultados generados por los modelos) en vivo en sesiones interactivas o a partir de un panel de visualización para que se pueden ver tendencias.

Esta lección la aprendí luego de leer el maravilloso “Factfulness” de Hans Rosling

Lección aprendida 3: “Un proyecto debe estar preparado para su BAU”

Los proyectos se van terminando y los artefactos generados quedan implementados bajo operación de otras personas (Operativizar, podría ser un palabro adecuado aquí), genera un manual de operaciones de todo lo que estás construyendo porque ten claro que no serás tú o tu equipo quien opere a mediano/largo plazo los artefactos que dejaste implementados en tal o cual proyecto de arquitectura de data lake.

Fuentes:

- https://es.wikipedia.org/wiki/Conjunto_de_datos

- Ej.: https://www.linkedin.com/pulse/madrid-best-neighbourhoods-raise-family-leonardo-barrientos-c

- https://pixelastic.github.io/pokemonorbigdata/

- A Turbulent Year: The 2019 Data & AI Landscape

- https://www.amazon.es/Factfulness-Reasons-World-Things-International/dp/1250107814

Reflexión

Te animo a aplicar estas lecciones en la implementación y gestión de arquitecturas data lake. Entender cómo funciona un data lake y cómo podemos aprovecharlo al máximo nos ayuda a construir sistemas más eficientes y escalables. No tengas miedo de experimentar y adaptar estas lecciones a las necesidades específicas de tu empresa.

Recuerda que el éxito en la implementación de una arquitectura data lake requiere de un enfoque estratégico y flexible. Es importante involucrar a todos los equipos relevantes y asegurarse de que comprendan el propósito y los beneficios del data lake. Además, mantén un monitoreo constante de su funcionamiento y realiza ajustes según sea necesario. Con el tiempo y la práctica, estarás mejorando continuamente tu capacidad para gestionar y optimizar tu arquitectura data lake, lo que te permitirá tomar decisiones más informadas y avanzar en tus objetivos comerciales.