Cada día interactuamos con tecnologías que parecen anticipar nuestras necesidades: desde recomendaciones precisas en nuestras plataformas favoritas de streaming hasta asistentes virtuales que entienden nuestro lenguaje natural. Todo es posible gracias al aprendizaje supervisado una tecnología que, en silencio, está detrás de muchas de las experiencias que consideramos normales.

El aprendizaje supervisado es la columna vertebral de la IA moderna. Esta técnica permite que las máquinas aprendan de datos etiquetados, afinando sus predicciones y decisiones de manera que impactan de forma tangible en industrias tan diversas como la salud y las finanzas.

Para las empresas que quieren estar por encima de la innovación, el aprendizaje supervisado es un recurso esencial. No solo optimiza procesos y mejora la toma de decisiones, sino que también impulsa el desarrollo de nuevas tecnologías. En un mundo competitivo, dominar el aprendizaje supervisado no solo te mantiene relevante. Sino que te coloca en el camino correcto hacia el futuro de la tecnología.

Qué es el aprendizaje supervisado y por qué es clave para la IA empresarial

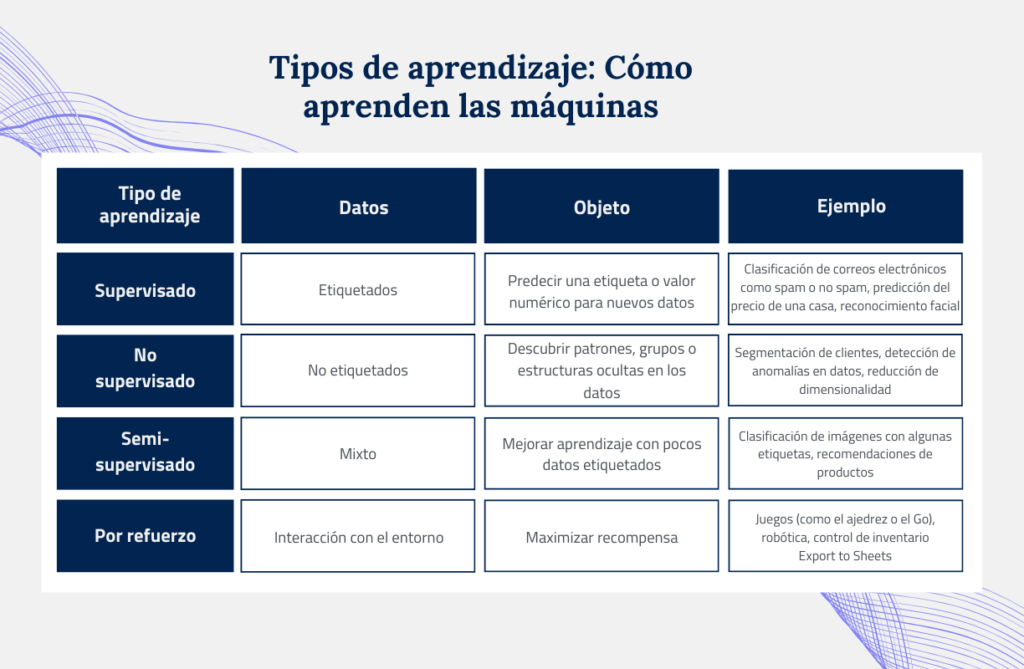

El aprendizaje supervisado es un enfoque en el cual los algoritmos de machine learning son entrenados utilizando un conjunto de datos etiquetados,donde cada entrada viene acompañada de la salida esperada. Este proceso permite que el modelo aprenda a mapear entradas y salidas basándose en ejemplos previos. En otras palabras, el modelo se “supervisa” durante el entrenamiento para que pueda hacer predicciones precisas cuando se le presentan nuevos datos.

En el aprendizaje no supervisado, los datos que se utilizan no están etiquetados, lo que significa que el modelo debe encontrar patrones y estructuras por sí solo. Este tipo de aprendizaje es ideal cuando no se tiene un conjunto de datos previamente clasificado, y su objetivo principal es descubrir agrupaciones o relaciones ocultas entre los datos. Un ejemplo común es el clustering, que agrupa datos con características similares, o la reducción de dimensionalidad, que simplifica los datos manteniendo la mayor cantidad de información posible.

Por otro lado, el aprendizaje semi-supervisado combina lo mejor de ambos mundos: una pequeña parte de los datos está etiquetada, mientras que la mayor parte no lo está. Esto permite al modelo aprovechar la información etiquetada para hacer predicciones más precisas sobre los datos no etiquetados. Un ejemplo típico de este enfoque es la clasificación de imágenes, donde solo algunas imágenes están etiquetadas, pero el modelo puede aprender a clasificar correctamente un gran número de imágenes sin etiquetas.

Finalmente, en el aprendizaje por refuerzo, el modelo (o agente) aprende interactuando con un entorno y recibiendo recompensas o penalizaciones en función de sus acciones. El objetivo es aprender una estrategia que maximice la recompensa a largo plazo. Esta técnica es ampliamente utilizada en áreas como los juegos, la robótica, y los sistemas de recomendación, donde el agente mejora continuamente con la experiencia adquirida a través de sus interacciones.

Cuándo utilizar cada tipo

- Supervisado: Cuando tienes una gran cantidad de datos etiquetados y quieres hacer predicciones precisas.

- No supervisado: Cuando no tienes etiquetas y quieres descubrir patrones ocultos en los datos.

- Semi-supervisado: Cuando tienes una pequeña cantidad de datos etiquetados y una gran cantidad de datos no etiquetados.

- Por refuerzo: Cuando quieres que un agente aprenda a tomar decisiones en un entorno dinámico.

De principio a fin: proyecto de aprendizaje supervisado

El ciclo de vida de un proyecto de aprendizaje supervisado se puede dividir en varias fases clave que aseguran que el modelo no solo funcione bien en datos de entrenamiento, sino que también generalice bien a datos nuevos. Vamos a desglosar cada fase con un enfoque detallado pero accesible.

Preprocesamiento de Datos

Limpieza de datos: Antes de comenzar a construir un modelo, es crucial asegurarse de que los datos estén limpios. Esto significa manejar valores faltantes, eliminar duplicados y corregir errores. Por ejemplo, si tienes una base de datos de clientes, podrías encontrar campos vacíos o datos erróneos que necesitan ser corregidos para evitar que el modelo aprenda patrones incorrectos.

Transformación de datos: Una vez limpios los datos a menudo necesitan ser transformados para ser útiles. Esto puede incluir la normalización ajustar los valores de las variables para que estén en un rango común), la codificación de variables categóricas (convertir texto en números) y la creación de nuevas características. Por ejemplo, convertir una fecha de nacimiento en una edad puede ser más útil para el modelo.

Selección de Características: A veces, no todas las características (variables) en el conjunto de datos son útiles. La selección de características implica elegir las variables que realmente aportan valor al modelo y eliminar las que no. Esto puede mejorar el rendimiento del modelo y reducir el tiempo de entrenamiento. Por ejemplo, si estás prediciendo el precio de una casa, características como el número de habitaciones y la ubicación serán más relevantes que el color de las paredes.

Elegir el modelo y ajustar los parámetros

Una vez que los datos estén listos, es crucial entender a fondo el problema que queremos resolver. Primero, debemos definir claramente el objetivo: ¿qué estamos tratando de predecir o clasificar, y cuál es la variable que queremos influir? Luego, pongamos en perspectiva el contexto: ¿dónde y cómo se usará el modelo, y qué impacto tendrán los posibles errores? Finalmente, consideremos las restricciones: ¿tenemos limitaciones de tiempo, recursos computacionales o regulaciones que debamos tener en cuenta? Con esta visión clara, nuestro modelo estará en camino de ser realmente efectivo.

Clasificación para todos los problemas

Problemas binarios

Regresión logística: Ideal para decidir entre dos posibilidades, como saber si un correo es spam o no. Funciona muy bien cuando la relación entre los datos es clara y directa.

SVM (Máquinas de Soporte Vectorial): Perfectas para datos con muchas dimensiones y patrones complicados. Estas herramientas encuentran la mejor «línea divisoria» entre las clases, ayudando tanto en problemas con dos categorías como con varias.

Árboles de decisión: Crean un “árbol” de decisiones para clasificar datos de forma clara y visual. Son muy útiles y pueden manejar datos de diferentes tipos, tanto numéricos como categóricos.

Problemas multiclase

Árboles de decisión: También son geniales para clasificar datos en múltiples categorías. Expanden la idea del árbol para que puedas gestionar muchas clases diferentes fácilmente.

Bosques aleatorios: Usan una combinación de varios árboles de decisión para hacer el modelo más preciso y menos propenso a errores. Son muy versátiles y se adaptan a muchos tipos de problemas.

Redes neuronales: Perfectas para problemas complejos con grandes cantidades de datos. Estas redes pueden aprender patrones muy detallados y son ideales para situaciones con múltiples categorías.

Técnicas de regresión para predecir valores

Regresión lineal: Imagina una línea recta que trata de capturar la relación entre una variable dependiente y una o más variables independientes. Es ideal cuando ves que los datos siguen una tendencia lineal clara.

Regresión polinomial: Cuando los datos no siguen una línea recta, esta técnica entra en acción. Utiliza una curva polinómica para modelar relaciones más complejas y no lineales entre las variables.

Árboles de decisión de regresión: Piensa en un árbol que divide los datos en ramas para predecir valores numéricos. Son fáciles de entender y funcionan bien con datos que tienen diferentes tipos de variables.

Bosques aleatorios: Imagínate un grupo de árboles de decisión de regresión trabajando juntos. Combinan sus predicciones para hacer que los resultados sean más precisos y reducir los errores.

Redes neuronales: Estas redes son como cerebros artificiales que pueden captar relaciones muy complejas y no lineales en los datos. Son perfectas para modelar patrones detallados y complejos.

Clustering

El objetivo del clustering es organizar datos en grupos en los que los elementos dentro de cada grupo sean más similares entre sí que con los elementos de otros grupos. Es como clasificar elementos en cajas según sus propiedades comunes, lo que ayuda a descubrir patrones, estructuras y relaciones ocultas en los datos.

K-means: Imagina que quieres dividir tus datos en grupos específicos, y tú decides cuántos grupos (k) necesitas. K-means hace exactamente eso, separando tus datos en k grupos distintos. Es uno de los métodos más populares y fáciles de usar.

Clustering jerárquico: Piensa en un árbol genealógico, pero para tus datos. Este método crea una estructura de clusters que se dividen en subclusters, ayudándote a descubrir cómo se agrupan los datos en diferentes niveles.

DBSCAN: Este algoritmo es como un experto en encontrar agrupaciones en formas y tamaños variados. Identifica clusters incluso cuando los datos tienen ruido o formas irregulares, ¡ideal para datos que no se ajustan a moldes simples!

Evaluación del desempeño: ¿cómo saber si nuestro modelo está haciendo un buen trabajo?

Para saber si nuestros modelos están funcionando bien, usamos varias formas de medir su desempeño. En clasificación, comprobamos cosas como la precisión (cuán a menudo el modelo acierta), el recall (cuántos casos positivos detecta correctamente), el F1-score (un equilibrio entre precisión y recall) y la matriz de confusión (que muestra los aciertos y errores en una tabla).

También usamos la curva ROC para ver qué tan bien nuestro modelo distingue entre diferentes categorías. En regresión, medimos el error cuadrático medio (MSE) y la raíz del error cuadrático medio (RMSE) para ver cuánto se desvían nuestras predicciones de los valores reales, y el R-cuadrado para saber qué tan bien el modelo se ajusta a los datos. Además, la validación cruzada nos ayuda a asegurarnos de que el modelo no esté sobreajustado a los datos y ofrece una evaluación más precisa.

Luego pasamos a la fase de ajuste y mejora. Esto incluye selección de características, donde identificamos cuáles son las más importantes para el modelo, y ajuste de hiperparámetros, donde optimizamos ciertos ajustes del modelo para mejorar su rendimiento.

Cómo el aprendizaje supervisado potencia herramientas modernas

En esta sección, vamos a descubrir cómo el aprendizaje supervisado impulsa herramientas avanzadas como SofIA, ChatGPT Enterprise y otras, haciendo que cada interacción sea más inteligente y eficiente.

SofIA: Cómo el aprendizaje supervisado potencia esta herramienta avanzada

SofIA es una asistente inteligente, que hace tu vida más fácil y tu trabajo más eficiente. Su misión es ofrecer información precisa y útil para automatizar tareas y ayudar a tomar decisiones de confianza. Esta herramienta te ayuda a que tanto tú como tu empresa sean más ágiles, innovadores y competitivos.

El aprendizaje supervisado es clave para SofIA, ya que puede ofrecer funcionalidades más precisas y adaptadas a tus necesidades. Gracias a está técnica, puede realizar tareas complejas con exactitud, cómo clasificación de textos, reconocimiento de imágenes y detección de fraudes, mientras se ajusta continuamente las respuestas para reducir errores. Está capacidad de aprendizaje permite ofrecer predicciones cada vez más fiables y precisas, ayudándote a tomar decisiones más informadas en diversas áreas.

Esto garantiza que sus predicciones y recomendaciones sean precisas y relevantes. Además, optimiza procesos y automatiza tareas repetitivas, liberando tiempo para que los usuarios se concentren en actividades más estratégicas, mientras ofrece una experiencia personalizada que se adapta a sus necesidades.

SofIA: plataforma corporativa de IA

ChatGPT Enterprise: elevando la conversación inteligente

ChatGPT Enterprise, desarrollado por OpenAI, es un claro ejemplo de cómo el aprendizaje supervisado impulsa interacciones más inteligentes con la inteligencia artificial. Este modelo se entrena con grandes cantidades de texto, donde se le enseñan ejemplos de diálogos efectivos. A través de este proceso, aprende a generar respuestas coherentes y relevantes en diversos contextos. El aprendizaje supervisado permite a ChatGPT Enterprise mejorar continuamente sus respuestas y adaptarse a una amplia variedad de temas, haciendo que las interacciones sean más fluidas y valiosas.

Otras herramientas de IA influenciadas por el aprendizaje supervisado

La calidad y cantidad de los datos de entrenamiento impactan directamente en la calidad de las respuestas y la capacidad de generalización de los modelos, mientras que el aprendizaje supervisado permite afinar estos modelos para tareas específicas, mejorando su precisión y relevancia. Además, la interpretabilidad es crucial, y el aprendizaje supervisado contribuye a desarrollar modelos más transparentes.

Herramientas y frameworks populares en aprendizaje supervisado

El aprendizaje supervisado se ha beneficiado enormemente del desarrollo de una amplia gama de herramientas y frameworks que simplifican la creación, entrenamiento y evaluación de modelos. A continuación, explicaremos algunas de las más populares y sus características clave:

TensorFlow: Es perfecto para proyectos grandes de aprendizaje profundo, como trabajar con imágenes o lenguaje natural. ¿Por qué usarlo? Porque es flexible, escalable, y tiene una comunidad amplia que lo respalda. Además, puedes desarrollar modelos directamente en el navegador con TensorFlow.js.

scikit-learn: Ideal si estás empezando en el aprendizaje automático y quieres trabajar con regresiones, clasificaciones o clustering. Es fácil de usar, tiene una gran variedad de algoritmos, y viene con herramientas para procesar datos y evaluar modelos.

PyTorch: Si te interesa la investigación y necesitas algo intuitivo y flexible para crear prototipos rápidamente, PyTorch es tu aliado. Es similar a TensorFlow pero con una interfaz que muchos encuentran más sencilla, y además cuenta con una fuerte comunidad.

Jupyter Notebooks: Este entorno interactivo es perfecto para experimentar, visualizar resultados, y crear prototipos rápido. Todo en un solo documento que combina código, texto y gráficos.

Google Colab: Si necesitas poder de cómputo sin pagar, Google Colab te permite ejecutar tus códigos en la nube, con acceso gratuito a GPUs, ideal para proyectos que requieren mucha potencia.

¿Cuál herramienta o framework elegir?

Tu elección dependerá de factores como la complejidad del problema, el tamaño del dataset y tu nivel de experiencia. Para problemas simples y datasets pequeños, scikit-learn es una opción amigable. Si el proyecto es más complejo o el dataset grande, TensorFlow o PyTorch pueden ofrecer más eficiencia y flexibilidad.

Reflexión

El futuro del aprendizaje supervisado está lleno de posibilidades. A medida que esta tecnología continúa avanzando, veremos una integración más profunda con el aprendizaje profundo, lo que permitirá crear modelos aún más poderosos y autónomos. Estas innovaciones no solo mejorarán la precisión de las predicciones, sino que también abrirán nuevas puertas para aplicaciones más avanzadas y complejas, que podrán adaptarse mejor a las necesidades específicas de cada industria y usuario.

Al analizar grandes volúmenes de información, estas herramientas ayudan a identificar patrones y prever tendencias con mayor exactitud. Esto no solo mejora la eficiencia operativa, sino que también impulsa la personalización del servicio al cliente, al adaptar las ofertas y recomendaciones de manera más efectiva. En última instancia, el aprendizaje supervisado facilita una toma de decisiones más informada y ágil, lo que puede traducirse en una ventaja competitiva significativa en el mercado.

Si quieres conocer más sobre cómo puedes aprovechar el aprendizaje supervisado y otros tipos de aprendizaje, habla con nuestro equipo y transforma tu empresa con tecnologías de machine learning.