Existe una suposición común en muchos proyectos de IA: que siempre hay una variable objetivo clara que guiará el modelo.

El aprendizaje no supervisado no busca predecir, sino descubrir estructura en los datos cuando no existe una variable objetivo definida. Esto lo hace especialmente útil en contextos empresariales donde no hay una “respuesta conocida”, pero sí patrones latentes: segmentación de clientes, agrupación de incidencias, categorización de productos o identificación de comportamientos emergentes.

Hoy, su aplicación va mucho más allá del análisis exploratorio. Modelos generativos como LLMs y VLMs permiten ejecutar tareas típicas del aprendizaje no supervisado con menor esfuerzo técnico, ampliando su alcance y facilitando su adopción incluso en organizaciones sin un equipo de data science especializado. Estos modelos no sustituyen a los enfoques clásicos, pero sí los complementan y simplifican.

La clave está en cómo se integran. Middleware como SofIA permite orquestar ambos enfoques (no supervisado y generativo) en una arquitectura común, conectando modelos con flujos de negocio, asegurando trazabilidad, y habilitando un uso controlado y escalable. Este enfoque híbrido permite aplicar inteligencia real donde antes sólo había datos desconectados.

Qué es el aprendizaje no supervisado y cómo se diferencia del supervisado

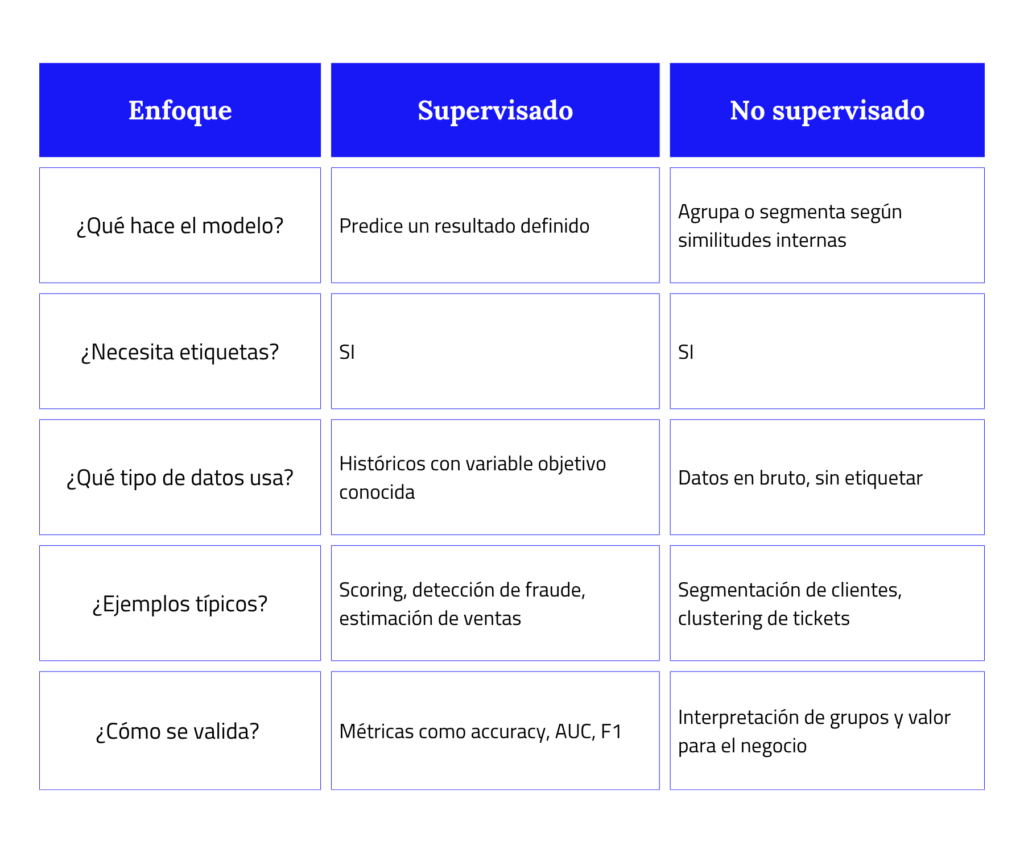

Cuando una empresa decide aplicar machine learning, la primera pregunta que deberíamos hacernos no es “¿qué modelo usamos?”, sino “¿qué tipo de problema tenemos entre manos?”. Porque aquí hay una diferencia fundamental que cambia todo: ¿estamos tratando de predecir algo concreto o de entender cómo se agrupan las cosas sin saber exactamente qué buscamos?

Dos caminos distintos, dos formas de extraer valor

En el aprendizaje supervisado, partimos con ventaja: tenemos una variable clara que queremos predecir. Es como entrenar al modelo para que diga si un cliente se dará de baja, si una imagen muestra una anomalía o cuántas unidades se venderán la próxima semana. Los datos vienen con etiquetas, y el objetivo es claro: predecir.

En cambio, en el aprendizaje no supervisado no hay etiquetas, ni una “respuesta correcta” predefinida. Aquí lo que buscamos es descubrir patrones que ya existen en los datos, aunque no los hayamos formulado antes. Es una herramienta más exploratoria, pero también muy potente cuando el negocio necesita entender segmentos, similitudes o tipos de comportamiento que no están explícitos.

¿Cómo se traduce esto en la práctica?

La clave está en las variables

Aquí es donde muchos proyectos de aprendizaje no supervisado se complican: todo depende de las variables que uses para agrupar. Si eliges mal, los grupos que te devuelva el modelo pueden no tener sentido. Y eso no es culpa del algoritmo, sino de cómo has definido el espacio de análisis.

Por eso, antes de pensar en el modelo, hay que trabajar bien los datos: qué dimensiones tienen, cómo se relacionan entre sí, cuál es su granularidad real. Lejos de ser un enfoque desestructurado, el aprendizaje no supervisado demanda una selección rigurosa de variables y un marco analítico claro.

Aprendizaje supervisado y no supervisado no compiten, se complementan. Cada uno resuelve un tipo de problema distinto, y su valor real surge cuando se integran dentro de una arquitectura analítica coherente.

En entornos con grandes volúmenes de datos no etiquetados, el aprendizaje no supervisado permite estructurar y entender la información sin depender de una variable objetivo, lo que lo convierte en una herramienta eficiente para explorar, segmentar y reducir complejidad.

Limitaciones clásicas del aprendizaje no supervisado: lo que hay que saber

Aunque el aprendizaje no supervisado es una herramienta útil para estructurar datos no etiquetados, su aplicabilidad está condicionada por una serie de factores técnicos y de contexto que no deben subestimarse. Entender sus limitaciones no implica descartarlo, sino saber cuándo usarlo, cómo prepararlo y qué esperar de sus resultados.

Alta sensibilidad a la selección de variables

Los modelos de aprendizaje no supervisado funcionan en base a la similitud matemática entre observaciones, por lo que los resultados dependen completamente de las variables que se utilicen para agruparlas.

- Variables irrelevantes, redundantes o mal escaladas distorsionan los clústeres.

- La dimensionalidad puede ocultar o exagerar patrones.

- Técnicas como PCA, t-SNE o selección basada en correlación son necesarias, pero requieren criterio técnico y conocimiento del dominio.

Necesidad de interpretación humana o reglas de negocio

A diferencia de los modelos supervisados, aquí el output no tiene una etiqueta clara ni una métrica objetiva de calidad.

- Es imprescindible validar los grupos generados con expertos de negocio o aplicar reglas heurísticas para entender su significado.

- En muchos casos, los modelos detectan patrones reales… pero sin contexto, son difíciles de traducir en acciones.

- Esto exige una interacción continua entre analistas y responsables funcionales.

Contexto limitado: no aplicable a cualquier problema

El aprendizaje no supervisado no sustituye procesos de predicción ni se adapta bien a problemas con objetivos definidos.

- Es útil en exploración, segmentación, compresión de datos o detección de anomalías.

- Pero no es adecuado para escenarios que requieren una decisión binaria o continua basada en un target.

- Si se fuerza su uso fuera de su ámbito natural, el modelo puede aportar ruido en lugar de claridad.

Insights útiles… pero sólo si están integrados en procesos

Identificar clústeres o patrones es solo el primer paso. Sin integración en procesos reales (CRM, atención al cliente, recomendadores, operaciones) el valor del modelo es limitado.

- Muchas implementaciones se quedan en dashboards estáticos sin conexión con el ciclo operativo.

- La clave está en conectar los outputs del modelo con acciones: asignación de recursos, personalización, priorización de incidencias, etc.

Casos de uso reales del aprendizaje no supervisado en entornos empresariales

Aplicar aprendizaje no supervisado no es cuestión de “ver qué sale del dato”. Es una decisión técnica que tiene sentido cuando necesitas ordenar información sin una variable guía clara. En entornos operativos, esto suele coincidir con tres situaciones: exceso de datos no etiquetados, falta de tiempo para clasificar manualmente o necesidad de detectar patrones antes de definir reglas.

1. Personalización basada en segmentaciones funcionales

Cuando los modelos de customer journey son estáticos o heredados del CRM, el aprendizaje no supervisado permite detectar grupos de clientes según comportamiento real, sin depender de segmentos predefinidos.

- Agrupación por secuencias de compra o recurrencia.

- Clientes que reaccionan igual ante determinadas promociones.

- Usuarios que combinan productos de forma no evidente.

Estas agrupaciones no son insights, son inputs operativos para automatizar decisiones en marketing o producto.

2. Gestión de incidencias con agrupación contextual

Los sistemas de soporte y ticketing acumulan descripciones libres, sin estructura. Los modelos de aprendizaje no supervisado ayudan a agrupar tickets por similitud semántica o técnica, lo que mejora tiempos de respuesta y priorización.

Aplicaciones:

- Agrupación automática por tipos de error.

- Priorización de problemas frecuentes no registrados como categorías.

- Asignación dinámica a equipos según clúster técnico.

3. Optimización de pricing y catálogo por comportamiento

En ecommerce y retail, las categorías comerciales no siempre reflejan cómo interactúan los usuarios con el catálogo. Con clustering puedes:

- Detectar productos equivalentes en valor percibido aunque no lo estén en el árbol de producto.

- Analizar patrones de co-compra para reorganizar o empaquetar.

- Reajustar precios en grupos de productos que compiten entre sí (intra-categoría).

4. Anomalías no definidas a priori

En entornos industriales o de seguridad, muchas veces no sabes qué tipo de desviación debes vigilar hasta que ocurre. El aprendizaje no supervisado ayuda a detectar outliers sin necesidad de definir qué es un “fallo”.

- Comportamientos anómalos en sensores de planta.

- Secuencias de uso inusuales en plataformas digitales.

- Variaciones en patrones logísticos sin explicación evidente.

No se trata de explorar los datos “por curiosidad”, sino de integrar la estructura emergente en procesos automatizables.

Y eso solo es útil cuando el output del modelo de aprendizaje no supervisado se activa en flujos ya existentes o conectarse con reglas de negocio claras.

El papel de los modelos generativos en la evolución del aprendizaje no supervisado

Durante años, aplicar aprendizaje no supervisado en una organización implicaba algo muy concreto: preprocesado de datos, elección de variables, ajuste de algoritmos como k-means, validación interna y posterior interpretación del resultado. Todo eso sigue siendo válido. Pero hoy, gracias a los modelos generativos, hay una vía alternativa (más accesible, menos técnica) para resolver parte de esos mismos problemas.

¿Qué aportan los modelos generativos como los LLM y VLM?

Los modelos generativos de lenguaje (LLM) y visión (VLM) tienen una ventaja clave: ya están entrenados sobre cantidades masivas de información semántica y visual, lo que les permite operar directamente sobre descripciones, imágenes o texto libre sin necesidad de entrenamiento adicional.

En términos prácticos, eso significa que puedes:

- Generar clústeres semánticos directamente a partir de descripciones de producto, sin crear un modelo de embeddings propio.

- Agrupar imágenes por contenido contextual (no solo por píxeles) sin tener que entrenar un modelo de visión tradicional.

- Interpretar relaciones entre elementos usando prompts, reglas o simples consultas, sin pipeline de machine learning.

Menos carga técnica, más velocidad de integración

Para muchos equipos de datos o producto, esto representa una reducción drástica en la fricción:

- No se necesita definir manualmente las variables clave del clustering.

- Se reduce la dependencia de roles altamente técnicos.

- Se acelera el tiempo desde el dato hasta el insight estructurado.

Esto no implica pérdida de rigor, sino cambio de enfoque: pasamos de entrenar modelos a diseñar prompts, controlar outputs y evaluar la coherencia del resultado.

Ejemplos funcionales en entornos reales

- Retail: usar un LLM para clasificar productos automáticamente por estilo, funcionalidad o tono de uso, a partir de sus descripciones.

- Industria: agrupar reportes de averías redactados en texto libre según contexto operativo, sin definir categorías previas.

- Ciberseguridad: identificar patrones de comportamiento en logs de eventos, pidiendo al modelo generar agrupaciones por similitud contextual.

¿Sustituye esto al aprendizaje no supervisado tradicional?

No. Lo complementa.

Los modelos generativos no reemplazan por completo los algoritmos clásicos de clustering, especialmente cuando:

- Se necesita trazabilidad matemática precisa.

- El volumen de datos es alto y homogéneo.

- Hay que controlar el modelo a nivel técnico o regulatorio.

Pero para muchos casos intermedios (exploración rápida, soporte a negocio, prototipado) los generativos reducen significativamente el coste de acceso al valor estructural de los datos.

Middleware de IA como SofIA: integración, trazabilidad y gobernanza de modelos

En la práctica, uno de los retos más frecuentes en proyectos de inteligencia artificial no es entrenar modelos, sino hacer que convivan. A medida que las organizaciones empiezan a trabajar simultáneamente con modelos clásicos de machine learning (como los de aprendizaje no supervisado)y capacidades generativas (como LLMs o VLMs), la necesidad de una capa intermedia que estructure esa convivencia se vuelve crítica. No solo por eficiencia técnica, sino por trazabilidad, control y escalabilidad.

Es aquí donde herramientas como SofIA adquieren un rol operativo clave: actúan como middleware de IA, orquestando motores diversos dentro de una arquitectura común, sin obligar a diseñar todo desde cero ni atarse a una única tecnología.

¿Qué resuelve un middleware como SofIA?

La función de SofIA no es “hacer magia”, sino resolver las fricciones reales que surgen al combinar modelos distintos en flujos de decisión empresarial. Algunos puntos clave:

- Conecta sin reconstruir: permite acoplar modelos tradicionales (como clustering o PCA) con modelos generativos, sin necesidad de migraciones costosas o dependencias cerradas.

- Modularizar por diseño: cada modelo puede funcionar como un componente desacoplado, orquestado por reglas, eventos o condiciones del negocio.

- Genera logs interpretables: cada entrada, salida y decisión queda registrada, lo que permite auditar el comportamiento del sistema y detectar desviaciones.

SofIA: plataforma corporativa de IA

Trazabilidad y control: condiciones para operar con IA en producción

Cuando un sistema basado en IA empieza a participar en decisiones operativas (desde recomendaciones hasta asignación de recursos), ya no es opcional preguntarse cómo llegó a esa conclusión.

SofIA incorpora trazabilidad estructural desde el diseño, registrando los inputs y outputs de cada modelo de aprendizaje no supervisado junto con la lógica aplicada, lo que permite auditar el flujo de decisión de forma independiente al proveedor del modelo. Además, activa alertas y análisis de comportamiento ante desviaciones o patrones anómalos. Este enfoque no solo se alinea con las buenas prácticas de gobernanza, sino que también reduce el riesgo operativo asociado a modelos que evolucionan dinámicamente en producción.

Gobernanza real, no sólo visibilidad

La gobernanza va más allá de la visibilidad: implica definir quién puede modificar modelos, cómo se versionan, cuándo se actualizan y con qué nivel de permisos. SofIA incorpora esta capa de control mediante gestión de roles, políticas de rollback para revertir decisiones automatizadas y monitorización activa de uso, rendimiento y desviaciones. Este marco es esencial para que los modelos (especialmente los generativos) operen dentro de los límites definidos por la organización y se mantengan alineados con los criterios de seguridad, negocio y cumplimiento.

Habilitar, no imponer: una arquitectura preparada para evolucionar

SofIA no impone una arquitectura cerrada ni condiciona a una tecnología única. Está diseñada para habilitar entornos híbridos, donde pueden convivir modelos clásicos desarrollados internamente, (incluidos los de aprendizaje no supervisado), capacidades generativas integradas vía API y reglas de negocio que actúan como filtros, validaciones o disparadores del flujo. Esta flexibilidad es clave cuando el objetivo no es cambiarlo todo, sino encajar la inteligencia artificial en lo que ya existe sin romper la lógica operativa actual.

SofIA permite trabajar con distintas tecnologías, sin necesidad de migraciones completas ni reconstrucción de procesos. Se adapta a ecosistemas diversos, respetando las decisiones técnicas ya tomadas y orquestando componentes según el caso de uso, el tipo de dato o el nivel de control requerido. Esa capacidad de modular sin imponer es lo que la convierte en una herramienta funcional para entornos con realidades mixtas y estrategias evolutivas.

Reflexión final: madurez tecnológica, eficiencia y democratización del aprendizaje no supervisado

El aprendizaje no supervisado ya no es terreno exclusivo de grandes compañías ni de laboratorios de datos con recursos infinitos. Cuando se combina con modelos generativos y se integra correctamente a través de un middleware como SofIA, se convierte en una pieza útil y controlable dentro del flujo de decisiones de una empresa real. No porque todo sea más fácil, sino porque la arquitectura actual permite usar solo lo necesario, donde aporta valor y sin rehacer el sistema.

Esta es la verdadera madurez tecnológica: no usar lo más complejo, sino lo más útil. En lugar de forzar modelos únicos para todos los casos, una estrategia bien diseñada permite combinar motores clásicos y generativos según el tipo de dato, el contexto operativo o el nivel de exigencia. Y cuando esa inteligencia se estructura desde una capa como SofIA, la organización gana modularidad, trazabilidad y capacidad real de evolución sin comprometer lo que ya funciona.

Si estás en ese punto en el que los datos ya existen, los modelos están al alcance, pero lo difícil es conectarlos con procesos reales sin perder control, probablemente no se trate de más algoritmos, sino de rediseñar la forma en que tu sistema organiza la inteligencia. Ahí es donde podemos ayudarte: mapeamos escenarios, analizamos flujos y trabajamos contigo para estructurar una IA que funcione, escale y se pueda gobernar desde el primer día.