Cuando un modelo de LLM empieza a comportarse de forma distinta a como lo entrenaste, no es un error, es su naturaleza. Los LLM no son APIs estáticas ni algoritmos cerrados; son sistemas que evolucionan con cada dato, cada prompt y cada contexto.

Esta dinámica propia de los LLM convirtió el concepto de LLMOps en una necesidad urgente para cualquier empresa que quiera operar IA generativa con rigor técnico y no solo hacer pruebas aisladas.

Durante años, DevOps y MLOps lograron estabilizar el puente entre desarrollo, infraestructura y datos. Pero los LLM rompieron ese equilibrio: requieren versionado semántico, experimentación gobernada, medición continua del comportamiento y un control real sobre cómo y por qué el modelo cambia en producción. El reto ya no es desplegar un modelo, sino gobernar su ciclo de vida completo.

Y ahí es donde fallan la mayoría de estrategias actuales. Muchas organizaciones se enfocan en entrenar modelos, pero pocas controlan cómo evolucionan una vez están integrados en procesos críticos. Sin disciplina operativa, un LLM puede derivar, degradarse o generar costes imprevisibles sin que nadie lo note a tiempo.

Por eso LLMOps se ha convertido en el nuevo marco operativo: una arquitectura donde la infraestructura, datos, entrenamiento, despliegue, seguridad y gobernanza funcionan como un solo flujo.

De DevOps a LLMOps: la evolución natural del mundo “Ops” hacia los modelos generativos

La transición de DevOps a LLMOps no es una tendencia, sino una consecuencia lógica de cómo han cambiado los sistemas y el tipo de inteligencia que hoy desplegamos. Cada salto del mundo Ops nació para resolver un límite del anterior:

- DevOps unió desarrollo e infraestructura;

- MLOps integró datos y experimentación;

- LLMOps surge porque los modelos de lenguaje por su tamaño, complejidad y comportamiento emergente ya no pueden gestionarse con las reglas anteriores.

La era DevOps: cuando “entregar” software era el verdadero cuello de botella

DevOps fue una respuesta cultural y técnica. Quienes vivimos esa transición recordamos la sensación de urgencia: demasiados handoffs, demasiadas manos en el proceso, demasiado tiempo entre “ya está desarrollado” y “ya está en producción”. Pero DevOps no solo automatizó, sino que alineó hasta lograr que, por primera vez, infraestructura y desarrollo hablaran en tiempo real.

Pero en cuanto los modelos LLM empezaron a tomar decisiones, ese equilibrio volvió a romperse.

MLOps: el momento en que el dato se convirtió en parte del producto

Con MLOps no buscábamos rapidez, sino reproducibilidad: si entrenas hoy un modelo con los mismos datos, deberías obtener los mismos resultados. Y si tu dataset cambia, deberías saber por qué el modelo ya no funciona igual. En este sentido, MLOps resolvió:

- cómo versionar datasets,

- cómo repetir entrenamientos,

- cómo detectar drift,

- cómo evaluar modelos de forma continua.

Lo suficiente para modelos predictivos, pero insuficiente para sistemas generativos.

El quiebre conceptual: los LLM no responden de forma predecible porque devuelven un comportamiento basado en su propio aprendizaje

Aquí es donde cambia todo. Un LLM no es un modelo que devuelve un número: es un sistema que responde, combina contexto, interpreta instrucciones, improvisa y, por ello, incluso puede desviarse de lo esperado. Esta naturaleza introduce problemas operativos que ninguna de las prácticas anteriores sabía gestionar:

- No basta con medir accuracy; ahora hay que medir coherencia, alineación y riesgo semántico.

- No sirve con versionar el modelo; hay que versionar su comportamiento, sus prompts, sus políticas y hasta sus restricciones.

- No sirve una monitorización tradicional; necesitamos métricas que detecten cambios de actitud del modelo, no solo cambios estadísticos.

LLMOps: operar un modelo que no deja de moverse

Mientras DevOps estabilizaba pipelines y MLOps estabilizaba datos, LLMOps estabiliza el comportamiento.

En un entorno con LLMOps maduro, la compañía no solo despliega un modelo: lo monitorea, lo compara, lo corrige, lo reentrena, lo audita y lo controla mientras está funcionando. Pero a diferencia de MLOps, aquí no estamos gestionando un flujo predecible:

- El coste cambia con cada prompt.

- La seguridad depende de cómo el usuario formula la pregunta.

- El modelo puede producir un output diferente sin que nada haya cambiado en la infraestructura.

- El dataset que alimenta el RAG puede alterar súbitamente el comportamiento.

Y precisamente por eso, surge LLMOps como un marco necesario, el único donde infraestructura, datos, inferencia, evaluación, seguridad y gobernanza conviven en un ecosistema continuo, en lugar de convivir en una serie de etapas.

La verdadera razón por la que LLMOps no es “la siguiente versión” de MLOps

Decir que LLMOps es “un subconjunto de MLOps” es técnicamente correcto, pero conceptualmente pobre. El problema de fondo es que los LLM tienen demandas completamente distintas:

- necesitan trazabilidad de prompts,

- requieren pruebas A/B con comportamiento real,

- dependen del contexto para tomar decisiones,

- generan costes por token que requieren control granular,

- y son un riesgo semántico si no se gobiernan.

Una arquitectura MLOps tradicional puede seguir funcionando hasta que el primer modelo generativo empieza a salirse del guión. Y cuando esto ocurre, LLMOps deja de ser opcional y pasa a ser un sistema nervioso operativo.

El cierre estratégico: no se trata de entrenar LLM, sino de sostenerlos

La mayoría de empresas ya pueden entrenar un modelo, pero lo que que casi ninguna compañía logra hacer con seguridad es:

- garantizar que el modelo se comporte igual mañana,

- evitar que derive sin que nadie lo note,

- comprender por qué una respuesta cambió,

- controlar los costes en tiempo real,

- o detectar cuándo el modelo dejó de alinearse al negocio.

En este contexto es donde aparece LLMOps como marco operativo fundamental.

El ciclo de vida real de un LLM en producción

Aquí aterrizamos la realidad: un LLM no vive en una línea recta, vive en un ciclo en el que cada fase afecta a la siguiente y donde cualquier desviación (en el dato, en el contexto o en la infraestructura) puede cambiar su comportamiento final.

Operar IA generativa no consiste en “poner un modelo en producción”, sino en sostener un organismo que evoluciona. El siguiente flujo resume cómo debería funcionar un ciclo de vida maduro en entornos empresariales.

1. Entrenamiento y reentrenamiento: el origen donde se define la gobernabilidad

Antes de que un LLM toque producción, vive un periodo que muchas organizaciones subestiman: el laboratorio. No se trata de entrenar “el mejor modelo”, sino aquel que pueda ser operado a largo plazo.

Aquí el trabajo es casi quirúrgico: se prueban arquitecturas, tokenizadores, hiperparámetros, variantes LoRA, datasets filtrados o ampliados, y todo ello se documenta como si fuese una bitácora científica. Porque un modelo que no está versionado, registrado y auditado desde esta fase… ya nació sin gobernanza.

2. Despliegue y escalabilidad: la ingeniería donde el modelo deja de ser idea

El salto a producción es la primera vez que el LLLM interactúa con la realidad. No hablamos solo de contenedores o GPUs; hablamos de decisiones arquitectónicas que condicionan el coste, la latencia y la resiliencia durante meses.

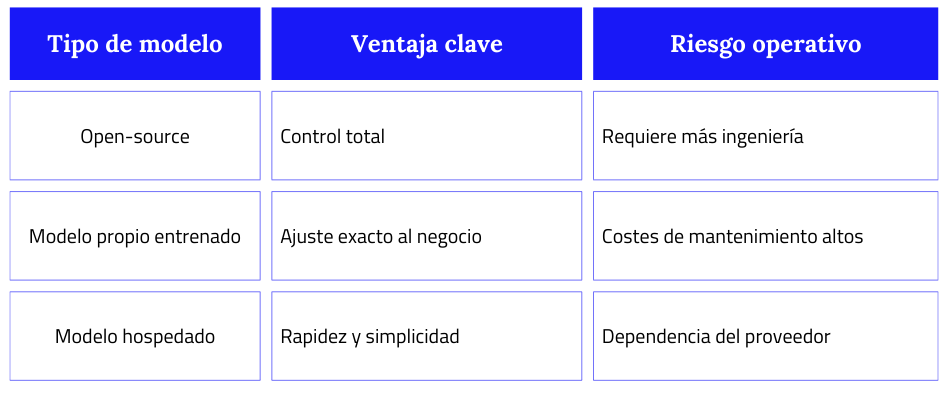

Aquí las alternativas no son triviales y podemos desgranarlas en este esquema:

Mientras DevOps se enfocaba en pipelines, esta etapa se enfoca en cómo hacer que un modelo de miles de millones de parámetros responda rápido, barato y de forma estable. No hay margen para la improvisación.

3. Monitorización y mantenimiento: donde el modelo empieza a revelar su carácter

Una vez el modelo está “vivo”, empieza la verdadera operación. Y aquí ocurre algo que en MLOps no existía: el modelo cambia sin que nada cambie. Preguntas, contextos, estilos de prompt, incluso cambios culturales influyen en su comportamiento. Por eso esta fase no monitorea servidores: monitorea decisiones.

Tres señales que un directivo debería observar sin excusas:

- La latencia empieza a subir sin razón aparente.

- La coherencia del output baja, aunque el modelo no fue actualizado.

- El coste por token empieza a desviarse, aún con el mismo tráfico.

Estas señales son equivalentes a “la vitalidad del modelo”. Un LLM sin mantenimiento es un modelo que se desalineará tarde o temprano.

4. Optimización y ajuste: la parte artesana del ciclo

Esta es la fase menos visible y más crítica. Aquí no se cambia el modelo: se perfecciona.

Dentro de un marco operativo LLMOps, esta es la etapa donde cada decisión tiene impacto directo en coste, rendimiento y alineación con el negocio. Igual que un luthier ajusta una guitarra, aquí se ajusta la IA para que responda exactamente como el negocio necesita.

El trabajo de ajuste puede tomar múltiples formas:

- Un fine-tuning ligero para una nueva línea de negocio.

- Un ajuste en el RAG porque tu base documental creció.

- Una cuantización para reducir el coste de inferencia.

- O incluso un A/B testing para decidir qué versión escala mejor.

Es una fase donde ingeniería, datos y negocio se sientan juntos. Y esa colaboración determina si el modelo escala, o se convierte en deuda técnica.

5. Seguridad y Gobernanza: la frontera donde se protege el modelo y la reputación

Aquí no hablamos de firewalls: hablamos de comportamiento. Un LLM puede filtrar información sin saber que está filtrando, puede “inventar” datos creíbles o puede dejarse manipular por prompts adversarios. Por eso esta fase incluye evaluaciones semánticas, auditorías de uso, límites conversacionales, roles, políticas, controles de fuga y análisis de desviaciones.

6. Actualización continua: el momento en que la IA deja de ser un proyecto y se convierte en un sistema vivo

Esta fase es donde se separan los proyectos de IA de las soluciones que realmente sostienen una operación. Un LLM nunca permanece estático: cambia con los datos, con las consultas, con el negocio y con el propio entorno regulatorio. Por eso, en organizaciones que operan IA a escala, el modelo necesita algo más que supervisión técnica: necesita una capa de continuidad que gobierne su evolución, justo el tipo de enfoque que propone LLMOps.

En OpenSistemas abordamos este punto a través de SofIA, nuestro middleware de IA corporativa diseñada para operar modelos en entornos corporativos.

No se trata solo de ejecutar un modelo, sino de entender cómo cambia, detectar drift, comparar versiones, automatizar alertas, asegurar trazabilidad y orquestar los pipelines necesarios para actualizar o incluso retroceder cuando el comportamiento del modelo se aleja de lo esperado.

Un rol clave de SofIA en este ciclo es garantizar que la organización trabaja siempre con la versión más estable, segura y alineada del modelo, incluso cuando los datos, los casos de uso o el contexto del negocio evolucionan.

LLMOps vs MLOps: por qué no son lo mismo y dónde está el valor estratégico

La industria lleva años operando modelos predictivos con MLOps: pipelines limpios, métricas claras, datasets versionados, comportamientos estables. Funciona mientras el modelo clasifica, predice o recomienda. Pero cuando entra en juego un LLM, las reglas cambian por completo. Ya no hablamos de modelos que “calculan”: hablamos de modelos que generan, razonan, improvisan y responden según el contexto. Este salto convierte a LLMOps en un marco completamente distinto, no una extensión de MLOps.

Los modelos tradicionales predicen

Aquí está la diferencia que lo cambia todo:

- Un modelo clásico devuelve el mismo resultado ante la misma entrada.

- Un LLM puede dar dos respuestas distintas ante la misma pregunta.

Porque su comportamiento depende del prompt, el contexto, el estado del negocio y la calidad de los datos. Aquí es donde el marco MLOps deja de ser suficiente.

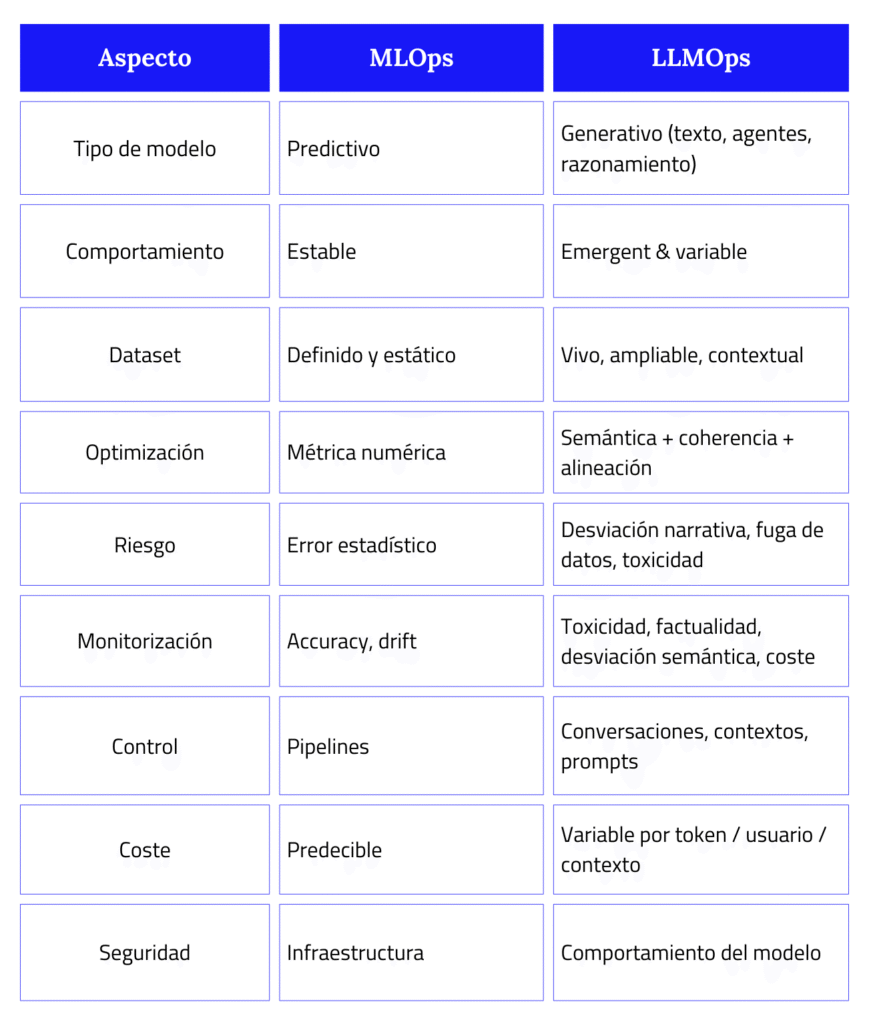

Comparativa directa: MLOps vs. LLMOps

Podemos revisar las diferencias en este cuadro comparativo entre MLOps y LLMOps:

En resumen:

- MLOps opera modelos.

- LLMOps ópera modelos que hablan, razonan y pueden equivocarse de formas nuevas.

Por qué LLMOps exige nuevas capacidades

Con los modelos generativos no basta con entrenar y desplegar. Hay que controlar lo que dicen, cómo lo dicen y cuánto cuesta que lo digan. El marco operativo LLMOps requiere:

- Un sandbox para experimentar sin romper producción.

- Orquestación de prompts y políticas de interacción.

- Auditorías de respuestas y explicabilidad a nivel conversacional.

- Límites de uso según rol (interno, cliente, proveedor, etc).

- Control financiero diario: los tokens no perdonan el incremento de costes aunque tengamos límite presupuestario asignado.

Sin estas capacidades, cualquier modelo generativo se degrada, se descontrola o se vuelve demasiado caro. Por eso consideramos que estas capacidades mínimas no son opcionales.

Infraestructura, costes y escalabilidad: el lado invisible del LLMOps

Cuando una organización decide apostar por IA generativa, suele poner el foco en el modelo: su precisión, su rendimiento, su arquitectura. Pero en producción, el verdadero desafío nunca es el modelo, sino todo lo que hay que sostener alrededor para que el modelo funcione cada día.

Es ahí donde LLMOps revela su importancia: en la capacidad de mantener vivo, estable y rentable un sistema cuyo comportamiento cambia con cada interacción.

El coste real no viene con el entrenamiento: llega después

Entrenar un modelo es un esfuerzo grande, pero finito. El problema aparece cuando el modelo empieza a trabajar para la empresa. Cada consulta, cada contexto añadido, cada llamada simultánea empieza a generar consumo: GPU, memoria, tokens, latencia. Es como encender un motor de alto rendimiento: el coste no está en construirlo, sino en mantenerlo encendido sin que consuma de más.

La clave estratégica: prever antes de reaccionar

Una buena arquitectura de LLMOps no intenta apagar incendios; evita que empiecen. Por eso incorpora visibilidad absoluta sobre el comportamiento del modelo y su consumo, de forma que cada decisión técnica se pueda anticipar.

En una operación madura, la empresa es capaz de ver:

- qué modelo está consumiendo más y por qué,

- qué peticiones elevan el coste por token,

- cuándo la latencia empieza a aumentar,

- en qué momentos conviene activar o detener instancias,

- cómo varía el gasto según equipo, servicio o usuario.

La previsibilidad no es un lujo: es la única forma de escalar sin perder el control del presupuesto.

La ingeniería detrás: cuando la infraestructura marca la diferencia

A nivel técnico, operar un LLM implica jugar en una liga completamente distinta. Ya no estamos hablando de un servidor convencional; estamos hablando de una arquitectura diseñada para mover modelos gigantes en tiempo real. Y es justo aquí donde el enfoque LLMOps empieza a marcar una diferencia operacional clara.

En esta capa ocurre lo crítico:

- se eligen las GPUs adecuadas según el tamaño del modelo,

- se ajusta la vRAM en función del contexto máximo,

- se distribuyen cargas entre clusters para no saturar ninguna instancia,

- se usan modelos cuantizados cuando el coste empieza a ser inconveniente,

- se orquestan contenedores especializados que optimizan cada token generado.

Nada de esto es visible para el usuario final, pero todo ello determina si la IA será sostenible, escalable y confiable. En entornos reales, esta ingeniería es la que separa un modelo que funciona “a veces” de un sistema que opera con precisión incluso bajo picos de demanda. Y esa es, en esencia, la disciplina que sostiene cualquier estrategia seria de LLMOps.

La IA empresarial como “controlador de vuelo” de la infraestructura

Aquí es donde entra el aporte diferenciador de OpenSistemas. En vez de dejar que cada equipo gestione su modelo en solitario, la arquitectura de SofIA incorpora una capa de IA empresarial que actúa como un centro de operaciones. No controla el modelo por ti. Controla lo que rodea al modelo para que nunca pierda estabilidad. Su función esencialmente es responder a preguntas que el equipo de tecnología se hace todos los días:

- ¿Qué modelo debería escalar primero: el que tiene más tráfico o el que penaliza más la latencia?

- ¿Conviene crecer verticalmente con más GPU o horizontalmente con más réplicas?

- ¿Cuándo es mejor reducir tamaño del modelo y cuándo mantenerlo tal cual?

- ¿Qué combinaciones de prompts están consumiendo más recursos sin aportar valor?

- ¿Se puede ahorrar coste sin afectar calidad? (spoiler: sí, casi siempre).

Esta capa analiza, decide, ajusta y corrige, de forma que el modelo nunca camine solo.

SofIA como capa de LLMOps: el middleware que convierte IA en negocio

En un entorno donde los LLM evolucionan, consumen recursos y se integran en procesos críticos, la diferencia no está en tener un modelo potente, sino en contar con una capa operativa que los haga sostenibles y gobernables. SofIA nace justo para unir modelos, datos, seguridad e infraestructura en un único marco que permita a la IA vivir dentro de la organización como un sistema estable, trazable y escalable.

SofIA: plataforma corporativa de IA

Un middleware que unifica modelo, datos e infraestructura

SofIA funciona como un punto de acceso único para conectar modelos (Azure OpenAI, Gemini, Claude, Llama 3, modelos propios o fine-tuned), infraestructuras híbridas (cloud, on-premise, VNet privadas) y datos empresariales (BBDD, ficheros, APIs, repositorios).

La lógica es centralizar por necesidad, ya que sin una capa común que unifique, cada proyecto de IA acaba funcionando como una isla autónoma difícil de controlar, actualizar y auditar.

Agentes que operan como equipos especializados

La arquitectura de SofIA permite crear agentes IA con conocimientos, herramientas y funciones específicas. No actúan de forma aislada: colaboran, se supervisan, se organizan jerárquicamente y forman flujos multi-etapa.

Un coordinador decide qué agente interviene, cuál consulta datos, cuál utiliza RAG/CAG, cuál accede a un API corporativa. El resultado es una IA que no improvisa, sino que sigue un proceso controlado y reproducible.

Versionado real: del modelo y del comportamiento

Una de las fortalezas de SofIA es que versiona todo: no solo pesos de modelos o checkpoints, sino también prompts, contextos, restricciones, herramientas activadas y reglas operativas. Este tipo de trazabilidad (clave en cualquier disciplina seria de LLMOps) permite entender no solo qué modelo respondió, sino qué comportamiento exacto produjo cada salida.

Para entornos auditados, regulados o sensibles, esta visibilidad es tan importante como el rendimiento del modelo.

Datos del lado seguro: RAG avanzado sin salir del perímetro

SofIA conecta nativamente con bases de datos, sistemas de ficheros, repositorios y APIs corporativas, siempre respetando permisos y roles. Con su motor de RAG y CAG avanzado, el modelo no inventa: genera respuestas apoyadas en documentos, datos estructurados o repositorios internos, manteniendo la privacidad completa del cliente.

Este enfoque encaja directamente con las buenas prácticas de LLMOps, permitiendo llevar IA generativa a procesos reales sin exponer datos ni modificar infraestructuras críticas.

Integración natural donde trabaja la organización

La IA solo se vuelve útil cuando aparece en el flujo de trabajo del equipo. SofIA lo habilita con una interfaz web estilo ChatGPT privado, plugins para VS Code/JetBrains, integración en Teams, Slack, WhatsApp, Google Chat, extensiones de navegador para operar sobre ERPs o CRMs, y un builder visual no-code para crear flujos IA sin programar.

En otras palabras: SofIA es IA operativa, no IA de laboratorio. Y es precisamente esta capacidad de integrarse en el día a día lo que convierte a LLMOps en una disciplina estratégica para organizaciones que necesitan resultados, no prototipos.

Gobernanza: permisos, auditoría y control de costes

SofIA incorpora controles RBAC basados en los IDPs corporativos, auditoría completa de quién usó qué modelo y qué datos, listas blancas de modelos aprobados, control de tokens y alertas de consumo, además de cumplimiento con GDPR, ISO 27001/27701 y normativas sectoriales. La IA deja de ser una caja negra y se convierte en un sistema seguro, trazable y confiable.

El verdadero diferenciador

Entrenar modelos es relativamente sencillo hoy. Lo difícil (y lo que SofIA resuelve) es operarlos en producción con estabilidad, eficiencia, seguridad y gobernanza. Es el middleware que convierte LLMOps en algo tangible: modelos que se integran, se controlan, se escalan y se alinean con procesos corporativos sin poner en riesgo presupuesto, infraestructura o cumplimiento.

SofIA no sustituye la IA: la hace viable como infraestructura de negocio.

Reflexión final

La IA generativa ha colocado a las organizaciones en un punto de inflexión: nunca habíamos contado con sistemas tan capaces, pero tampoco con tecnologías que exigieran tanto control para mantenerse alineadas al negocio. Hoy, un modelo puede impulsar decisiones, automatizar procesos y abrir nuevas líneas de valor, pero también puede desviarse en cuestión de horas si nadie vigila su evolución.

El verdadero reto que afrontan los equipos directivos no es cómo incorporar IA, sino cómo sostenerla con garantías. Y es justamente aquí donde la disciplina LLMOps se vuelve imprescindible.

SofIA se diseñó para ocupar ese espacio crítico: el punto donde la IA deja de ser un conjunto de pruebas aisladas y se convierte en un entramado que sostiene áreas, procesos y equipos enteros. Su valor no está en generar más respuestas, sino en permitir que cada respuesta tenga contexto, trazabilidad y un marco técnico que la respalde. En que la organización tenga la certeza de que su IA está bajo control, incluso cuando todo alrededor evoluciona.

Si esta reflexión os sitúa frente a preguntas sobre vuestra propia arquitectura, es una buena señal. Significa que vuestra organización está pensando en la IA de forma estratégica. Este es un buen momento para revisar el nivel de madurez de vuestras prácticas, comparar el enfoque con estándares reales de LLMOps y entender cómo una capa como SofIA podría fortalecer vuestras operaciones. Si queréis dar el paso estamos listos para conversar contigo y analizar vuestro caso con visión de tecnología y negocio.