El Proctoring en entornos digitales ha transformado la forma en que se conciben los exámenes. La digitalización de las pruebas rompe con los referentes tradicionales de control, donde la presencia física, la mirada del vigilante y el espacio compartido aseguraban la integridad académica. En el ámbito online, esas coordenadas desaparecen y surge la necesidad de un ecosistema tecnológico capaz de garantizar la validez y la equidad en la evaluación.

A diferencia de la supervisión tradicional, el proctoring con inteligencia artificial no se reduce a observar al estudiante mediante un dispositivo de video. Se trata de un entramado de sistemas distribuidos capaces de procesar de forma simultánea múltiples flujos de información en tiempo real: desde patrones de tecleo y movimientos oculares, hasta anomalías en la conectividad de red o indicadores biométricos imperceptibles para el ojo humano. Este nivel de análisis posibilita una observación granular, continua y objetiva, que supera ampliamente las capacidades de un supervisor humano y reconfigura el concepto mismo de integridad académica en los entornos digitales.

El proctoring con inteligencia artificial no representa una simple mejora operativa, sino una reingeniería profunda de la arquitectura evaluativa. Su incorporación obliga a las instituciones a repensar cómo se orquestan los flujos de datos, se gestionan las identidades digitales y se preserva la trazabilidad dentro de entornos distribuidos. Este rediseño estructural redefine el vínculo entre tecnología, pedagogía y seguridad, se plantea desafíos inéditos en torno a la ética algorítmica, la privacidad y la gobernanza de la confianza digital. Comprender qué ve la tecnología y qué escapa a la percepción humana es hoy la clave para construir un modelo de evaluación online resiliente, auditable y éticamente sostenible.

Por qué el proctoring manual no escala (y dónde falla)

El proctoring manual funciona en entornos controlados y con volúmenes reducidos, pero tropieza con límites operativos y de calidad cuando se intenta escalar. Aunque la supervisión humana ofrece ventajas innegables juicio contextual, interpretación ética, empatía presenta restricciones estructurales: capacidad limitada por observador, fatiga cognitiva, variabilidad en la detección de anomalías y dificultad para mantener registros auditables de manera sistemática.

Comparativa técnica: supervisor humano vs sistema multimodal

Desde una perspectiva técnica, la diferencia entre un supervisor humano y un sistema de proctoring basado en IA multimodal es sustancial. La latencia en la detección de eventos es mucho mayor en los humanos, que requieren atención focalizada y procesamiento consciente de estímulos visuales y auditivos.

Para entender dónde falla el modelo manual, conviene comparar las capacidades desde una óptica de arquitectura técnica:

- Concurrencia y cobertura: un operador humano puede seguir activamente a pocos candidatos, mientras un sistema automatizado procesa cientos o miles de sesiones en paralelo. Estas plataformas aplican políticas de muestreo dinámico y escalan hacia revisión humana cuando los algoritmos detectan desviaciones relevantes.

- Correlación multimodal: los humanos rara vez sincronizan eventos acústicos, visuales y telemétricos; los sistemas basados en IA multimodal correlacionan señales en tiempo real, detectando patrones complejos (por ejemplo, discrepancias entre audio, vídeo y métricas del navegador). Este enfoque reduce falsos positivos y mejora la consistencia en la toma de decisiones.

- Latencia y respuesta: la detección automática ofrece alertas en milisegundos, capaces de mitigar conductas en tiempo real; la intervención humana introduce retrasos operativos y dependencia de disponibilidad.

- Consistencia y sesgos: la evaluación humana introduce variabilidad y riesgo de sesgos inconscientes. Los sistemas automatizados aplican reglas homogéneas y versionables, aunque requieren mecanismos de mitigación de sesgos algorítmicos, aspecto clave en las directrices éticas de la Comisión Europea para una IA fiable.

Coste operativo y escalabilidad: escalar supervisión humana implica costos crecientes y logística compleja; en cambio, una arquitectura basada en microservicios y procesamiento distribuido.

Proctoring con IA: qué detecta más allá de la pantalla

El proctoring con inteligencia artificial trasciende la concepción tradicional de la supervisión digital. Su valor no reside en una simple observación visual del entorno, sino en la capacidad de integrar y analizar de forma orquestada distintos flujos de datos en tiempo real.

El sistema procesa información proveniente de fuentes biométricas, patrones de interacción y señales técnicas como la telemetría del dispositivo o la estabilidad de la red para construir un modelo dinámico del comportamiento del evaluado. Este enfoque no busca ver más, sino entender mejor: detectar correlaciones entre microexpresiones, variaciones de actividad y anomalías sistémicas que revelan contextos de riesgo o irregularidad.

Identidad y continuidad biométrica

La primera frontera del proctoring con IA es garantizar que quien inicia el examen sea la misma persona que lo termina. Para ello, se utilizan técnicas como la liveness detection, que distingue entre un rostro real y una reproducción (foto, video o máscara). A esto se suma la validación continua de la biometría durante la sesión, evitando la suplantación en mitad de la prueba. Este enfoque no solo asegura autenticidad, sino que también protege la legitimidad del proceso de evaluación.

Anomalías de comportamiento

Más allá de la identidad, los sistemas de proctoring con IA rastrean patrones conductuales que resultan difíciles de simular. Micro-movimientos oculares, tiempos de reacción, pausas atípicas en la escritura o variaciones en la cadencia de tecleo pueden señalar inconsistencias. Estos indicadores, por sí solos, no determinan un fraude; sin embargo, cuando se correlacionan entre sí y con otros eventos, ofrecen un nivel de detalle que un supervisor humano difícilmente podría alcanzar a gran escala.

Señales técnicas invisibles al ojo humano

Una de las capas más críticas es la detección de señales invisibles para el observador humano. El proctoring con IA puede identificar la conexión de periféricos no autorizados, el uso de máquinas virtuales, la manipulación de red o intentos de desviar la telemetría. Estos datos aportan una capa forense al sistema, donde cada anomalía técnica queda registrada y puede ser auditada posteriormente.

Es esta correlación la que permite a las instituciones mantener un control confiable y escalable, sin caer en falsos positivos ni depender únicamente del juicio humano. La pregunta clave para las instituciones es: ¿está su arquitectura lista para integrar y gestionar esta complejidad multimodal con la transparencia y robustez que la comunidad educativa exige?

Escenarios donde es imprescindible (y donde no lo es)

El Proctoring con IA aporta un enorme valor en determinados contextos educativos, profesionales y corporativos donde la integridad de la evaluación es crítica. Sin embargo, no todos los exámenes requieren el mismo nivel de supervisión. Identificar cuándo el Proctoring es imprescindible y cuándo puede sustituirse por otro tipo de estrategias de diseño evaluativo resulta clave para aprovechar al máximo la tecnología sin generar costes o complejidad innecesaria.

Certificaciones profesionales y procesos con valor jurídico

En los procesos de acreditación que cuentan con validez jurídica como certificaciones profesionales en sectores de alta exigencia (sanitario, legal, financiero, tecnológico, etc.) El Proctoring con IA es prácticamente irremplazable. Aquí la supervisión rigurosa garantiza tanto la identidad y continuidad del evaluado como la trazabilidad del proceso, ofreciendo evidencias auditables frente a reguladores u organismos certificadores.

Universidades con cohortes masivas y estudiantes globales

En el ámbito académico, especialmente en universidades que gestionan cohortes masivas distribuidas por múltiples regiones y husos horarios, el Proctoring es una herramienta imprescindible para mantener estándares homogéneos de control.

Formación corporativa en competencias críticas

El Proctoring también juega un papel clave en la formación corporativa orientada a competencias críticas. Sectores como la banca, la ciberseguridad o la industria farmacéutica requieren certificar conocimientos que impactan directamente en la seguridad, la calidad o la continuidad del negocio. En estos casos, el uso de IA asegura que el proceso de evaluación sea confiable, transparente y resistente a manipulaciones, reforzando la confianza tanto de empleados como de auditores o clientes.

Cuando no es necesario: el valor del rediseño del assessment

No obstante, no todos los escenarios demandan la complejidad del Proctoring con IA. En evaluaciones formativas, trabajos prácticos, proyectos colaborativos o metodologías basadas en aprendizaje continuo, el riesgo de fraude es menor y los resultados pueden validarse sin necesidad de supervisión avanzada. En estos contextos, invertir en un sistema robusto de proctoring no añade valor real: la estrategia óptima suele ser rediseñar el assessment para enfocar la evaluación en la aplicación del conocimiento más que en la vigilancia del proceso.

En definitiva, el Proctoring con IA debe implementarse de forma estratégica: imprescindible en certificaciones oficiales, universidades globales y formación corporativa de alto impacto, pero prescindible en evaluaciones donde la clave es la pedagogía más que el control. Esta diferenciación permite a las instituciones escalar de manera eficiente sin sacrificar ni la integridad académica ni la experiencia del evaluado.

Retos técnicos reales que definen el éxito

El proctoring con inteligencia artificial ha revolucionado la supervisión de evaluaciones digitales, pero su implementación efectiva enfrenta desafíos técnicos complejos que determinan su éxito.

Latencia y concurrencia en tiempo real

Uno de los principales desafíos técnicos del proctoring con IA es garantizar la capacidad de procesar y analizar múltiples flujos de datos simultáneamente sin comprometer la latencia. La supervisión en tiempo real requiere que el sistema gestione miles de exámenes concurrentes, procesando video, audio, datos biométricos y señales técnicas con mínima demora para detectar anomalías oportunamente. La infraestructura debe ser robusta y escalable para evitar cuellos de botella que afecten la experiencia del usuario y la eficacia del control.

Calidad de datos de entrada: hardware, conectividad y ruido

La precisión del proctoring depende en gran medida de la calidad de los datos de entrada. Variables como la resolución de la cámara, la estabilidad de la conexión a internet y el nivel de ruido ambiental impactan directamente en la capacidad del sistema para interpretar correctamente las señales biométricas y conductuales. La heterogeneidad de dispositivos y entornos de los evaluados añade complejidad, requiriendo algoritmos adaptativos que puedan compensar estas variaciones sin perder efectividad.

Deriva de modelos y recalibración continua

Los modelos de IA utilizados en proctoring están sujetos a la deriva, es decir, a la pérdida progresiva de precisión debido a cambios en los patrones de comportamiento o en las condiciones del entorno. Para mantener altos niveles de fiabilidad, es imprescindible implementar procesos de recalibración continua y actualización de modelos, basados en datos reales y feedback constante. Esta dinámica asegura que el sistema se adapte a nuevas formas de interacción y posibles técnicas de fraude emergentes.

Riesgo de falsos positivos y políticas de escalado humano

Un desafío crítico es minimizar los falsos positivos, que pueden generar alertas injustificadas y afectar la experiencia del evaluado. Para ello, el proctoring con IA debe integrarse con políticas claras de escalado que involucren revisión humana en casos dudosos, combinando la eficiencia del análisis automatizado con el juicio experto. Este enfoque híbrido es fundamental para equilibrar precisión, confianza y respeto hacia los usuarios.

Middleware: la capa que decide si el sistema es gobernable

En una arquitectura de Proctoring con inteligencia artificial, el middleware es el elemento que transforma un conjunto de algoritmos aislados en una plataforma controlable, auditable y adaptable. Su función no es solo “conectar” componentes, sino regular, registrar y orquestar todo el flujo de evaluación, garantizando que el sistema mantenga integridad y cumplimiento aun cuando cambien las condiciones operativas o los requisitos regulatorios.

Desacoplamiento estructural de los motores de detección

El Proctoring moderno combina varios subsistemas (análisis facial, detección de patrones de teclado, monitoreo de red, etc.). El middleware actúa como bus de servicios neutral que:

- Normaliza las APIs de cada motor, permitiendo que nuevos algoritmos se integren sin reescribir la lógica de negocio.

- Gestiona versiones de modelos de IA de forma independiente, de modo que una actualización de un detector de micro expresiones no interrumpa los demás módulos.

- Proctoring se vuelve modular, lo que reduce la complejidad de mantenimiento y abre la puerta a despliegues canarios o pruebas A/B sin riesgo para la sesión en curso.

Registro de metadatos y trazabilidad verificable

Para que una evaluación sea aceptada por universidades, organismos de acreditación y auditorías legales, cada acción debe quedar documentada de forma inmutable. El middleware:

- Captura metadatos de sesión (identificador de examen, timestamp, versión del modelo, estado de la red y características del hardware del cliente).

- Almacena logs de decisión que describen por qué un algoritmo generó una alerta, los umbrales aplicados y la correlación con otras fuentes de datos.

- Aplica firmas criptográficas a los registros, garantizando su integridad y facilitando auditorías externas sin necesidad de intervención manual.

Políticas dinámicas y gobernanza en tiempo real

El entorno de un examen online es volátil: cambios de conectividad, dispositivos no compatibles o intentos de fraude emergentes pueden requerir ajustes inmediatos. El middleware permite:

- Reglas basadas en contexto que adaptanálisis (p. ej., aumentar la sensibilidad del detector de ruido cuando la calidad del audio cae bajo un umbral).

- Escalado automático a revisión humana cuando la probabilidad de falsos positivos supera un límite predefinido, asegurando que la decisión final siempre cuente con supervisión experta.

- Actualizaciones de política sin downtime, gracias a un motor de reglas que se alimenta de los metadatos en tiempo real y puede activarse o desactivarse bajo demanda.

SofIA: middleware especializado para entornos de Proctoring

En entornos educativos y corporativos donde convergen múltiples tecnologías, el middleware es el componente que otorga coherencia, interoperabilidad y control. SofIA, diseñada específicamente para orquestar ecosistemas de proctoring con inteligencia artificial.

- Coordina múltiples motores de detección (visión, audio, análisis de red) mediante un bus de eventos desacoplado, lo que permite añadir o retirar componentes sin interrumpir la sesión.

- Registra cada interacción en un repositorio de metadatos certificado, proporcionando trazabilidad completa para auditorías académicas y regulatorias.

- Ejecuta políticas dinámicas mediante un motor de reglas basado en eventos, habilitando respuestas automáticas (p. ej., solicitar revisión humana) y evitando bloqueos tecnológicos o “vendor lock‑in”.

- Escala horizontalmente en la nube, manteniendo latencia mínima aun con miles de exámenes concurrentes, y soporta la recalibración continua de modelos sin pérdida de disponibilidad.

Implementar una capa como SofIA no implica frenar la innovación, sino estructurarla. La verdadera transformación digital en educación se logra cuando la institución combina la escala técnica con una visión estratégica, utilizando la tecnología no para reemplazar al factor humano, sino para amplificar su capacidad de supervisión, transparencia y toma de decisiones informada.

Seguridad ofensiva: pensar como quien intenta hacer trampa

El Proctoring con IA solo es tan sólido como la capacidad de anticipar los métodos que los estudiantes pueden emplear para eludir la vigilancia.

Modelado de amenazas desde el diseño

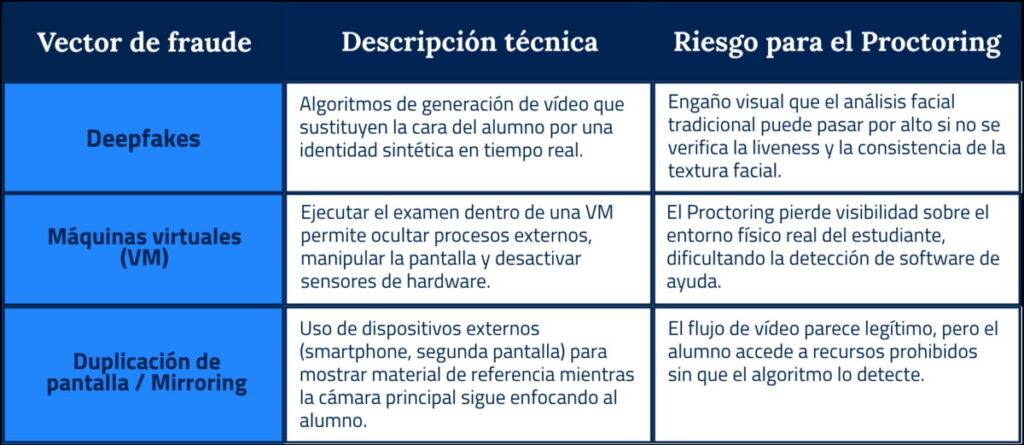

Antes de lanzar cualquier examen, se realiza un threat‑modeling que identifica los vectores de ataque más probables (deepfakes, máquinas virtuales, duplicación de pantalla, uso de scripts externos). Cada vector se asigna a una contramedida específica y se documenta en un plan de mitigación que forma parte del ciclo de vida del Proctoring. Este enfoque evita que la arquitectura se convierta en un parche reactivo.

Arquitectura “Zero Trust” para el entorno de examen

En un modelo Zero Trust, ningún componente se confía por defecto. Cada capa hardware, sistema operativo, red y aplicación de Proctoring se verifica en tiempo real mediante:

- Atestación criptográfica del hardware (TPM, Secure Enclave) que garantiza que el examen se ejecuta en un dispositivo no manipulado.

- Validación de integridad del firmware mediante firmas digitales que se comparan con una base de confianza.

- Control de procesos que registra hashes de cada proceso activo y los confronta con una lista blanca; cualquier desviación dispara una alerta inmediata.

Red‑Team interno y simulación de ataques

Los equipos de seguridad de Open Sistemas actúan como red‑team que, bajo condiciones controladas, intentan vulnerar el Proctoring utilizando:

- Generación de deepfakes en tiempo real para suplantar la identidad del examinado.

- Creación de máquinas virtuales ocultas que ocultan procesos de ayuda.

- Screen‑mirroring con dispositivos externos para inyectar contenido prohibido.

Los resultados de estas simulaciones se retroalimentan al motor de detección, actualizando firmas y afinando los umbrales antes de la puesta en producción.

Evidencias inmutables y auditoría continua

Cada fotograma, registro de audio y metadato de sesión se hash‑ea en tiempo real y se almacena en un ledger inmutable. Este registro permite:

- Detectar cualquier alteración posterior al examen.

- Proveer una cadena de custodia verificable para auditorías académicas y regulatorias.

- Reducir la dependencia de revisiones manuales al ofrecer pruebas criptográficas de integridad.

Actualización proactiva de contramedidas

Los algoritmos de detección de deepfake y de procesos sospechosos se entrenan con datasets actualizados semanalmente, garantizando que el Proctoring mantenga una alta tasa de detección frente a técnicas emergentes.

Una estrategia de seguridad ofensiva convierte al Proctoring con IA en una arquitectura resiliente que anticipa y neutraliza los intentos de fraude antes de que comprometan la integridad del examen. Al combinar modelado de amenazas, Zero Trust, red‑teaming, evidencias inmutables y actualización continua, Open Sistemas ofrece una solución de Proctoring que piensa como el atacante y, por tanto, protege de manera proactiva la validez académica y profesional de cada evaluación.

Reflexión final: Más allá de vigilar: ¿es este el modelo de evaluación del futuro?

En la última década, cientos de universidades han migrado sus exámenes a entornos digitales y, pese a la adopción masiva del Proctoring con IA, siguen reportando episodios de fraude que comprometen la validez de sus titulaciones. El problema no radica únicamente en la detección de trampas, sino en la dependencia de un modelo de control estático que no evoluciona con la forma en que se concibe el aprendizaje.

Si el Proctoring se mantiene como única barrera, reforzamos un paradigma de vigilancia que limita la innovación pedagógica. Alternativas como los exámenes open‑book, las evaluaciones adaptativas y la validación continua de competencias ofrecen una ruta para medir la verdadera comprensión, desplazando el foco de “evitar el engaño” a “demostrar habilidades”.

Para pasar de un control reactivo a una evaluación digital sostenible y basada en competencias, estamos listos para diseñar la infraestructura que lo haga posible. Hablemos y construyamos juntos el futuro del Proctoring y la evaluación educativa.