¿Qué sucede cuando una empresa necesita aprovechar al máximo los LLMs, pero se enfrenta a la complejidad de gestionar múltiples modelos con distintos requisitos? Cada modelo tiene sus propias particularidades, lo que dificulta la integración y obliga a los equipos técnicos a invertir tiempo y recursos en adaptar y administrar sistemas diversos. Además, coordinar la comunicación entre modelos y garantizar la precisión en los resultados puede convertirse en un proceso engorroso y costoso que desvía el enfoque de la innovación.

Aquí es donde entra LiteLLM: una biblioteca de código que actúa como un intermediario sofisticado, facilitando el acceso a diferentes modelos. LiteLLM traduce y coordina las solicitudes de manera automática, transformando la gestión de LLM en un proceso fluido y accesible. Así, elimina las barreras técnicas y permite a las organizaciones enfocarse en lo que realmente importa: la obtención de resultados y la creación de valor.

Nota: Este no es un artículo patrocinado por LiteLLM; se basa en mi experiencia personal utilizando la aplicación. El propósito de este escrito es proporcionar información comprensiva y accesible sobre LiteLLM, en línea con la misión del open source de hacer disponible la información sobre software para todos.

¿Por qué LiteLLM?

En el rápido entorno evolutivo de la inteligencia artificial, los Modelos de Lenguaje Grandes (LLMs) se han convertido en herramientas indispensables tanto para desarrolladores como para organizaciones. Sin embargo, integrar estos poderosos modelos en aplicaciones puede ser una tarea compleja, especialmente cuando se trata de trabajar con múltiples proveedores y sus APIs únicas. Es aquí donde entra LiteLLM, ofreciendo una solución revolucionaria para la integración de LLMs.

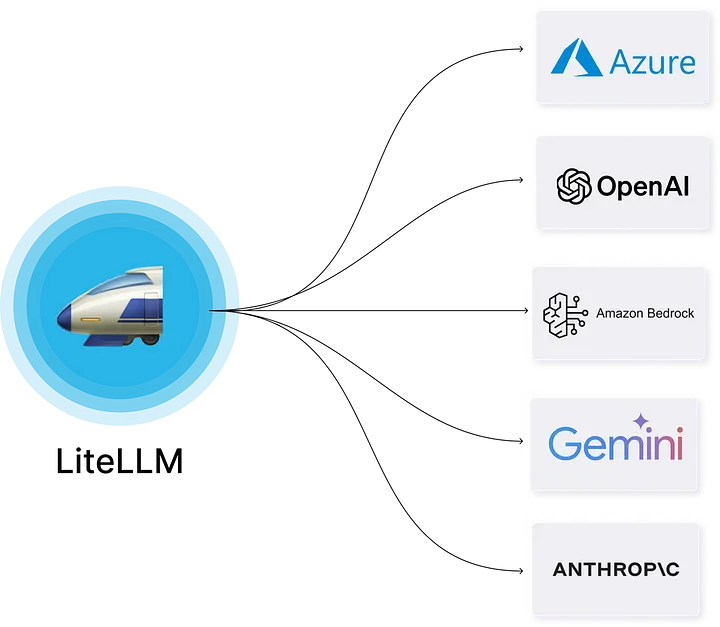

LiteLLM es un marco de código abierto diseñado para simplificar el proceso de trabajo con modelos de lenguaje grandes. Proporciona una interfaz unificada para interactuar con más de 100 diferentes LLMs de diversos proveedores, incluyendo gigantes del sector como OpenAI, Anthropic, Google o proveedores locales como [Ollama](https://ollama.com/). Esto significa que los desarrolladores pueden cambiar fácilmente entre modelos o utilizar múltiples modelos en sus aplicaciones sin tener que aprender e implementar diferentes estructuras de API para cada proveedor.

En su núcleo, LiteLLM actúa como un traductor universal entre tu aplicación y el diverso mundo de LLMs, unificando todas las APIs y proporcionando una interfaz única compatible con OpenAI. Esto permite a los desarrolladores centrarse en la lógica y rendimiento de sus aplicaciones sin incurrir en la complejidad técnica asociada con cada modelo específico.

Diversidad de LLMs: Un ecosistema en constante evolución

El ámbito de los LLMs está en constante exposición, con la aparición de nuevos modelos y proveedores. Cada uno de estos modelos está diseñado con características específicas, lo que les otorga distintas fortalezas y debilidades para diversas tareas y aplicaciones. Por ejemplo:

OpenAI: Reconocido por sus modelos GPT, que sobresalen en la generación de texto creativo y coherente, siendo altamente valorados en entornos donde se requiere redacción fluida.

Claude: Se centra en desarrollar modelos que priorizan y se alinean con valores humanos, lo que los hace ideales para aplicaciones donde la ética y la responsabilidad son esenciales.

SofIA: como middleware especializado, no es un LLM en sí, sino una solución que facilita la integración y uso eficiente de diversos LLMs, adaptándose a las necesidades específicas de cada organización.

Google Vertex AI: Proporciona una amplia gama de modelos preentrenados, además de la opción de entrenar modelos personalizados, permitiendo una gran flexibilidad y adaptación a necesidades específicas.

Hugging Face: Actúa como una plataforma de código abierto que alberga una amplia variedad de modelos de lenguaje, incluidos transformers y otras arquitecturas, fomentando la colaboración y la innovación.

Esta diversidad de LLMs representa una ventaja significativa en términos de opciones y capacidades, pero también introduce un desafío considerable: la variabilidad en las APIs y los formatos de solicitud de cada modelo puede complicar la integración en aplicaciones, aumentando el tiempo y los recursos requeridos para su implementación efectiva.

Empezando con LiteLLM

Instalación con Docker

Cuando se trabaja con cualquier marco de trabajo, siempre se recomienda usar la instalación de Docker que permite mantener toda tu configuración aislada:

# Get the code

git clone https://github.com/BerriAI/litellm

# Go to folder

cd litellm

# Add the master key - you can change this after setup

echo 'LITELLM_MASTER_KEY="sk-1234"' > .env

# Add the litellm salt key - you cannot change this after adding a model

# It is used to encrypt / decrypt your LLM API Key credentials

# We recommned - https://1password.com/password-generator/

# password generator to get a random hash for litellm salt key

echo 'LITELLM_SALT_KEY="sk-1234"' >> .env

source .env

# Start

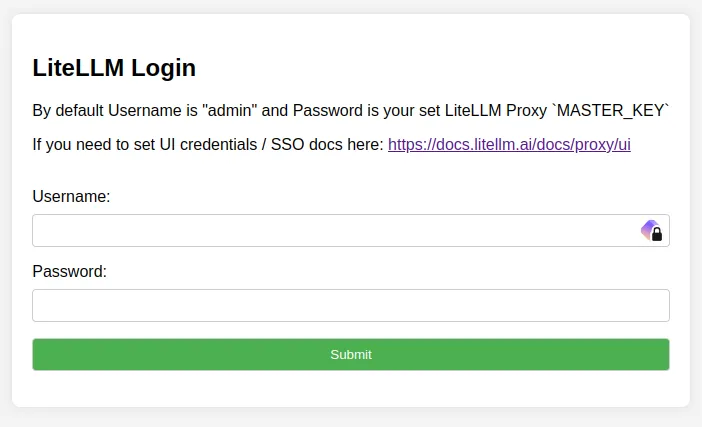

docker-compose upAhora puedes ir a http://localhost:4000 y registrar tu primer modelo usando la contraseña de clave maestra que estableciste en el archivo `.env` y el nombre de usuario admin (también puedes cambiar este parámetro).

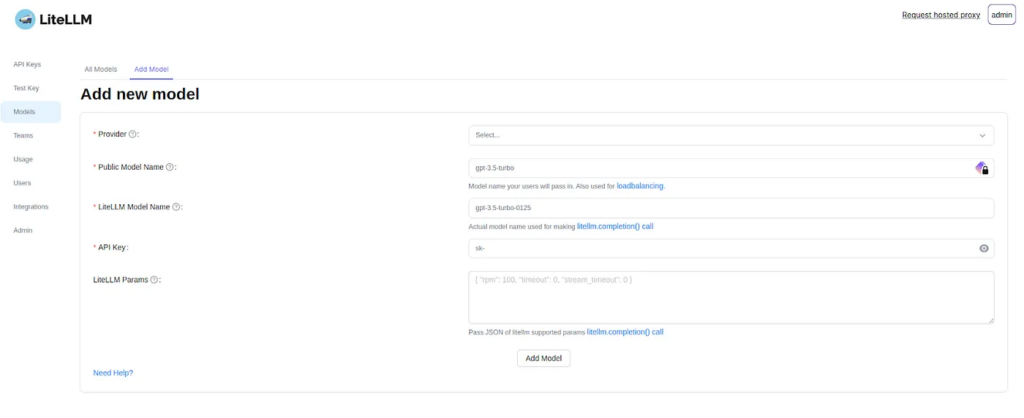

Registrar un nuevo modelo

Para registrar un nuevo modelo, solo ve a Modelos >> Añadir Modelo y luego encontrarás una pantalla donde puedes registrar los modelos para casi cualquier proveedor. También tienes la opción de poner cualquier nombre al modelo, añadir costos personalizados o añadir cualquier parámetro como tokens de entrada en la sección «Parámetros de LiteLLM».

Tienes una aplicación de demostración disponible para fines de demostración.

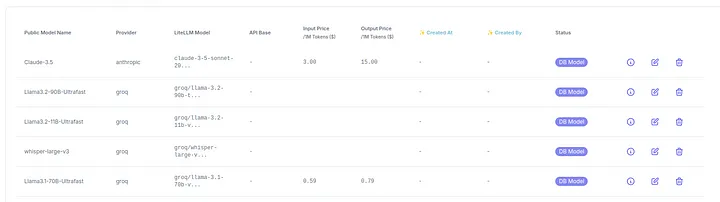

Registré un modelo Claude 3.5 y varios otros modelos de uno de mis proveedores de LLM favoritos, Groq

Como puedes ver en la imagen anterior, nombré el modelo de Groq como Llama3.2-90B-Ultrafast, aunque su nombre original es llama-3.2-90b-text-preview. ¡Groq me encanta! Ofrecen los tiempos de inferencia más rápidos que he visto, gracias a su innovador hardware llamado LPU (Unidad de Procesamiento de Lenguaje).

En próximos artículos te contaré más sobre este hardware. Ahora, sigamos hablando de LiteLLM.

¿Cómo hacer una request a LiteLLM?

Ahora que tenemos una API completamente compatible con OpenAI, podemos empezar a llamar a todos los modelos usando el mismo punto final y URL y solo cambiando el nombre del modelo, por ejemplo:

Python usando el SDK de LiteLLM en streaming

Cuando se usa LiteLLM, es crucial incluir el proveedor antes del nombre del modelo. El formato es model=»proveedor/nombre_del_modelo», como se demuestra en el siguiente código:

from litellm import completion

for chunk in completion(

base_url="http://yourlitellmurl", # http://localhost:4000 if you are working locally

api_key="sk-1234", # or your api_key

model="groq/Llama3.2-90B-Ultrafast", # Remember to use provider/model_name

messages=[{"role": "user", "content": "Write a short story about a robot learning to paint."}],

stream=True

):

print(chunk['choices'][0]['delta']['content'], end='', flush=True)Python usando el SDK de OpenAI en streaming

Cuando se usa el SDK de OpenAI, no necesitas especificar el proveedor al llamar al modelo. Simplemente usa el nombre del modelo como se muestra a continuación:

from openai import OpenAI

client = OpenAI(base_url="http://yourlitellmurl", # http://localhost:4000 if you are working locally

api_key="sk-1234")

stream = client.chat.completions.create(

model="Llama3.2-90B-Ultrafast", # Check you don't have to provide

messages=[{"role": "user", "content": "Write a short story about a robot learning to paint."}],

stream=True

)

for chunk in stream:

if chunk.choices[0].delta.content is not None:

print(chunk.choices[0].delta.content, end="", flush=True)Con Curl

Curl es una herramienta de línea de comandos para transferir datos especificados con sintaxis URL, muy común y fácil de usar en cualquier terminal.

curl -X POST "http://yourlitellmurl/v1/chat/completions" \

-H "Content-Type: application/json" \

-H "Authorization: Bearer sk-1234" \

-d '{

"model": "Llama3.2-90B-Ultrafast",

"messages": [{"role": "user", "content": "Write a short story about a robot learning to paint."}],

"stream": true

}' \Estandarización: Impulsando la productividad empresarial

Para abordar los desafíos asociados con la diversidad y complejidad de los LLMs, la creación de una capa de abstracción es esencial para optimizar la integración y operación. Esta capa debe:

Ofrecer una interfaz común: Simplifica el acceso mediante una API unificada que permite interactuar con todos los modelos compatibles, eliminando la necesidad de aprender múltiples sistemas.

Ocultar la complejidad y técnica: Gestiona automáticamente aspectos como la autenticación, el formato de las solicitudes y el procesamiento de las respuestas, permitiendo a los equipos técnicos centrarse en tareas de alto valor.

Facilitar la adaptación de modelos: Permite alternar fácilmente entre diferentes modelos, promoviendo la experimentación y selección del más adecuado para cada necesidad, mejorando la eficiencia y la calidad de las soluciones.

LiteLLM responde a estas necesidades al proporcionar una solución práctica y eficiente para la integración de múltiples LLMs. Con una interfaz unificada, LiteLLM simplifica el acceso a diversos modelos, permitiendo a los desarrolladores concentrarse en la lógica y el rendimiento de sus aplicaciones. Al abstraer la complejidad técnica de cada modelo, LiteLLM elimina las barreras relacionadas con el manejo específico de APIs y facilita la adopción de modelos de lenguaje en proyectos empresariales, optimizando los flujos de trabajo y acelerando el tiempo de desarrollo

Características clave de LiteLLM

Soporte multi-proveedor: Desbloqueando nuevas oportunidades

LiteLLM se diferencia por su capacidad de integrar una amplia gama de proveedores de LLMs, lo cual otorga a las empresas una ventaja estratégica al poder seleccionar el modelo que mejor se adapte a sus necesidades específicas en cada momento. Esta flexibilidad permite a las organizaciones no solo aprovechar las fortalezas únicas de diferentes modelos, sino también adaptarse rápidamente a nuevas exigencias del mercado. Con LiteLLM, la adopción de LLMs no está limitada a un solo proveedor; las empresas pueden experimentar con diversas opciones, desde la generación de texto avanzada hasta la alineación en temas de seguridad y personalización, maximizando así su impacto en el entorno empresarial

¿Por qué es importante esta característica?

- Flexibilidad: Permite elegir el modelo que mejor se adapte a cada situación, sin necesidad de modificar el código subyacente.

- Experimentación: Facilita la prueba de múltiples modelos para encontrar la mejor opción para cada caso de uso, optimizando resultados.

- Resiliencia: Si un proveedor enfrenta inconvenientes, LiteLLM facilita el cambio a otro modelo sin causar interrupciones significativas en las operaciones, asegurando continuidad y estabilidad.

Gestión de autenticación y proxies: seguridad y cumplimiento en primer plano

La seguridad y la conformidad son pilares esenciales al trabajar con modelos de lenguaje, especialmente cuando se trata de datos sensibles. LiteLLM aborda estas necesidades críticas mediante una gestión centralizada de autenticación y configuración de proxies, ofreciendo beneficios clave para el entorno corporativo:

Autenticación segura: LiteLLM permite establecer y gestionar las credenciales de acceso para distintos proveedores de LLMs de manera centralizada y segura, garantizando que solo usuarios autorizados tengan acceso a los modelos, lo que reduce riesgos de seguridad asociados con el uso de múltiples credenciales.

Configuración de proxies: LiteLLM admite la configuración de proxies para enrutar el tráfico de red a través de servidores intermediarios. Esto proporciona varias ventajas:

- Mayor seguridad: Protege las credenciales y datos sensibles al enrutar el tráfico mediante una red privada o controlada, evitando el acceso no autorizado.

- Cumplimiento normativo: Ayuda a las empresas a cumplir con las normativas de seguridad y privacidad al direccionar el tráfico a través de una red corporativa, asegurando que los datos sean manejados conforme a las políticas vigentes.

- Optimización de costos: Facilita la reducción de costos de red al consolidar y optimizar múltiples solicitudes mediante el uso de proxies, maximizando la eficiencia del tráfico de datos.

Con estas funcionalidades, LiteLLM no solo simplifica la gestión de LLMs en entornos empresariales complejos, sino que también refuerza la postura de seguridad y cumplimiento normativo, adaptándose a las exigencias del entorno tecnológico y regulatorio actual.

Seguridad, beneficios y gestión de datos: protección integral en el entorno de IA

La seguridad y la privacidad son prioridades absolutas en el desarrollo de aplicaciones impulsadas por IA, especialmente cuando se manejan datos confidenciales. LiteLLM aborda estas necesidades críticas a través de un enfoque robusto en la protección y gestión de datos, ofreciendo características clave para reforzar la confianza y el cumplimiento normativo:

Gestión segura de credenciales: LiteLLM almacena las credenciales de acceso de manera segura, garantizando que no se expongan accidentalmente. Esta protección evita riesgos de acceso no autorizado y asegura la integridad de la conexión con los modelos.

Encriptación de datos: Los datos transmitidos y almacenados son encriptados utilizando técnicas avanzadas, lo que salvaguarda la información sensible frente a posibles filtraciones o accesos indebidos, manteniendo la privacidad y la seguridad en todo momento.

Cumplimiento normativo: LiteLLM facilita el cumplimiento de normativas clave de seguridad y privacidad, como el Reglamento General de Protección de Datos (GDPR) y la Ley de Privacidad del Consumidor de California (CCPA), asegurando que las prácticas de manejo de datos cumplan con los estándares internacionales.

Control de acceso: La plataforma permite definir roles y permisos personalizados, ofreciendo un control detallado sobre quién puede acceder a los modelos y datos. Este enfoque garantiza que solo las personas adecuadas tengan acceso a la información relevante, mejorando la gobernanza y reduciendo el riesgo de uso indebido

Configuración e implementación de LiteLLM

Para comenzar con LiteLLM, es fundamental cumplir ciertos requisitos y realizar una configuración técnica inicial que garantice un funcionamiento óptimo y seguro en entornos empresariales. A continuación, se detallan los pasos esenciales:

Requisitos previos

Python: LiteLLM está basado en Python, por lo que es necesario tener una versión compatible instalada en el sistema. Python es el lenguaje que permite ejecutar el software y gestionar las integraciones con los modelos de lenguaje.

Gestión de paquetes: Un gestor de paquetes como pip es indispensable para instalar las dependencias necesarias, incluyendo LiteLLM y cualquier otra biblioteca complementaria que facilite la conexión con los modelos de LLM.

Editor de código: Un entorno de desarrollo integrado (IDE) o editor de texto como Visual Studio Code o PyCharm es recomendable para la escritura y ejecución del código Python, lo que mejora la productividad y facilita la depuración.

Cuentas en proveedores de LLM: Si planeas integrar modelos de distintos proveedores (OpenAI, Anthropic, Hugging Face, etc.), es fundamental tener cuentas en dichos servicios y obtener las claves de API necesarias para la autenticación y el acceso a los modelos.

Configuración de variables de entorno y seguridad

Para asegurar una integración segura y eficiente con LiteLLM, es necesario configurar variables de entorno que definan las credenciales y parámetros operativos.

Claves de API: Deben configurarse las claves de API correspondientes a los proveedores de LLM en uso. Estas credenciales permiten la autenticación con los servicios externos y son esenciales para realizar llamadas a los modelos.

Variables de configuración: Es posible que se necesiten variables adicionales, tales como el modelo por defecto, la región geográfica de los servicios, y otros parámetros de configuración que optimicen el rendimiento y la conectividad.

Esta configuración técnica permite una implementación fluida de LiteLLM, brindando a las empresas la capacidad de aprovechar la inteligencia de los LLM de manera segura y con una gestión centralizada.

Uso de Docker Compose para la orquestación

Docker Compose es una herramienta estratégica para gestionar aplicaciones que requieren múltiples servicios en contenedores. Su integración con LiteLLM permite implementar y administrar la instancia de forma ágil y escalable, adaptándose a las necesidades de la organización.

Beneficios clave

Aislamiento mejorado: Cada servicio se despliega en su propio contenedor, lo que incrementa la seguridad y reduce el riesgo de interferencia entre componentes, proporcionando un entorno estable y controlado.

Reproducibilidad y estandarización: La configuración de la aplicación se documenta en un archivo YAML, facilitando la reproducción del entorno en distintas máquinas o etapas del ciclo de desarrollo, garantizando consistencia y eficiencia.

Escalabilidad sin complicaciones: Es posible ajustar la capacidad de los servicios aumentando el número de contenedores, lo que simplifica la adaptación a cambios en la demanda, optimizando recursos sin interrumpir la operación.

El uso de Docker Compose con LiteLLM ofrece una solución robusta para la orquestación, combinando facilidad de uso con una capacidad de respuesta empresarial dinámica.

Reflexión

Es evidente que estamos en un punto de inflexión en el desarrollo de la inteligencia artificial. LiteLLM no solo emerge como una herramienta clave en esta transformación, sino que también representa una puerta de entrada para que empresas de todos los tamaños accedan a tecnologías que antes parecían reservadas para unos pocos.

Su capacidad para integrarse con diversas herramientas y frameworks se convierte en un activo indispensable. Al permitir el fine-tuning de modelos directamente desde la plataforma, LiteLLM no solo optimiza la experiencia del usuario, sino que también democratiza el uso de LLMs, adaptándolos a las necesidades específicas de cada organización.

En este sentido, SofIA se presenta como una plataforma de middleware ideal para facilitar la implementación de LLMs en entornos empresariales. Su fortaleza radica en la capacidad de conectar aplicaciones con una variedad de LLMs, haciendo que la integración y el uso de estas tecnologías sean más accesibles.

Explora cómo LiteLLM y SofIA pueden ser aliados estratégicos para mejorar la eficiencia de tu organización y maximizar el valor de los LLMs. Habla con nuestro equipo para descubrir cómo integrar estas herramientas efectivamente en tus operaciones y lograr una transformación digital exitosa.